"Sapphire Rapids": Intels Xeon-CPUs für Server und Rechenzentren angekündigt

Intel bringt die "4th gen Xeon Scalable Processors" in Stellung. Viele Spezialfunktionen sollen die bis zu 60 CPU-Kerne entlasten.

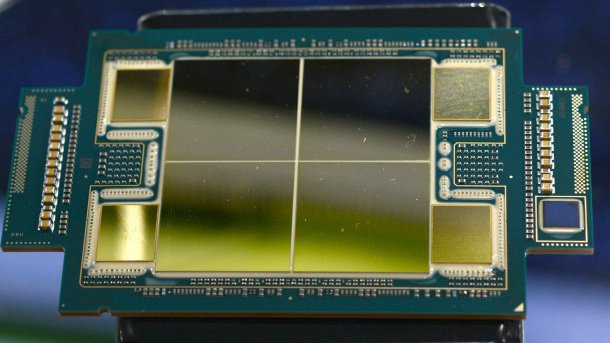

(Bild: Carsten Spille / c't)

Die vierte Generation skalierbarer Xeon-Prozessoren steht in den Startlöchern: Intel hat 52 verschiedene Modelle des Xeon SP Gen 4 alias Sapphire Rapids mit 8 bis 60 Kernen in Planung. Sie kosten von 415 bis 17.000 US-Dollar, darunter sind viele Spezialtypen etwa für IoT und High-Performance-Computing. Doch die Zauberzutat – oder je nach Sichtweise der Notnagel – sind integrierte Beschleunigerfunktionen, mit denen Intel die Allzweckrechenkerne entlasten will und die hohe Rechenleistung versprechen.

Die Modellvielfalt verwirrt auf den ersten Blick. So sind die Xeons je nach Performance als Platinum (8400), Gold (6400), Silver (5400) und Bronze (3400) sowie neuerdings Max (9400) klassifiziert. Die zweite Ziffer der Modellbezeichnung steht für die Generation und ist daher durchweg „4“. Etliche Modelle tragen dazu noch ein Kürzel für den gedachten Einsatzzweck: So steht das „H“ für die 8-Sockel-Version, das „U“ für 1-Sockel-Xeons. Außerdem gibt es noch „S“ für Storage und „N“ für Netzwerke und 5G. Allgemeine 2-Sockel-CPUs können wie die Max-Versionen einfach nur eine Nummer haben. Die 8-Sockel-H-Varianten mit allen Beschleunigern sind mit Abstand am teuersten – vor allem wohl, weil es in diesem Segment keine Konkurrenz von AMD gibt; der Epyc läuft nur einzeln oder paarweise.

Die neuen Xeons sollen das Wachstum der Epyc-Marktanteile in Rechenzentren und Servern bremsen. Endlich hat Intel die Xeon-Plattform modernisiert und bietet außer mehr auch schnelleren Speicher im DDR5-Standard, CXL- und Optane-Unterstützung sowie bis zu 80 PCIe-5.0-Lanes für SSDs und Beschleunigerkarten. Die mit „Intel 7“-Technik, also in 10-Nanometer-Fertigung, hergestellten Prozessoren schlucken unter Volllast je nach Modell 125 bis maximal 350 Watt, sind unter Volllast also knapp 30 Prozent stromdurstiger als ihre Vorgänger.

(Bild: Carsten Spille / c't)

Auswahl aus drei Chips

Intel fertigt zunächst drei verschiedene Chips. Für den Einstieg handelt es sich um einen monolithischen 34-Kerner alias "Medium Core Count" (MCC). Bei den High-End-Varianten nutzt Intel hingegen ein Design mit nur 15 Kernen, bezeichnet es aber trotzdem als "Extreme Core Count" (XCC). Denn bis zu vier von ihnen werden durch die "Embedded Multi-Die Interconnect Bridge" (EMIB) miteinander verbunden.

Videos by heise

Die dritte Xeon-Variante ist für die "Xeon CPU Max Series" gedacht und besitzt zusätzlich zu den DDR5-Speichercontrollern auch welche für 64 GByte des Hochgeschwindigkeitsspeichers HBM2e. Die Xeon CPU Max sind für High Performance Computing, wie zum Beispiel im Supercomputer Aurora, und für extrem transferratenhungrige Anwendungen gedacht und können auch ganz ohne DDR5-Speicher betrieben werden. Alternativ dient der HBM als schneller, transparenter Cache für den Hauptspeicher oder – mit etwas Programmieraufwand – als separater Speicherbereich. Im Speicher-Benchmark Stream Triad erreichen die Xeon Max laut Intel eine dreieinhalbmal so hohe Transferrate wie die Modelle mit DDR5-Speicher, in echten Anwendungen bliebe davon noch eine Steigerung bis zum 2,3-Fachen übrig.

Während die Xeon Max nur für 1- und 2-Sockel-Systeme validiert werden, wird es die monolithischen MCC-Versionen für bis zu vier Sockel und die XCC-Varianten auch für 8-Sockel-Systeme geben.