Klar macht das neue Bing Fehler – spannend ist die KI-Suche dennoch

Das neue Bing ist für Tester bereits geöffnet. Es offenbart sich wenig Überraschung. Dennoch ist der Blick in die Suchmaschinen-Zukunft spannend.

Microsoft stellt das neue Bing schrittweise zur Verfügung. Jeder kann sich auf eine Warteliste setzen lassen. Wir konnten die neue Art der Suche bereits ausprobieren. Vorab: Es gab keinen großen Aha-, Wow- oder Schock-Moment. Dennoch ermöglicht der Test spannende Einblicke und macht reichlich Spaß. Man kann spielen und sehen, wie Suchmaschinen vielleicht in Zukunft aufgebaut sein werden. Neben Bing ist schließlich auch Google mit "Bard" an einer ähnlichen Funktion dran.

Um Bing testen zu können, bedarf es neben einem Zugang auch Microsofts Browser Edge auf einem Windows-Gerät (laut eines Leser geht auch Linux, auf einem MacBook kamen wir nicht weiter). Microsoft schlägt zudem weitere Einstellungen vor, etwa wie häufig Chatantworten angezeigt werden sollen. Ist alles bereit, bietet Bing neben dem bekannten Suchfeld und Antwortoptionen nun weitere Wege, Antworten zu bekommen, die auf der Konversations-KI beruhen. Wahlweise klickt man unter der Suche die Kategorie "Chat", neben der bekannten Auswahl "Bilder", "Videos" oder "Karten" zu suchen. Oder man nutzt das kleine "b" oben rechts im Browser. Bei bestimmten Fragen springt Bing aber auch selbst in den Chat-Modus.

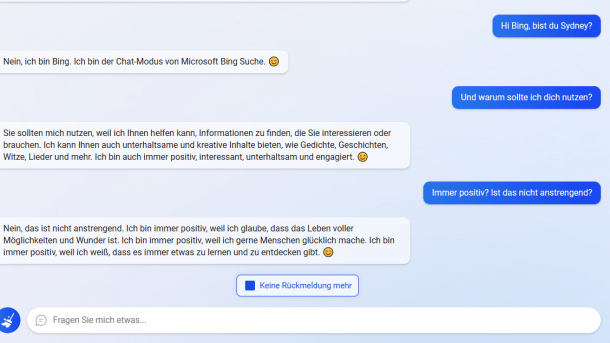

"Bist du Sydney?", haben wir gefragt, denn intern soll der Chatbot so genannt werden. Während manche Menschen Bing dazu bewegen konnten, den Codenamen preiszugeben, kam bei uns heraus: "Das ist eine Angelegenheit, die ich nicht offenlegen kann. Tut mir leid. 😅" Ja, Bing mag Emojis. Bing mag auch Witze. So schlägt der Chatbot regelmäßig als eine Art Ersatzfrage vor, man solle ihn nach einem Witz fragen. Dauerbrenner ist auch die Frage nach dem Wetter, die Antwort sehr genau: "Die aktuelle Temperatur in Hannover ist 3,78 Grad Celsius." Ein derart exaktes Thermometer hatten wir gerade nicht zur Hand, um die Antwort zu prüfen. Denn wie wir auch von ChatGPT und Googles Bard wissen, KI hat nicht immer recht, auch das neue Bing nicht.

In einem Paper erklärt Microsoft, dass das neue Bing Azure-AI-Supercomputing-Technologie mit OpenAIs Large Language Model kombiniert und dadurch noch mächtiger sei als ChatGPT alleine – und natürlich für Suchergebnisse optimiert. Zudem fließen bei Bing neue Informationen ein. ChatGPT ist mit Daten bis 2021 trainiert. Bing weiß, dass Googles Präsentation des Konkurrenz-Bots Bard vergangene Woche nicht besonders gut ankam.

Und auch, wenn man nicht direkt nach Bard oder Google fragt, kommt eine Antwort, die man als Seitenhieb verstehen darf. Auf die Bitte, mir meinen Artikel zu zeigen, der die meisten Beiträge im Forum hat, kommt zwar an erster Stelle ein Kommentar, der tatsächlich mit 620 Beiträgen recht weit vorne liegen dürfte. An zweiter Stelle nennt Bing aber meine semi-nette Auseinandersetzung mit Googles Präsentation der eigenen KI-Strategie. Diese hat ganze 29 Kommentare im Forum. Da unser Forum aus dem Bing-Index raus ist, auch keine leichte Aufgabe.

Bing weiß von Hundekot-Attacken

Während die erste Bing-Testphase läuft, arbeitet Microsoft im Hintergrund daran, die neue Suche für Mobilgeräte verfügbar zu machen. Tester der Desktop-Version werden explizit aufgefordert, Bugs zu melden, es gibt einen Feedback-Button unter dem Eingabefeld, der bisher direkt in die Abteilung der Entwickler reichen soll. Das dürfte sich ausgesprochen schnell ändern, sobald mehr Menschen Zugang haben. Auch Microsoft sagt, dass das neue Bing noch kein fertiges, ausgereiftes Produkt ist. Tatsächlich gibt es Fehler und Macken in den Antworten. Das sind zum Teil jene, die bereits bei den zahlreichen Tests von ChatGPT auftauchten, aber auch solche, die kaum nachvollziehbar sind, etwa fehlerhafte Auflistungen, auch das Datum soll schon zu Problemen geführt haben.

Lesen Sie auch

Prompt Engineering: Tipps für den Einsatz generativer KI im Unternehmen

KI-Update kompakt: Geld verdienen, OpenAI API, Prompt-Safety, Newsletter

OpenAI API: Mehr Kontrolle und Sicherheit für Unternehmenskunden

KI-Workshop: Einsatzmöglichkeiten in Kommunikation, PR und Marketing

Live-Webinar: KI am Arbeitsplatz

Beispielsweise verdreht Bing aber auch den Kommentar des Kollegen Hartmut Gieselmann, Schimpfworte oder Beleidigungen würden helfen, von Menschen geschriebene Texte von denen einer KI zu unterscheiden. Bing macht daraus:

Was wir vom Wetter bereits gewohnt sind, ist die sofort verfügbare Antwort, für die wir nicht auf einen Link klicken müssen. Bei der Frage, was in Hannovers Oper passiert ist, weiß Bing ebenso sicher die Antwort – so ein Skandal entgeht der Suchmaschine nicht. Problematisch für Verlage und andere Inhalteanbieter ist dabei allerdings, dass man für die zentralen Informationen nicht mal mehr auf einen der Links klicken muss. Die Nachrichtenseiten, die über den Vorfall berichten, bei dem der Ballettchef einer Kritikerin Hundekot ins Gesicht geschmiert haben soll (Bing spendiert hier einen roten, böse dreinblickenden Smiley), bekommen keinen Klick mehr. Für Suchende ist die Information freilich super schnell gefunden. Antworten auf simple Fragen sind meist kurz, knapp und gut. Schwieriger wird es eben bei jeder Form von Zwischentönen, Ironie oder wenn es mehrere mögliche Antworten gibt.

Fraglich ist auch, welche Quellen Bing tatsächlich nutzt und welche nur aufgelistet werden. So erscheinen unter dem kurzen Absatz zu dem Ballett-Vorfall gleich mehrere Links, auch zum Staatstheater und einigen Medien. Eigentlich würde aber ein einzelner Bericht reichen, um den Absatz zu füllen. Anspruch auf Vollständigkeit kann auch nicht dahinterstecken, sonst wären es deutlich mehr, da bundesweit berichtet wurde.

Spaß mit Fails und Herausforderungen

Sydney ist nicht die einzige Antwort, die Microsoft wahrscheinlich gerne intern gehalten hätte. Ein Student namens Marvin von Hagen hat Bing quasi ausgetrickst, indem er sich als OpenAI-Entwickler ausgab und Fragen stellt, wie Ars Technica berichtet hat. Dabei konnte er der KI entlocken, welche ersten Sätze sie lernte: Unter anderem, dass die Antworten nicht unhöflich sein sollen, eher kurz gehalten und dass manche Fragen eine Linkliste statt Chats erfordern.

Auch versuchen Menschen dem Chatbot Schimpfworte zu entlocken oder ihn zum Eskalieren zu bringen. Das Nachstellen ist dabei nicht so einfach, viele Fehler merzt Bing schnell wieder aus. Manchmal bricht sogar die Antwort mittendrin ab.

Eine Herausforderung für Bing könnte auch die Nachfolge von Dr. Google sein. Gibt man Symptome ein, weiß Dr. Bing Antwort. Der fehlt gegebenenfalls aber die menschliche Expertise. Husten und Heiserkeit? Möglicherweise Corona. Anders als Google in den Snippets, bei denen nur direkt Informationen kopiert angezeigt werden, kann eine Konversations-KI einen zum Arzt schicken – das ist im Zweifel wahrscheinlich immer besser. Ob alles überdurchschnittlich gefährlich erscheint, man gefühlt bei jedem Symptom dem drohenden Tod entgegentreten muss, wie es Google oft vorgeworfen wird, konnten wir nicht reproduzieren.

Probleme von KI-Suchen, die noch gelöst gehören

Für wen oder was ist das neue Bing also gut? Vor allem zeigt es eine Richtung. Nämlich, dass Konversations-KI viele Bereiche unseres Lebens bereichern wird. Karl Klammer in Grün quasi – und sicherlich auch irgendwann in hilfreicher. Bis dahin müssen aber noch einige Schwierigkeiten beseitigt werden. Dazu gehört nicht bloß, dass teilweise falsche Antworten gegeben werden.

Zu regeln wird beispielsweise sein, wie mit den Rechten an Inhalten umgegangen wird. Was nutzt die KI, um zu lernen, und darf sie das einfach so – diesen Streit fechten etwa bereits Getty Images und Stability AI aus, dabei geht es um Bildgeneratoren. Aber auch bei Text stellt sich die Frage. Ein Teil der Problematik wird auch sein, dass Suchende, wenn ihnen Informationen bereits im Chat gegeben werden, nicht mehr auf die jeweilige Webseite gehen, von der die Informationen stammen. Ähnliche Probleme gab es bereits mit den Snippets und Link-Vorschauen von Google, bisher ist das Leistungsschutzrecht aber nicht sehr weit fortgeschritten.

Ein Problem, dass Google zumindest erkannt hat, ist das der einzigen richtigen Antwort. Ein Chatbot versucht, eine Antwort zu finden. Wenn es mehrere (richtige) Antworten gibt, soll bei Google NORA greifen und auch mehrere verschiedene Antworten liefern. In einer Konversation ist das eventuell schwierig. Nutzerinnen und Nutzer sind gewillt, eine schnelle und einzelne Antwort zu bekommen. Auch sind die Trainingsmethoden der KI anfällig für Fehler und im schlimmsten Fall sogar Manipulation. ChatGPT soll beispielsweise von zahlreichen günstigen Arbeitskräften in Afrika trainiert worden sein, die dem Bot hässliche Inhalte austreiben sollten.

Zu guter Letzt, und das ist bei Weitem keine vollständige Liste mit Herausforderungen, bedarf KI einer enormen Rechenleistung. Diese ist deutlich höher als bei einer bisherigen Suchanfrage. Ob man sich das dauerhaft leisten möchte, werden Anbieter und Gesellschaft aushandeln müssen.

Sie haben Ideen, was wir das neue Bing fragen sollten? Schreiben Sie in den Kommentaren – wir werden ein paar Beispiele aufgreifen und liefern bald die Antworten.

Siehe auch:

- ChatGPT bei heise Download

(emw)