Blackwell: Nvidia enthüllt seine nächste KI-Beschleuniger-Generation

Die Blackwell-Beschleunigerarchitektur soll bis zu 2x so schnell sein wie AMDs MI300X und Nvidias Vormachtstellung bei KI-Chips für die nächsten Jahre festigen.

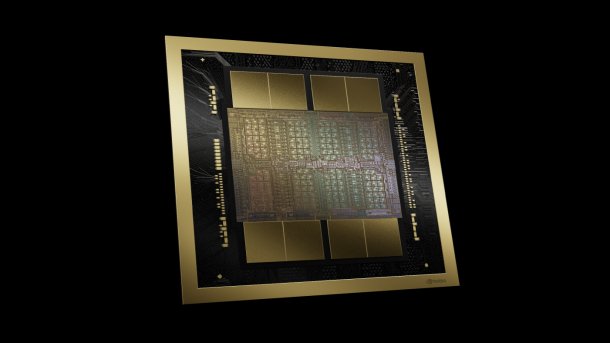

Nvidias gerenderter B100-Beschleuniger. Was hier kaum ersichtlich ist: Der Beschleuniger besteht aus zwei Chips nebst acht HBM3e-Stapeln.

(Bild: Nvidia)

Nvidias Hausmesse GTC 2024 im kalifornischen San José fand zum ersten Mal seit Jahren wieder in Präsenz statt und stand wenig überraschend voll im Zeichen künstlicher Intelligenz. Mit seinen Beschleunigerchips dominiert Nvidia derzeit den Markt für Rechenzentren und erwirtschaftet im Fahrwasser des KI-Booms ein finanzielles Rekordergebnis nach dem anderen.

Das soll dem Willen von Nvidia-Boss Huang auch so bleiben. Dabei spielt die neu vorgestellte Beschleunigerarchitektur Blackwell die zentrale Rolle in Form verschiedener Produkte, die vom B100 bis zum DGX GB200 SuperPOD im Laufe des Jahres auf den Markt kommen sollen. Auf dem Papier erreichen Blackwell-GPUs bei einigen Datenformaten den doppelten Durchsatz im Vergleich zu AMDs brandneuen MI300-Beschleunigern.

Mit der neuen Blackwell-Architektur und weiter reduzierten Datenformaten wie 4-Bit-Floating-Point sowie neuen Funktionen stehen vor allem die Energieeffizienz und der Datenaustausch zwischen den einzelnen Chips im Fokus. Darum haben auch der NVLink-Switch und die Netzwerktechnik ein Upgrade bekommen.

(Bild: c't)

Preise nennt Nvidia traditionell nicht und verweist dabei auf seine Partner, solange der KI-Hype aber unvermindert anhält, dürften sich die Chips nahezu unabhängig von der Preisgestaltung verkaufen. Amazon Web Services, Google Cloud und Oracle Cloud hat Nvidia jedenfalls schon als Kunden gewinnen können, gibt aber nicht genau an, ab wann Instanzen buchbar sein werden. Die älteren H100-Produkte laufen derweil weiter vom Band.

Blackwell-Doppelchip

Nvidia geht mit Blackwell neue Wege, bleibt sich auf gewisse Weise aber treu. Die Blackwell-“GPU“ besteht aus zwei einzelnen Chips. Zwar wollte Nvidia unsere Frage, ob die beiden funktional identisch sind, nicht beantworten, gab aber an, dass beide ans Limit der Belichtungsmöglichkeiten stoßen. Damit dürften sie jeweils um die 800 mm² groß sein und folglich einzeln in etwa so viel Fläche belegen wie die Vorgänger H100 (814 mm²) und A100 (826 mm²). Das Wort Chiplet fiel nicht, versteht man darunter in der Regel doch die Kopplung verschiedener Chips.

Die Blackwell-Chips lässt Nvidia in einem "4NP" genannten Prozess bei TSMC herstellen, der nicht der üblichen Nomenklatur der Schmiede entspricht. Ob es sich dabei um ein Derivat von N4P handelt und welche Charakteristika der Prozess besitzt, beantwortete Nvidia nicht – wir gehen jedoch von N4P aus, bei dem wie üblich ein paar Parameter nach Kundenwunsch justiert wurden.

Beide Chips, die Nvidia nur zusammen als Blackwell-GPU bezeichnet, sind über ein schnelles Interface mit 10 TByte pro Sekunde (5 TByte/s pro Richtung) untereinander verbunden. Laut Nvidia reicht das aus, damit sie sich auch performancemäßig wie eine einzelne GPU verhalten. Zum Vergleich: Beim Level-2-Cache als datenverbindender Instanz in Nvidias High-End-Grafikkarten GeForce RTX 4090 messen wir rund 5 TByte pro Sekunde, AMDs MI300-Beschleuniger-Chiplets sind mit bis zu 1,5 TByte/s untereinander verbunden.

192 GByte HBM3e-Speicher

Beim Speicher geht Nvidia in die Vollen und startet mit acht 24-GByte-Stapeln des schnellen HBM3e-Speichers. Insgesamt kommen so bis zu 192 GByte und 8 TByte/s Transferrate zusammen. In Sachen Speichergröße zieht die Firma so mit AMDs MI300X gleich, allerdings hat der B100 eine rund 50 Prozent höhere Transferrate – das Upgrade war auch nötig, denn gerade bei der Speichergröße hinkte Nvidias H100-Generation hinterher. Mit acht Stacks hat man theoretisch zudem die Möglichkeit, später auf 36-GByte-Stapel zu wechseln und auf 288 GByte Kapazität aufzustocken.

Zum internen Aufbau gab es bei der Vorstellung nur wenige Details. Leistungsdaten nannte Nvidia lediglich für die Tensor-Kerne, schwieg sich zu traditionellen Shader-Rechenwerken und weiteren Einheiten aber aus.

Für die Darstellung in der Tabelle haben wir auf die Durchsatzwerte mit Sparsity zurückgegriffen; mit dicht besetzten Matrizen halbieren sich die Teraflops-Angaben. Ausnahme: FP64, hier gibt Nvidia keinen Durchsatz mit Sparsity an.

| Beschleuniger für Rechenzentren und KI | ||||

| Name | GB200 | AMD MI300X | H100 | A100 |

| Architektur | 1x Grace + 2x Blackwell | CDNA3 | Hopper | Ada |

| Transistoren | 2x 104 Mrd. / 4NP / ~800 mm² | Diverse Chiplets mit 153 Mrd. / N5 + N6 | 80 Mrd. / 4N / 814 mm² | 54,2 Mrd. / N7 / 826 mm² |

| Format | Add-on-Board (2 pro 1U-Rack) / SXM | SXM5 | SXM5 | SXM4 |

| Jahr | 2024 | 2023 | 2022 | 2020 |

| TDP | 1200 Watt per GPU + 300 Watt Grace-CPU | 750 Watt | 700 Watt | 400/500 Watt |

| Speicher | 192 GByte HBM3e | 192 GByte HBM3 | 80 GByte HBM3 | 80 GByte HBM2E |

| Transferrate | 8 TByte/s | 5,3 TByte/s | 3,35 TByte/s | 2,04 TByte/s |

| GPU-GPU-Verbindung | NVLink Gen 5, 1,8 TByte/s | 896 GByte/s | NVLink Gen 4, 900 GByte/s | NVLink Gen 3, 600 GByte/s |

| Rechenleistung Tensor-Core per GPU (TFLOPS, mit Sparsity) | ||||

| FP64 (Teraflops) | 45 | 163 | 67 | 19,5 |

| FP32 (Teraflops) | k.Angabe | 163 | k. Angabe | k. Angabe |

| TF32 (Teraflops) | 2500 | 1307 | 989 | 312 |

| BF16 (Teraflops) | 5000 | 2615 | 1979 | 624 |

| FP8 (Teraflops) | 10000 | 5230 | 3958 | k. Angabe (INT8: 1248 TOPS) |

| FP4 (Teraflops) | 20000 | k.Angabe | k. Angabe | k. Angabe |

| Rechenleistung Shader-Cores per GPU (Teraflops) | ||||

| FP64 (Teraflops) | k.Angabe | 81,7 | 33,5 | 9,7 |

| FP32 (Teraflops) | k.Angabe | 163,4 | 66,9 | 19,5 |

| BF16 (Teraflops) | k.Angabe | k.Angabe | 133,8 | 39 |

| FP16 (Teraflops) | k.Angabe | k.Angabe | 133,8 | 78 |

FP4 und FP6

Neu bei Blackwell ist unter anderem Unterstützung für ein nur 4-bittiges Gleitkommaformat (FP4), zu dem es ein Research-Paper unter Mitarbeit eines Nvidia-Angestellten gibt, in der Transformer-Engine des Chips. Damit sollen Weights und Activations beim KI-Inferencing von Large Language Models (LLM) mit nur noch 4 Bit abgespeichert werden. Die Autoren behaupten "Unsere Methode kann zum ersten Mal sowohl die Gewichte als auch die Aktivierungen im LLaMA-13B-Modell auf nur 4 Bit quantisieren und erreicht eine durchschnittliche Punktzahl von 63,1 bei den Common-Sense-Zero-Shot-Reasoning-Aufgaben, was nur 5,8 Punkte niedriger ist als das Full-Precision-Modell und den bisherigen Stand der Technik um 12,7 Punkte deutlich übertrifft." FP4 könnte also mit nur noch relativ geringen Einbußen bei der Genauigkeit des Ergebnisses mit wesentlich weniger Daten hantieren, was außer der Verarbeitungsgeschwindigkeit auch die mögliche Modellgröße verdoppelt.

(Bild: c't)

Update: Während der Keynote verriet Nvidia-CEO Huang außerdem, dass auch FP6 eine Option darstellt. Dieses Format sorgt im Vergleich zu FP8 zwar nicht für zusätzlichen Rechendurchsatz, spart aber Speicher-, Cache- und Registerplatz und dadurch auch Energie.

Bei einem GPT-Modell mit 1,8 Billionen Parametern (engl.: "1,8T Params") will Nvidia mit einem GB200 bei sogenannter Mixture of Experts, also angepasster Rechen- und Datengenauigkeit, 30-mal so schnell sein wie ein H100-basiertes System und dabei 25-mal effizienter arbeiten. Nvidia gibt dabei an, die Performance auf eine GPU heruntergerechnet zu haben, vergleicht in der Realität aber ein System mit 8 HGX100 und 400G-Infiniband-Interconnect mit 18 GB200-Superchips (NVL36).

Aber auch mit dem etablierten FP8-Datenformat ist Blackwell auf dem Papier knapp doppelt so schnell wie AMDs MI300X und mehr als 2,5-mal so schnell wie der Vorgänger H100.