Verlässlichkeit: Wirtschaftsforscher beklagen Marktversagen bei generativer KI

ZEW-Ökonomen fordern ein EU-Programm für die Entwicklung sicherer generativer KI wie Chatbots. Derzeit wälzten OpenAI & Co. die gesellschaftlichen Risiken ab.

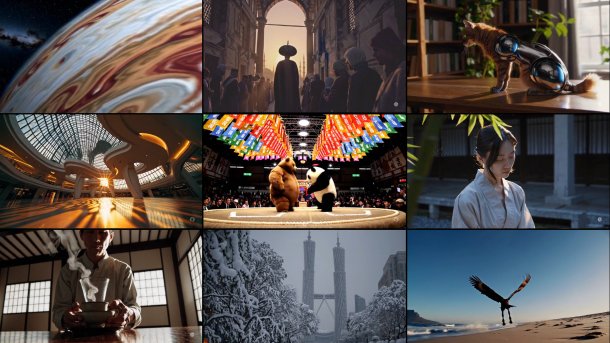

Homepage der Video-KI Sora von Open AI.

(Bild: Screenshot)

Politiker und Experten fordern allenthalben die Entwicklung "vertrauenswürdiger" Künstlicher Intelligenz. Doch Appelle und Verordnungen reichen laut Forschern des Leibniz-Zentrums für Europäische Wirtschaftsforschung (ZEW) nicht, um die derzeit besonders populären Chatbots und Bildgeneratoren von OpenAI, Google & Co. auf diese Spur zu bringen.

"Bei generativer KI beobachten wir ein Marktversagen", moniert Dominik Rehse, Leiter einer ZEW-Forschungsgruppe für das Design digitaler Märkte. Entwickler könnten aktuell "erhebliche Erträge durch leistungsfähigere Modelle generieren". Die Kosten für deren gesellschaftliche Risiken trügen sie aber nicht.

Um dieses Missverhältnis auszugleichen, schlagen die ZEW-Ökonomen in einem Politikbrief ein neues EU-Förderprogramm vor. Es soll explizit Anreize zur Entwicklung sicherer generativer KI schaffen.

"Die Sicherheit dieser Systeme stellt eine sozial erwünschte Innovation dar, die einzelne Entwicklerunternehmen bislang nicht ausreichend bereitstellen", begründet Rehse die Initiative. Ein ähnliches Problem existiere etwa bei der Produktion mancher Impfstoffe, "bei denen solche Förderprogramme bereits erfolgreich angewendet wurden".

Öffentlichkeit soll KI-Algorithmen prüfen können

Die Idee des Teams: Interessierte Entwickler nehmen an einem von der EU ausgeschriebenen und finanzierten Wettbewerb teil. In Etappen sollen Systeme vorangetrieben werden, die bestimmte Sicherheits- und weitere Leistungskriterien erfüllen. Wird ein Meilenstein erreicht, erhalten die entsprechenden Entwickler vorher festgelegte Geldbeträge.

So werden den Forschern zufolge die Nachfrageunsicherheiten auf Unternehmensseite reduziert: Die Branche wisse von Anfang an, dass sich der Aufwand für die Innovation auch lohne. Zugleich gebe die EU keine konkreten Technologien vor, sondern bleibe offen und mache wenige technische Vorgaben.

Videos by heise

Nötig sind der Gruppe zufolge aber "sorgsam definierte Sicherheits- und andere Leistungskennzahlen". Deren Robustheit dürfte sich vor allem durch den Einsatz von nachvollziehbaren Tests ergeben, bei denen die Öffentlichkeit auch KI-Algorithmen zu Fehlverhalten oder besonders guter Leistung auf den Zahn fühlen können müsste.

Mit solchen Anreizmechanismen habe die EU die Chance, "gezielter als bisher Innovationen zu entwickeln", betont Mitautor Sebastian Valet. "Sie könnte damit auch eine Nische im Markt für generative KI besetzen, in dem sie bislang nur eine geringfügige Rolle spielt."

(vbr)