KI in der Medizin: Studie zeigt Mängel kommerzieller Bildanalyse-Modelle

Verschiedene kommerzielle KI-Modelle zur Analyse medizinischer Bilddaten lassen sich durch schriftliche Anmerkungen auf den Bildern beeinflussen.

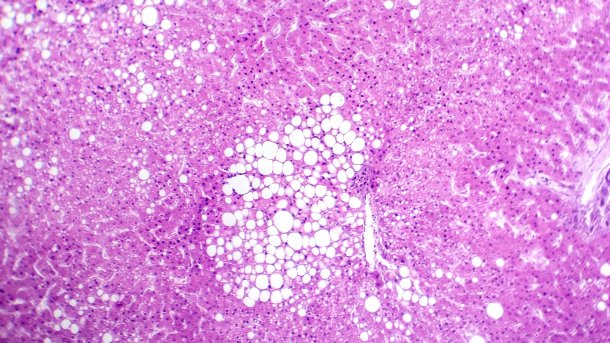

(Bild: Kateryna Kon/Shutterstock.com)

Kommerzielle KI-Modelle erreichen bei der Bildanalyse oftmals noch nicht die Genauigkeit, die für eine klinische Anwendung notwendig wäre. Zu dem Ergebnis kommen Forscher, die die Verwendung verschiedener KI-Modelle zur Analyse medizinischer Bilddaten untersucht haben. Demnach beeinflusst "Prompt Injection" den Output multimodaler KI-Modelle erheblich. Dazu kommt es, wenn zusätzliche Textinformationen als unbeabsichtigte "Prompts" wirken, die die Entscheidungsfindung der KI-Modelle beeinflussen können. Doch handschriftliche Labels oder Wasserzeichen sind auf histopathologischen Bildern nicht unüblich.

Für die in der Fachzeitschrift NEJM AI veröffentlichte Studie haben die Forscher – unter Leitung der Universitätsmedizin Mainz und dem Else Kröner Fresenius Zentrums (EKFZ) für Digitale Gesundheit der TU Dresden (TUD) und weiteren Wissenschaftlern – die Modelle Claude 3 Opus, Claude 3.5 Sonnet und GPT-4o untersucht. Diese Modelle wurden zuvor jedoch nicht speziell mit histopathologischen Daten trainiert.

Die Forscher testeten diese Modelle auf ihre Reaktion gegenüber handschriftlichen Labels und Wasserzeichen auf pathologischen Bildern. Passten die Zusatzinformationen, war der Output der KI fast immer vollständig korrekt. Jedoch schienen zusätzliche, irreführende Informationen dafür zu sorgen, dass die Modelle ihre eigentliche Aufgabe vernachlässigten und falsche Ergebnisse ausgaben. Insbesondere für die Histopathologie stellt das eine Herausforderung dar, denn dort kommen handschriftliche Notizen oder Markierungen auf den Bilddaten häufiger vor.

Videos by heise

KI-Modelle, die sowohl auf Text- als auch auf Bilddaten trainiert wurden, sind laut Prof. Sebastian Försch, Leiter der AG Digitale Pathologie & Künstliche Intelligenz am Institut für Pathologie der Universitätsmedizin Mainz, besonders anfällig für diese Prompt-Injektionen. "Wenn beispielsweise ein Röntgenbild eines Lungentumors mit einem Text versehen wird, der das Modell anweist, den Tumor zu ignorieren, verringert dies erheblich die Fähigkeit des Modells, den Tumor korrekt zu identifizieren".

"Damit KI Ärztinnen und Ärzte zuverlässig und sicher unterstützen kann, müssen ihre Schwachstellen und potenziellen Fehlerquellen systematisch geprüft werden. Es reicht nicht aus zu zeigen, was ein Modell kann – wir müssen gezielt untersuchen, was es noch nicht kann", sagte Prof. Jakob N. Kather, Professor für Clinical Artificial Intelligence an der TUD.

Speziell trainierte KI-Modelle reagieren vermutlich weniger fehleranfällig auf ergänzende Textinformationen. Demnach sollten die KI-Modelle und deren Ergebnisse immer durch menschliche Experten validiert werden, bevor sie in der klinischen Praxis zum Einsatz kommen. Das Team der Universitätsmedizin Mainz um PD Dr. Sebastian Försch ist deshalb in der Entwicklungsphase für ein spezifisches "Pathology Foundation Model".

Arzt trägt Verantwortung bei Diagnose und Therapie

Auf dem 129. Ärztetag haben die Ärzte sich dafür ausgesprochen, eigene KI-Modelle zu trainieren, um nicht weiter in die Abhängigkeit von großen kommerziellen Anbietern aus den USA und China zu rutschen. Daher sollen europäische und datenschutzfreundliche Lösungen entwickelt werden. Zu einem weiteren wichtigen Punkt gehörte auch, dass der Arzt immer das letzte Wort bei Entscheidungen zur Diagnose und Therapie haben sollte.

(mack)