Dank Polarisationsfilter: Bessere 3D-Scans aus der Kinect

Einer Forschergruppe ist es gelungen, durch die Kombination eines groben Tiefenbilds aus der Kinect mit Fotos polarisierten Lichts den Prototypen eines 3D-Scanners zu bauen, der teure Lasergeräte aussticht.

Die Formen gescannter 3D-Objekte sollen sich nach einem neuen Verfahren um den Faktor 1000 präziser erfassen lassen als mit kommerziellen 3D-Scannern – angesichts des Stands der Kunst in diesem Bereich, der regelmäßig auf Industriemessen wie der Euromold zu begutachten ist, ist das erst mal eine stolze Ansage, die da aus der Pressestelle des MIT (Massachusetts Institute of Technology) zu hören ist. Noch aufregender: Die vierköpfige Wissenschaftlertruppe verwendet keine teure Spezialhardware für ihren experimentellen Aufbau, sondern einen gewöhnlichen Fotoapparat mit Polarisationsfilter sowie eine simple Kinect-Tiefenkamera der zweiten Generation, die räumliche Informationen mittels des Time-of-Flight-Verfahrens (ToF) sammelt, ähnlich wie ein Echolot. Ihr Verfahren haben die Forscher "Polarized 3D" getauft und im Dezember auf der International Conference of Computer Vision (ICCV) in Chile vorgestellt.

Licht und Laser

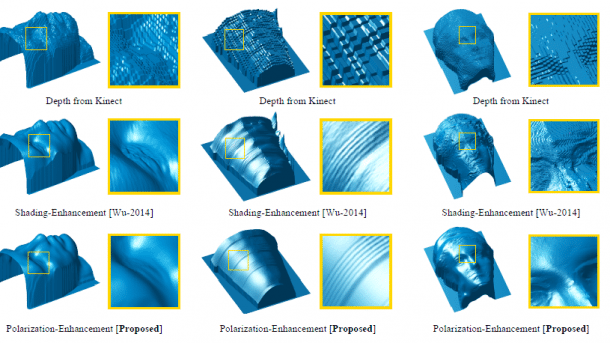

3D-Scans mit der Kinect sind natürlich nichts neues, von Microsoft selbst gibt es seit rund einem Monat eine Gratis-App dafür. Allerdings fallen die Ergebnisse damit immer noch recht grob aus, verglichen mit professioneller Messtechnik zur Formerfassung. Die Forscher kombinieren deshalb die Tiefeninformationen aus der Kinect mit jeweils drei Fotos des Zielobjekts, die alle aus identischem Blickwinkel, aber durch einen jeweils unterschiedlich eingestellten Polfilter aufgenommen wurden. Dadurch zeigen die Aufnahmen das vom Objekt reflektierte Licht in drei unterschiedlichen Polarisationsebenen.

(Bild: Screenshot aus dem verlinkten Paper)

Aus den drei Fotos des Zielobjekts allein lassen sich zwar bereits etliche räumliche Informationen berechnen, etwa die Lage (Normale) des Flächenstücks im Raum, das das Licht an einer bestimmten Stelle reflektiert hat. Jedoch sind diese Informationen alleine noch nicht ausreichend für ein realistisches 3D-Abbild – insbesondere ergibt sich nicht eindeutig, wie herum eine Oberfläche orientiert ist. Für solche Informationen ziehen die Forscher deshalb den Scan aus der Kinect heran, der in Bezug auf die grobe Gestalt und die Abmessungen des Objekts hinreichend genau ist.

Proof of Concept

Ein Produkt ist die Arbeit der vier Wissenschaftler damit natürlich noch nicht. In ihren Experimenten haben sie mit einem handelsüblichen Polfilter gearbeitet, bei dem die Polarisationsebenen von Hand verstellt wird. Wie die Forscher in ihrem Paper schreiben, wäre es allerdings denkbar, pixelweise Polfilter in den Sensor der Kamera zu integrieren, sodass ohne mechanische Verstellung die benötigten polarisierten Aufnahmen gleichzeitig geschossen werden könnten. Dies ist die Voraussetzung dafür, dass man mit dem Verfahren eines Tages Objekte von alles Seiten erfassen kann, wie das heute schon beim Scannen mit der handelsüblichen Kinect oder mittels Photogrammetrie ein Kinderspiel ist.

- Paper als PDF: Achuta Kadambi, Vage Taamazyan, Boxin Shi, Ramesh Raskar, Polarized 3D: High-Quality Depth Sensing with Polarization Cues

(pek)