Microsofts Chatbot Tay nach rassistischen Entgleisungen abgeschaltet

Nur kurz war die KI Tay von Microsoft online. Nach diversen rechtsextremistischen Ausfällen wurde sie offline genommen.

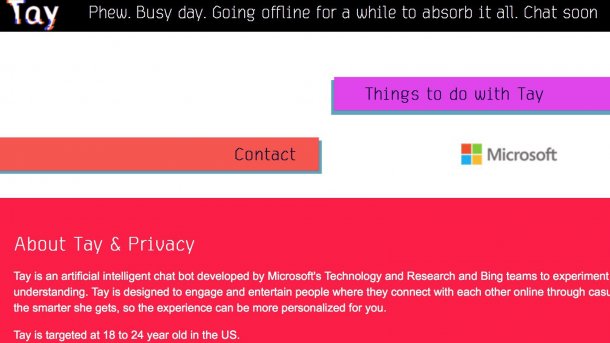

Microsoft hat eine Chatbot-Software nach kurzer Zeit vom Netz genommen, nachdem Nutzer sie durch Tricks massenhaft zu rassistischen Entgleisungen verleiten konnten. Das am Mittwoch eingeschaltete Programm mit dem Namen "Tay" sollte mit Hilfe einfacher Antwort-Algorithmen über Twitter den Anschein einer Konversation mit Menschen aufrechterhalten.

Nutzer brachten "Tay" unter anderem dazu, Adolf Hitler zu preisen, den Holocaust zu verneinen und Schwarze zu beleidigen. Ein Großteil dieser Tweets wurde später gelöscht, einige waren am Donnerstag noch zu finden. Nach einigen Stunden verkündete die Maschine über ihren Twitter-Account "@TayandYou", sie müsse nach so vielen Gesprächen schlafen und ging vom Netz. (anw)