Google I/O 2016: "Tensor-Prozessoren" halfen beim Go-Sieg

Google hat selbst Spezialprozessoren namens Tensor Processing Units entwickelt, die Deep-Learning- beziehungsweise KI-Algorithmen beschleunigen; sie waren auch am Sieg von AlphaGo gegen Lee Sedol beteiligt.

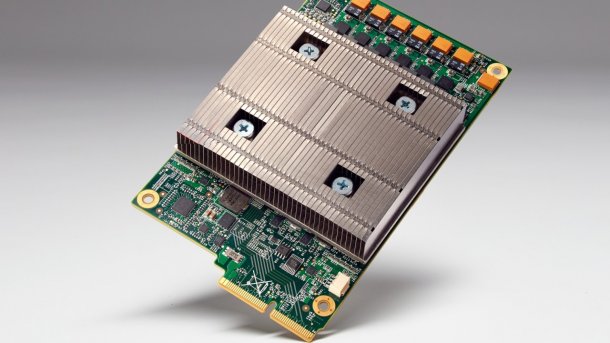

Unter dem Kühlkörper dieser Steckkarte sitzt eine Tensor Processing Unit (TPU).

(Bild: Google)

Auf der Google I/O 2016 informierte Urs Hölzle, Chef der technischen Infrastruktur, erstmals über die hauseigenen Tensor Processing Units (TPUs). Dabei handelt es sich um von Google selbst entwickelte Spezialprozessoren, die Algorithmen der Software-Bibliothek TensorFlow für KI beziehungsweise Deep Learning besonders schnell und effizient verarbeiten. Laut einem Blog-Eintrag von Hardware-Entwickler Norm Jouppi arbeiten schon seit mehr als einem Jahr TPU-Systeme in Google-Rechenzentren. Sie waren auch an der KI AlphaGo beteiligt, die den derzeit stärksten menschlichen Go-Spieler Lee Sedol bezwang.

(Bild: Google)

Weitere Details zu den Tensor-Prozessoren waren den Google-Mitarbeitern bisher kaum zu entlocken. Gegenüber US-Medien erklärte Hölzle, die Spezialchips (ASICs) lieferten deutlich höhere Effizienz als eine ebenfalls denkbare FPGA-Implementierung. Außerdem verriet er noch, dass schon zwei Chip-Varianten von zwei verschiedenen Auftragsfertigern im Einsatz sind.

Doch weder die bei der Herstellung verwendeten Strukturbreite noch die eigentlichen Produzenten der Chips wollte er nennen. Auch zur Leistungsaufnahme gab es keine Angaben – und auch keinen Performance-Vergleich zu x86-Prozessoren oder Rechenbeschleunigern.

Laut Blog von Norm Jouppi spielen die TPUs nicht bloß Go, sondern arbeiten bereits in Google-Produkten mit, etwa bei Google StreetView oder im Suchfilter RankBrain. Entwickler können TensorFlow über die Plattform Google Cloud Machine Learning nutzen, die sich allerdings noch im Alpha-Stadium befindet. Wie stark an diesem Cloud-Dienst aber auch TPUs beteiligt sind, wurde wiederum nicht konkret verraten.

Weitere Google-Chips dürften folgen

Google kooperiert mit IBM im OpenPOWER-Konsortium und tüftelt an Plattformen, die OpenPOWER-Prozessoren und beispielsweise Nvidia-Tesla-Karten koppeln, ebenfalls zur KI-Beschleunigung. Auch an ARMv8-SoCs für Server zeigt Google mittlerweile öffentliches Interesse. Schon 2010 hatte Google die von ehemaligen P.A.-Semi-Mitarbeitern gegründete Chip-Designfirma Agnilux übernommen.

Wie das Beispiel der TPU wieder einmal zeigt, hält Google die eigenen Entwicklungen streng geheim. Daran ändern auch vermeintlich offenherzige StreetView-Visiten in Google-Rechenzentren nichts: Dort ist nur solche Technik zu sehen, die Google auch zeigen will. (ciw)