Google-Forscher ruft nach Notschalter für Künstliche Intelligenz

Im Umgang mit lernenden "Agenten" wie Robotern müsse es für Menschen möglich sein, einen "großen roten Knopf" zu drücken und so "schädliche Handlungsstränge" zu verhindern, schreibt ein "DeepMind"-Experte von Google.

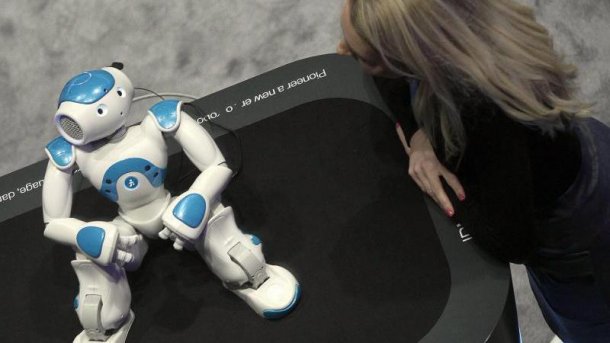

Was, wenn aus harmlos gefährlich wird.

(Bild: dpa, Alberto Estevez)

Laurent Orseau, Forscher der Londoner Google-Tochter DeepMind, macht sich für einen Panik-Knopf für Künstliche Intelligenz (KI) stark. Agenten in Form etwa von Robotern, die durch die Interaktion mit komplexen Umgebungen wie der realen Welt trainiert und auf gewisse Reaktionen eingeschworen würden, "verhalten sich höchstwahrscheinlich nicht ständig optimal". Das schreibt der frühere Dozent an der Hochschule AgroParisTech gemeinsam mit seinem Kollegen Stuart Amstrong vom "The Future of Humanity Institute" der Universität Oxford in einem Aufsatz. Es sei daher nötig, frühzeitig effektive Abwehrverfahren zu entwickeln, beispielsweise eine integrierte Notbremse.

Roter Knopf zum Schutz der Umgebung

Die beiden Wissenschaftler bringen bildhaft einen "großen roten Knopf" ins Spiel, den ein menschlicher Aufseher und Betreiber drücken könne. Das Computersystem müsse dadurch daran gehindert werden, sich selbst oder seiner Umwelt einschließlich der darin handelnden Menschen Schaden zuzufügen. Es sei aber nicht so einfach, die Not-Taste zu implementieren, da die Künstliche Intelligenz lernen könne, den Aus-Knopf selbst außer Gefecht zu setzen.

Die Firma DeepMind hat das KI-System AlphaGo entwickelt, das dieses Jahr erstmals mehrere menschliche Profis des asiatischen Brettspiels Go geschlagen und damit eine der letzten Bastionen der menschlichen Intelligenz geknackt hatte. Als nächstes soll nun ein Duell mit dem amtierenden Weltmeister gespielt werden.

Orseau und Armstrong spielen nun zahlreiche Wege durch, auf denen Robotern klargemacht würde, eine "Unterbrechung" durch die Umwelt oder einen Kontrolleur nicht zu verhindern. Dabei entwickeln sie eine Definition "sicher" zu stoppender Agenten und zeigen, dass einige Lern-Algorithmen und –Plattformen wie Q-learning bereits eigene Stopp-Funktionen enthalten und andere wie Sarsa (State-Action-Reward-State-Action) nachgerüstet werden können. Es bleibe aber unklar, ob alle in Frage kommenden Algorithmen jederzeit mit einer Art Notschalter beendet werden könnten.

Warnungen vor Künstlicher Intelligenz

Bekannte Wissenschaftler und Unternehmer wie Stephen Hawking oder Elon Musk warnen immer wieder vor den möglichen Gefahren Künstlicher Intelligenz für die Menschheit. Eric Schmidt, Vorstandsvorsitzender des Google-Dachkonzerns Alphabet, hält dies für Angstmacherei. Bedenken im Stile von "Oh mein Gott, der Roboter läuft Amok im Labor und hat sich dazu entschlossen, seine Inhaber umzubringen", erinnerten ihn nur an einen guten Horrorfilm, meinte er vor Kurzem in einer Gesprächsrunde im "Economic Club of New York". Es sei noch mindestens ein großer Forschungsdurchbruch nötig, bevor KI "den Stand menschlicher Intelligenz" erreiche, "den jeder hier in diesem Raum hat". (mho)