Intel bringt (endlich) den HPC-Prozessor Xeon Phi Knights Landing

Intels HPC-Chef Raj Hazra nutzte den ersten Tag der ISC in Frankfurt am Main, um dort den neuen Supercomputer-Prozessor Xeon Phi Knights Landing feierlich vom Stapel laufen zu lassen.

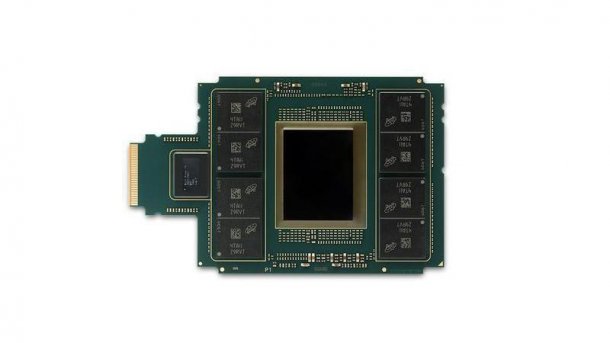

(Bild: Intel)

Gleich den ersten Tag der International Supercomputing Conference nutzte Raj Hazra, Chef von Intels Sparte für High Performance Computing (HPC), für die Vorstellung des den neuen Prozessors Xeon Phi Knights Landing. Zuvor war der lange erwartete Supercomputer-Beschleuniger schon in der neuen Top500-Liste der Supercomputer aufgetaucht, als Antrieb für den Stampede-KNL des Texas Advanced Computing Center.

Von der Grafik zum HPC

Vor gut zehn Jahren hat Intel das Projekt Larrabee gestartet, ursprünglich mit dem Ziel, AMD/ATI und Nvidia auf dem Highend-Grafikmarkt anzugreifen. Dieses Ziel hat Intel nach einiger Zeit wegen erkennbarer Chancenlosigkeit aufgeben, sich auf das High Performance Computing zurückgezogen und den Larrabee zum Xeon Phi umgewidmet. Die erste Version Knights Corner war aber nur eine Entwicklerversion, diente als eine Art Enabler. Der eigentlich konkurrenzfähige Chip mit weitaus leistungsfähigeren Kernen kommt erst jetzt.

Der kann nicht nur selber booten – braucht also keinen Host-Prozessor mehr und kann ungebremst auf den Hauptspeicher zugreifen – sondern auch Standard-Software fahren, wie sie etwa in der SPEC-CPU2006-Suite enthalten ist. Einfach mit den neuen Compilern kompilieren, laufen lassen und schon legt der Xeon Phi 7250 mit seinen 68 Kernen und vierfach Hyper-Threading mit 842 SPECFP_rate_2006base einen neuen Weltrekord für 1-Prozessor-Systeme aufs Parkett und fegt damit "endlich" den 32-kernigen Konkurrenten SPARC T7-1 vom Sockel (801 Punkte). Bei SPECint kann er sich mit 828 Punkten ebenfalls gut sehen lassen, das hat man von so einem HPC-Chip gar nicht erwartet.

Der Xeon Phi 7290 mit seinen 72 Kernen wäre gar noch etwas schneller (wenn auch weit teurer) – er ist derzeit aber noch nicht ganz fertig. Der Prozessor fährt normales Linux (Centos oder Ubuntu) und könnte auch Windows booten – das macht mit 256 oder mehr logischen Kernen aber wenig Sinn.

High Performance Computing

Linpack-Werte hat Intel für einen einzelnen Prozessor noch nicht herausgegeben, nur für oben genannten Supercomputer – aber die konnten wir auf einem Workshop am Tag vor dem ISC auf der Ninja-Workstation von Colfax auch selber messen. Das war von Intel gar nicht vorbereitet – aber wenn man weiß, wo man beim Intel-Composer die Linpack-Binaries findet …

Die kleine Basis-Version Xeon Phi 7210 mit 64 Kernen und 1,3 GHz kam mit den normalen Xeon-Kompilaten für AVX512 vom Intel Composer 2017 Update 1 auf 1650 GFlops bei etwa 220 Watt für CPU und Speicher während der heißen Rechenphase.

Die Bilbliotheken der Math Kernel Library (MKL) kamen dabei auch mit dem 16 GByte großen MCDRAM klar, jener Hypercube-Speicher von Micron, der mit hoher Bandbreite angebunden direkt auf dem Gehäuse sitzt. Beim Linpack-Lauf war es im sogenannten Flat-Modell über NUMA als eigener Speicherknoten eingebunden. Alternativ kann man den schnellen Speicher auch als transparenten Cache einsetzen, ähnlich wie das EDRAM bei den Iris-Pro-Desktop- und Mobil-Prozessoren. Daneben gibt es auch noch den kombinierten Hybrid-Modus.

Deep Learning

Mit Numactl und Stream kann man gezielt wahlweise in das MCDRAM oder in den Hauptspeicher streamen. Mit etwa 90 GByte/s ist die Performance von Stream Triad in den Hauptspeicher etwas niedriger als beim aktuellen Broadwell-EP-System mit zwei-Xeon E5-2697v3-Prozessoren, das etwa 120 GByte/s schafft – aber beim Stream ins MCDRAM ist man mit nahezu 500 GByte/s konkurrenzlos weit weg. Die Xeon-Fraktion wird die vielen Benchmarkvergleiche, wo zwei edle, teure Xeons zum Teil recht alt aussehen, wohl gar nicht so lustig finden.

Mit so was wie SPEC-Benchmarks, einem normalen Linux oder gar Windows können die GPUs nicht aufwarten, sie brauchen speziell vorbereitete Software und einen Host-Prozessor. Dafür bieten sie zahlreiche hochoptimierte Bibliotheken für viele Aufgabenbereiche. Dazu gehört auch das Training bei Deep Learning, ein großes Trend-Thema auch im High Performance Computing. Intel will den Xeon Phi nun natürlich ebenfalls tief im Deep Learning platzieren. 2,3-mal so schnell beim Training von Caffe AlexNet sollen vier Xeon-Phi-7250-Knoten sein, verglichen mit vier Maxwell-GPUs. Nur sind die aus dem Jahre 2015, vier Pascal GPUs in Tesla-P100-NVlink-Karten, so Nvida, wären indes über sechsmal so schnell.

Die autonomen Xeon-Phi-Prozessoren sind bis auf den 7290 (ab September) jetzt ohne integriertes Interconnect Omni-Path lieferbar.. Das soll für alle Versionen ab Oktober für zusätzlich 278 US-Dollar erhältlich sein und 15 Watt zusätzlich benötigen. Die PCIe-Steckkarten sind für Jahresende eingepant.

| Xeon Phi 7200 Familie | |||||

| Version | optimiert für | Kerne | HBM-Bandbreite | TDP | empf. Preis |

| 7290 | Performance /Knoten | 72 | 7,2 GT/s | 245 W | 6254 $ |

| 7250 | Performance/Watt | 68 | 7,2 GT/s | 215 W | 4876 $ |

| 7230 | Memory Bandwidth/core | 64 | 7,2 GT/s | 215 W | 3710 $ |

| 7210 | Performance/Dollar | 64 | 6,4 GT/s | 215 W | 2438 $ |

(as)