RO-MAN 2016: Roboter als Möbelbauer und Krankenpfleger

Das International Symposium on Robot and Human Interactive Communication (RO-MAN) 2016 widmete sich unter anderem der Mensch-Roboter-Interaktion in öffentlichen Umgebungen, der Interaktion von Gruppen sowie dem Einsatz von Robotern im Unterricht.

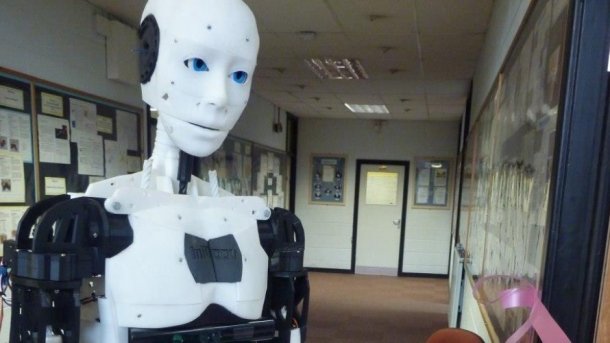

Der humanoide Roboter MARC spielt in Versuchen mit Menschen "Stein, Schere, Papier". In der einen Versuchsgruppe kommentierte er die Spielzüge der Probanden, in einer anderen nicht. Sympathischer kam er rüber, wenn er kommentierte, sogar wenn er den Gegenspiel als unfair bezeichnete.

(Bild: The Priory Academy LSST)

In New York trifft sich in diesen Tagen zum 25. Mal das "International Symposium on Robot and Human Interactive Communication", kurz RO-MAN 2016, um sich über Forschungen zum komplexen Zusammenspiel zwischen Mensch und Maschine auszutauschen. Wie bei solchen Veranstaltungen üblich, wird die eigentliche Konferenz von einigen Workshops eingerahmt, die sich speziellen Aspekten des Themas widmen, etwa der Mensch-Roboter-Interaktion in öffentlichen Umgebungen, der Interaktion von Gruppen oder dem Einsatz von Robotern im Unterricht.

¡Vamos a bailar!

Damit Roboter das Lernen von Menschen unterstützen können, müssen sie allerdings selbst lernfähig und anpassungsfähig sein. Mit diesen Fragen beschäftigte sich der Workshop on Behaviour Adaptation, Interaction and Learning for Assistive Robotics, abgekürzt BAILAR. Das ist das spanische Wort für "tanzen", doch die Workshop-Teilnehmer mussten bis zum letzten Vortrag warten, um tatsächlich einen tanzenden Roboter zu sehen: Rachael Bevill von der George Washington University zeigte Videoaufnahmen von Experimenten mit autistischen Kindern, die durch das Zusammenspiel von Musik, Imitationslernen und Robotern in ihrer emotionalen Entwicklung gefördert werden sollen. Dabei sei es besonders wichtig, betonte Bevill, dass Emotionen über Körperbewegungen ausgedrückt werden, statt nur durch Mimik. Bisher wurde in dem Projekt mit dem Roboter DARwin gearbeitet. Mit dem Nachfolger Robotis OP2, der unter anderem über eine bessere Bildverarbeitung verfügt, soll es zukünftig auch möglich werden, aus den Bewegungen des Kindes auf dessen Gefühlslage zu schließen und darauf zu reagieren.

iKEA

Zunächst ging es aber um profanere Dinge wie etwa den Zusammenbau von Möbeln. Brian Scassellati von der Yale University verdeutlichte an dem Beispiel, wie eine Zusammenarbeit von Mensch und Roboter erreicht werden kann, bei der beide ihre jeweiligen Stärken einbringen. So könnten Roboter zwar heute noch längst nicht mit dem gleichen Geschick Teile zusammenfügen wie Menschen, könnten aber unter Umständen die Montagesequenz besser überblicken und die Einzelteile in der richtigen Reihenfolge reichen. Wer schon mal an den Montageanleitungen eines schwedischen Möbelhauses verzweifelt ist, wird für solche Unterstützung dankbar sein.

Allerdings ist dafür erforderlich, dass der Roboter selbst lernt, wie er helfen kann. Dafür, so Scassellati, müssten die vielen möglichen Zustände des Roboters wie auch die Übergänge von einem zum anderen Zustand in eine Hierarchie gebracht werden, die der Abfolge der nötigen Arbeitsschritte entspricht. Dieses hierarchische Lernen soll dem Roboter mithilfe der Graphentheorie ermöglicht werden, wobei die Ecken eines Graphen die Zustände und die Kanten die Übergänge darstellen.

Initiative ergreifen

Heni Ben Amor von der Arizona State University bezog sich in seinem Vortrag ebenfalls auf die Graphentheorie. Ihre Tauglichkeit, das Lernen durch Beobachtung zu modellieren, verglich er mit einem wahrscheinlichkeitstheoretischen Ansatz, ohne sich jedoch definitiv für eine Variante zu entscheiden. Beide hätten ihre Vorzüge: So würde die graphentheoretische Modellierung den räumlichen Aspekt einer Bewegung stärker hervorheben, während sich die Wahrscheinlichkeitstheorie auf die elementaren Bestandteile einer Interaktion stützt. Amor empfahl, Interaktion generell als Kommunikation zu betrachten und Roboter nicht nur auf Menschen reagieren zu lassen, sondern ihnen auch proaktiv die Initiative zu überlassen.

Die Notwendigkeit proaktiven Verhaltens ergab sich auch aus Experimenten, von denen Phoebe Liu (Osaka University) berichtete. Mit Motion-Capture-Systemen und Mikrofonen hatten die Forscher zunächst die Interaktionen von Kunde und Verkäufer in einer nachgestellten Ladenumgebung beobachtet und dann den menschlichen Verkäufer durch einen Roboter ersetzt. Dieser stieß insbesondere dann auf Probleme, wenn es im Verkaufsgespräch auf den Kontext ankam oder wenn der Kunde schwieg. Ein aus drei Schichten bestehendes neuronales Netz soll dem Roboter helfen, auch auf solche Situationen angemessen reagieren zu können.

Bitte nicht perfekt

Liu arbeitet im Institut von Hiroshi Ishiguro, der insbesondere für die nach seinem eigenen Ebenbild täuschend ähnlich gestalteten Roboter berühmt ist – ein Ansatz, der zumeist sehr gemischte Reaktionen hervorruft. In der Robotik wird dieser Effekt als "uncanny valley" bezeichnet: Eine zu große Menschenähnlichkeit von Robotern wird von vielen als unangenehm empfunden. John Murray von der britischen University of Lincoln stellte in seinem Vortrag die Frage, ob sich das nur auf die äußere Erscheinung eines Roboters bezieht oder auch auf seine Persönlichkeit. In einem Experiment ließen er und seine Forschungskollegen 30 Versuchspersonen mit dem humanoiden Roboter MARC "Stein, Schere, Papier" spielen. Bei der einen Hälfte führte der Roboter lediglich die Bewegungen durch, bei der anderen kommentierte er das Ergebnis. So unterstellte er bei einer Niederlage etwa dem menschlichen Partner, unfair gespielt zu haben. Das wurde von den Menschen als interessanter und sympathischer empfunden. "Menschen sind nicht perfekt.", sagte Murray, "Roboter sollten es auch sein, um besser akzeptiert zu werden."

Pflege-Robo

Ob das auch gilt, wenn Möbel mit Roboterhilfe falsch zusammengebaut werden, darf aber wohl bezweifelt werden. Und bei Möbeln, die selbst Roboter sind, stößt die Toleranz für Fehler sicherlich ebenfalls schnell an Grenzen: Ariel Kapusta vom Georgia Institute of Technology schilderte, wie die Kooperation von einem Roboterbett und einem mobilen Roboter die Gesamtleistung von beiden verbesserte. Dabei betrifft die Kooperation nicht nur die Abstimmung der Bewegungen, indem das Bett etwa die Höhe an den Aktionsradius des Roboters anpasst, sodass dieser den Mund des Patienten abwischen oder dessen Knie kratzen kann. Das Autobed erweitert auch die Wahrnehmung des Roboters, indem es ihm mit 1728 druckempfindlichen Sensoren hilft, die Lage des menschlichen Körpers besser einzuschätzen, der möglicherweise unter einer Decke verborgen ist.

Als mobilen Roboter verwenden die Forscher am Healthcare Robotics Lab einen PR2. Dieses Monster hat nicht einmal entfernt die Anmutung einer einfühlsamen Krankenschwester, von der man sich gerne den Mund abwischen lässt. So haben die Forscher denn bislang auch mit Puppen experimentiert. Kapusta zeigte zum Schluss aber auch Videoaufnahmen von einem Versuch mit einem querschnittsgelähmten Patienten, der den Roboterpfleger offenbar gerne an sich heranließ – für die Forscher zweifellos ein Glücksfall. Doch Kapusta wie auch der gesamte Workshop machten deutlich: Bevor Roboter auch im Klinikalltag solche Aufgaben übernehmen können, muss sowohl bei der Hardware als auch bei den Algorithmen, die sie steuern, noch einiges an Entwicklungsarbeit geleistet werden. (ola)