Maschinelles Lernen: Google veröffentlicht Bildbeschreibungsmodul für TensorFlow

"Show and Tell" erweitert die Ansätze, mit denen das Google-Team 2014 startete. Der Einsatz von TensorFlow statt des Vorgängers DistBelief soll die Zuverlässigkeit erhöhen und gleichzeitig die benötigte Trainingszeit reduzieren.

Google hat seine Software zum Erstellen automatischer Bildunterschriften überarbeitet und als Open-Source-Software veröffentlicht. Das System namens "Show and Tell" ist als TensorFlow-Modell realisiert, Googles ebenfalls quelloffenes Framework für Projekte im Kontext des maschinellen Lernens. Show and Tell baut auf den Erfahrungen des Teams im Bereich Bilderkennung und -beschreibung auf. Das ursprüngliche System hatte erfolgreich an der COCO 2015 Image Captioning Challenge teilgenommen.

Damals verwendete das System den TensorFlow-Vorgänger DistBelief. Der Wechsel zu TensorFlow und die Verbesserungen am Modul selbst sollen laut dem Blog zu einer besseren Erkennungsrate geführt haben, die der Beitrag mit 93,9 Prozent beziffert. Außerdem ist das System beim Training wohl deutlicher performanter: Die Zeit, die jeder einzelne Schritt benötigt, ist demnach von 3 Sekunden auf 0,7 Sekunden gefallen. Das GitHub-Repository spricht immer noch von einer ersten Trainingsphase von ein bis zwei Wochen bei Verwendung einer Nvidia-Tesla-K20m-GPU. Auf einer CPU benötigt das System demnach etwa zehnmal so lange.

Menschliche Bildbeschreibungen als Vorlage

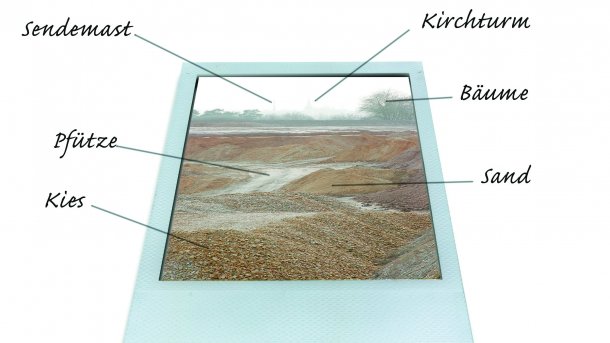

Die Software erkennt und beschreibt Bilder auf der Basis Hunderttausender vorhandener Beschreibungen anderer Bilder, die von menschlichen Betrachtern verfasst wurden. Dabei ist es wohl nicht nur in der Lage, ähnliche Fotos zu klassifizieren und auf dieselbe Art zu beschreiben, sondern auch vorhandene Beschreibungen zu kombinieren und in einen neuen Kontext zu setzen. Für die Umsetzung der Texte in natürlicher Sprache benötigt das System das Natural Language Toolkit (NLTK).

(Bild: Google)

Show and Tell ist ein weiterer Baustein zur Bildanalyse durch maschinelles Lernen. Google bietet mit Cloud Vision seit geraumer Zeit eine API zur Klassifizierung und Inhaltserkennung an. Facebook hat vor Kurzem mit den Bibliotheken DeepMask, SharpMask und MultiPathnet Bibliotheken zur Bildanalyse ebenfalls als Open Source veröffentlicht, die wie Show and Tell auf Deep Neural Networks (tiefe künstliche neuronale Netze) setzen. Auch Microsofts Coginitive Services und IBMs Watson-API bieten Bildanalysefunktionen.

Weitere Details stehen im Blogbeitrag. Technisch sehr viel detaillierter ist das Scribd-Paper "Show and Tell: Lessons learned from the 2015 MSCOCO Image Captioning Challenge". Die Software selbst ist auf GitHub verfügbar. Dort ist auch ein Diagramm zu finden, das die Arbeitsweise beschreibt. (rme)