Erste Skylake-Xeons und Spezial-FPGA für Künstliche Intelligenz

Ausgewählten Pilotkunden, die KI-Anwendungen betreiben, verkauft Intel schon jetzt die für Mitte 2017 geplanten Skylake-EP-Xeons mit AVX512; außerdem kündigt Intel neuronale Netze in Hardware an.

Intel Lake Crest: Ein neuronales Netz in (FPGA-)Hardware.

(Bild: Nico Ernst)

Die ersten Xeons mit Skylake-Architektur will Intel an Projektkunden auf den Gebieten der Künstlichen Intelligenz (KI/AI) und des Supercomputings ab sofort ausliefern. Dies gab die Chefin der Abteilung für Rechenzentren, Diane Bryant, in San Franciso bekannt. Dort hält Intel derzeit den ersten hauseigenen "AI Day" ab: eine Konferenz, bei der das Unternehmen seine Strategie für den KI-Markt vorstellt, den es bisher kaum erschlossen hat.

Um bei KI besser auszusehen, stellte Bryant Beschleunigungsfunktionen für KI-Programme des neuen Xeon E5-2600v5 alias Skylake-EP heraus. Gemeint ist damit aber nur die Befehlssatzerweiterung AVX512 (AVX3.2), die aber immerhin doppelt so breite Datenworte verarbeiten kann wie das bisherige AVX2. Das kann enorme Beschleunigung bringen, die manuelle Optimierung gilt jedoch als aufwendig.

Bevorzugte Kunden

Auf dem AI Day gab Intel auch eine strategische Allianz mit Google für eine "Multi-Cloud Artificial Intelligence" bekannt, bei der auch die TensorFlow-Bibliothek eine wichtige Rolle spielt. Nach Informationen von SemiAccurate.com gehören vor allem Google und Facebook zu den bevorzugten Kunden, denen Intel schon jetzt den eigentlich erst Mitte 2017 auf der Plattform "Purley" erwarteten Skylake-EP liefern will. Das könnte den Unmut anderer Unternehmen und Server-Hersteller erregen, die weiter mit Broadwell-EP alias Xeon E5-2600v4 arbeiten müssen. Laut Intel wichtige Ingredienzien der Purley-Plattform, insbesondere 3D-XPoint-Speicher, sind aber bisher ohnehin nicht lieferbar.

Spezifikationen der frühen Skylake-EP-Xeons wollte Intel auch auf Nachfrage nicht veröffentlichen.

Neuronale Netze

(Bild: Nico Ernst)

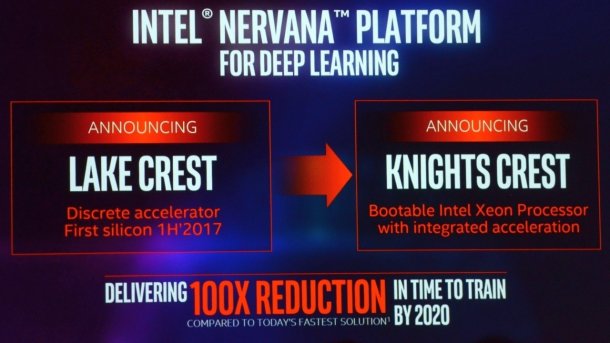

Die bisher nur als Software existierenden neuronalen Netze des von Intel übernommenen Unternehmens Nervana will der Chiphersteller ab 2017 auch in Hardware abbilden, zuerst aber auch nur auf FPGAs. Der erste "Lake Crest"-Beschleuniger soll als Zusatzkarte in Host-Servern laufen und Mitte 2017 erscheinen. Später - einen Termin nannte Intel nicht - soll der Xeon Phi "Knights Crest" folgen, der bootfähig und mit der FPGA-Erweiterung versehen ist.

Schon während der Supercomputer-Konferenz SC16 hatte Intel den "Deep Learning Inference Accelerator" (DLIA) mit einem Arria-10-FPGA der Tochter Altera avisiert.

Bei der Vorstellung der hauseigenen Tensor Processing Unit (TPU) hatte Intels neuer AI-Partner Google allerdings verkündet, dass FPGAs bei KI-Berechnungen deutlich mehr Energie schlucken.

Eigentlich war für den AI Day die breite Ankündigung des neuen Xeon Phi "Knights Mill" erwartet worden, doch die blieb aus. Immerhin bekräftigte Intel, dass Knights Mill 2017 erscheinen soll. Bisher gab es Spekulationen, dass er erst 2018 ansteht, weil der 10-Nanometer-Prozess für den großen Die noch keine genügend hohe Ausbeute liefere. Außer mehr Kernen wird Knights Mill auch bis zu 400 Gigabyte Speicher direkt auf der Karte ansprechen können. Für KI gibt es einen neuen Modus mit halber Genauigkeit, der ausreichen soll, um selbstlernende Algorithmen im Deep Learning zu trainieren.

Wachstumsmarke Nervana

Lake Crest und Knights Crest werden unter der Marke Nervana geführt. Diane Bryant betonte, dass Intel-Produkte durch optimierten Code und FPGAs bis 2020 die hundertfache Leistung für KI-Anwendungen ermöglichen sollen, verglichen mit den heute schnellsten Lösungen – das dürften wohl FPGAs und GPUs anderer Hersteller sein.

Intel-Chef Brian Krzanich sagte zur Eröffnung des AI Day, der Bedarf an KI-Rechenleistung entwickle sich doppelt so schnell wie der Rest der Einsatzbereiche. Bis 2020 soll sich die Zahl der Operationen, die in Rechenzentren nur für KI verwendet werden, verzwölffachen. Bisher, so ergänzte Diane Bryant später, mache KI in Rechenzentren nur 0,1 Prozent der genutzten Leistung aus. Ganz am Rande streifte Intel mit dem Verweis auf "Regierungen" einmal potenzielle KI-Großkunden: Geheimdienste. (ciw)