HRI 2017: Die Körpersprache der Roboter

In Wien versammeln sich Forscher aktuell zur Konferenz Human-Robot Interaction, um sich über ihre Erkenntnisse zur Interaktion mit Robotern auszutauschen. Dabei geht es nicht nur um plumpe Bewegungen, sondern auch die Geräusche und Blickkontakt.

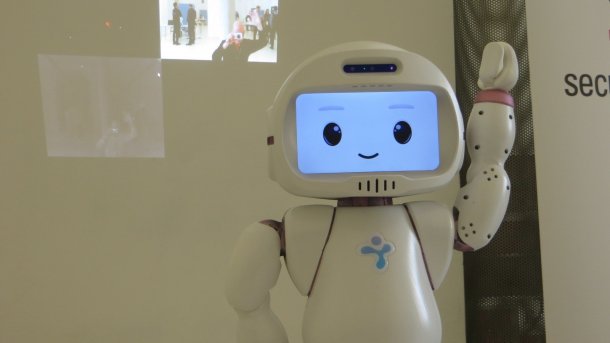

Der Roboter von Luxai winkt uns zu — wir winken zurück.

(Bild: heise online/Hans-Arthur MArsiske)

Reden ist Silber, Bewegen ist Gold. So ungefähr lässt sich ein großer Teil der Beiträge zur Konferenz HRI 2017 (Human-Robot Interaction) zusammenfassen, die sich gerade in Wien trifft. Schon im Workshop-Programm am Montag war es viel um das Bewegungsverhalten von Robotern gegangen. Das setzte sich mit der offiziellen Eröffnung der Konferenz am Dienstag fort.

Timing ist wichtig

Allan Zhou (University of Berkeley) hob die Bedeutung des Timings von Bewegungsabläufen hervor. Trickfilmer wüssten sehr genau, wie wichtig das ist, um die Bedeutung von Bewegungen verstehen zu können. Für Robotiker sei es dagegen noch überwiegend ein sekundärer Aspekt, der nach vollendeter Pfadplanung erwogen wird – wenn noch Zeit dafür ist. Dabei kann allein das Tempo, mit dem etwa ein Roboterarm dem Menschen ein Objekt reicht, schon wichtige Informationen übermitteln, zum Beispiel über das Gewicht des Objekts. Experimente mit Versuchspersonen sollen helfen, das Verständnis des richtigen Timings zu vertiefen.

Auftakt der Human-Robot Interaction 2017 (5 Bilder)

Elizabeth J. Carter von der Carnegie Mellon University berichtete von Experimenten, die sie in Zusammenarbeit mit Disney Research durchgeführt hat. Dabei ging es um die Frage, wie sich Roboter mit wenigen Freiheitsgraden trotz ihrer eher plumpen Bewegungsmöglichkeiten in Gruppenkonversationen am besten verhalten können. Hierfür wurden 20 Gruppen mit jeweils drei bis vier Teilnehmern zum Brainstorming mit dem Roboter Chester eingeladen, der im wesentlichen ein kleiner, beweglicher Schrank ist, mit einem cartoonartigen Gesicht auf der Vordertür. Im Brainstorming ging es um die Frage, wie Chester sich nützlich machen könnte.

Hüte für die Kommunikation

Interessanterweise wurde die Sprachausgabe des Roboters dabei von einem unsichtbar im Hintergrund wirkenden Operator gesteuert, während die physischen Aktionen autonom abliefen – um sie ging es schließlich. Es zeigte sich, dass unkontrollierte Bewegungen die Kommunikation erheblich stören können. "Kommunikative Bewegungen sind extrem wichtig für die Mensch-Roboter-Interaktion", betonte Carter. Die Experimente sollen fortgesetzt und verbessert werden. So mussten die Versuchsteilnehmer bisher noch "komische Hüte" mit Sensoren tragen, um vom Roboter geortet werden zu können. Darauf wollen die Forscher zukünftig verzichten.

Neben der Gestik haben Roboter noch andere Ausdrucksmöglichkeiten. So machen sie bei jeder Bewegung unvermeidlich Geräusche. Wie dieser Sound der Servomotoren auf Menschen wirkt, wollte Dylan Moore von der Stanford University genauer wissen. Dazu zeigte er zunächst einen Ausschnitt aus einem Video des Roboters SpotMini, in dem der vierbeinige Roboter durch ein Wohnzimmer läuft, erst ohne, dann mit Ton. "Das ist ein Sound, den wohl nur Robotiker lieben können", kommentierte er das ständige Jaulen der Motoren.

Vertrauen durch Geräusche

Die Geräusche lassen sich vorerst wohl nicht abstellen, aber vielleicht können sie gezielter genutzt werden? Dazu haben Moore und seine Kollegen zunächst einmal eine Studie durchgeführt, bei der Versuchsteilnehmer die Klänge verschiedener Servomotoren beurteilen sollten. Drei Motoren standen zur Auswahl: Der LS 8101F (Osepp), der FS5103 R (FeeTech) und der B 2122 (Batan). Dabei kam der LS 8101F nicht besonders gut an: Das sei der "Sound von Roboteralpträumen", sagte ein Proband. Das hohe Sirren des B 2122 fand mehr Fans, die damit mehr Professionalität und Präzision verbanden. "Das klingt wie ein Roboter, dem ich vertrauen kann", meinte ein anderer Studienteilnehmer.

Überwiegend hätten die Motorengeräusche negative Gefühle geweckt, sagte Moore. Die Assoziation mit Kraft, die für Ingenieure bei Motoren naheliegen mag, habe keine Rolle gespielt. Wichtiger war, ob ein Motor präzise, teuer oder allgemein angenehm klang.

Von Experimenten, mit piepsenden Geräuschen Emotionen auszudrücken, berichtete Sichao Song von der Graduate University for Advanced Studies in Tokio. Untersucht wurde, wie sich etwa mit ansteigenden oder fallenden Tönen in Verbindung mit farbigen Lichtern und Vibrationen Glück, Wut, Trauer oder Entspannung darstellen ließen. Dabei erwies sich allerdings die Farbe als das wichtigste Ausdrucksmittel: rot für Wut, blau für Trauer, grün für Glück und weiß für einen entspannten Zustand. Ein fallender Ton unterstrich traurige Gefühle, ein ansteigender stand für Ärger. Glück war für die Versuchsteilnehmer, die die Signale eines Roboter deuten sollten, generell am schwierigsten zu erkennen. Das soll in weiteren Studien verbessert werden, ebenso die allgemeine Differenziertheit in der Ausdrucksfähigkeit.

Die Augen wechseln

Einen interessanten Ansatz präsentierte Yuki Kinoshita (Universität Tokio) mit dem Projekt Transgazer. Die Blickrichtung sei in der Kommunikation sehr wichtig, betonte sie, sei aber schwierig zu steuern bei mehreren Gesprächspartnern. Während ein Mensch, der vor einem größeren Publikum redet, seinen Blick hin und her schweifen lassen muss, gibt es für Roboter andere Möglichkeiten: Transgazer wechselt einfach die Augen, je nachdem ob er sich auf einen Gesprächspartner fokussieren oder die Zuhörer insgesamt im Blick behalten will.

Im letzteren Fall blinzelt er kurz und wechselt zu konkav geformten Augen, die einen größeren Winkel abdecken. Im direkten Dialog verwendet er dagegen die üblichen, konvexen Augen. In ersten Experimenten habe sich der Ansatz bewährt, sagte Kinoshita. Allerdings waren in dem Video, das sie zeigte, nur ein Gespräch zwischen dem Roboter und zwei Menschen zu sehen. Weitere Versuche müssen daher noch folgen, bei denen auch die Bedeutung der Kopfbewegungen näher untersucht werden soll.

Werbung zum Auftakt

Es gibt offensichtlich ein wachsendes Bewusstsein für die Bedeutung sozial intelligenter Roboter, wie Cynthia Breazeal (MIT) in ihrem Eröffnungsvortrag feststellte. Ob aber wirklich schon ein Markt für soziale Roboter in Privathaushalten existiert, wie sie ebenfalls behauptete, erscheint aber eher zweifelhaft. Da geriet ihr zunächst sehr inspirierender Vortrag am Ende dann zu sehr zu einer Werbeshow für den von ihr entwickelten Roboter Jibo. Als sie die Videos, in denen sich fröhliche, gut aussehende Menschen mit dem Roboter amüsierten, als "pretty cool" kommentierte, war nicht mehr klar, ob da die Forscherin sprach oder die Marketingchefin. Leider ein zwiespältiger Auftakt für eine ansonsten sehr informative und anregende Konferenz. (mho)