Archivierung des Internets: Internet Archive ignoriert künftig robots.txt

Mit der Wayback Machine bietet das Internet Archive ein Archiv des Internets an. Das zeigt, wie Internetseiten früher aussahen. Immer öfter wird das aber durch Einträge in einer robots.txt unterbunden. Deswegen steuert das Archiv nun gegen.

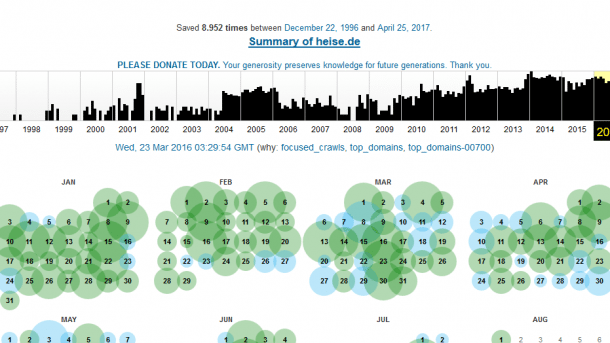

heise online im Internet Archive

Das Internet Archive will bei der Archivierung von Internetseiten künftig seltener darauf Rücksicht nehmen, was in der robots.txt festgelegt wurde. In dieser Datei sollen Administratoren eigentlich darauf hinweisen, wo Inhalte lediglich doppelt stehen oder wo vor allem die Algorithmen von Suchmaschinen Seiten aus verschiedenen Gründen nicht durchforsten sollen.

Das sei aber inzwischen zum Problem geworden, begründet die gemeinnützige Organisation den Entschluss, diese Vorgaben künftig noch stärker ignorieren zu wollen. Bereits seit einigen Monaten archiviert die Wayback Machine des Internet Archive schon Internetseiten der US-Regierung und des US-Militärs, auch wenn das durch die robots.txt untersagt ist.

Das Web, wie es aussah

Diese Schritt begründet Mark Graham in einem Blogeintrag damit, dass im Laufe der Zeit deutlich geworden sei, dass sich Vorgaben für Suchmaschinen nicht gut dafür eignen, die Archivierung zu regeln. Immer öfter komme es auch vor, dass vormals archivierte Domains den Besitzer wechseln und in einer neuen robots.txt die Archivierung untersagt werden. Das heißt also, die archivierten Versionen einer Seite gehen offline, wenn die Seite vom Netz genommen wird. Das Archiv solle das Internet aber so zeigen, wie es wirklich aussah, nicht wie es in den robots.txt deklariert wurde.

Auch wenn die Verantwortlichen das nicht explizit schreiben, ignoriert der Crawler des Internet Archives künftig also wohl nicht nur die direkten Vorgaben für Suchmaschinen, sondern auch jene, die speziell an ihn gerichtet wurden. Auf per Mail geäußerte Bitten, einzelne Inhalte aus dem Archiv zu entfernen werde aber reagiert, versichern die Betreiber. (mho)