Demnächst für Android und iOS: Googles Bildanalyse Lens erkennt Pflanzen, Tiere und mehr

Googles leistungsfähiges Foto-Analyse-Tool Lens funktionierte bislang nur mit Pixel-Smartphones. Nun will Google alle Android- und sogar iOS-Telefone damit ausstatten: Lens wird Bestandteil der "Fotos"- und "Assistant"-Apps.

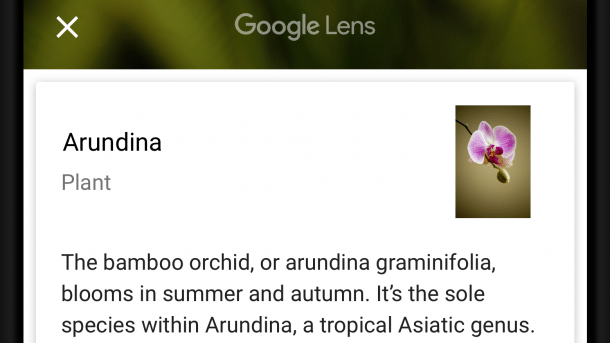

Google wird Bestimmungsbuch: Neben Pflanzen erkennt die "Lens"-Fotoanalyse auch Tierarten, Denkmäler, Kunstwerke und Text.

Was hab ich da gerade für eine Pflanze fotografiert? Was bedeutet dieses chinesische Straßenschild? Googles Bildanalyse-Funktion Lens soll Fragen wie diese künftig beantworten: Innerhalb der Google-Foto-App findet man ab demnächst eine Schaltfläche, mit der man den Bildinhalt analysieren lassen kann. Die Analyse findet nicht lokal auf dem Smartphone statt, sondern auf Google-Servern.

Google Lens: "Preview" ist vorbei

Bislang gab es die Lens-Funktionen nur für Besitzer von Googles hauseigenen Pixel-Smartphones, nun ist die "Preview"-Phase vorbei und die Funktion wird flächendeckend ausgerollt – und zwar auf so gut wie allen Android-und sogar iOS-Smartphones: Nämlich auf allen, auf denen sich die Google-Fotos-App installieren lässt. Die Lens-Funktion soll künftig zudem nicht nur in der Fotos-App stecken, sondern auch in der Assistant-App – und darin dann auch auch die Live-Bildanalyse beherrschen.

Während die "Preview"-Version von Lens vor allem Texte, Produktfotos, Kunstwerke und Denkmäler erkannte, soll sich die finale Variante nun auch mit Tieren und Pflanzen auskennen. Außerdem beherrscht die kommende Version das Auswählen von Textstellen auf Fotos: So lässt sich zum Beispiel ein Konzert direkt vom Plakat in den Kalender eintragen. Das Gleiche gilt für Kontaktdaten von Visitenkarten.

Schon seit längerem analysiert Google alle über die Fotos-App in die Cloud hochgeladenen Bilder. Das vereinfacht das Wiederfinden – gibt man beispielsweise "Kaffee" ein, werden alle Fotos angezeigt, auf denen Tassen zu sehen sind. Außerdem wertet die App die Geotags in den Metadaten der Fotos aus, eine Suche nach "Hannover" zeigt alle Bilder, die in dieser Stadt aufgenommen wurden. Eine gezielte Analyse eines einzelnen Fotos war bislang nicht möglich – dafür gibt es künftig die "Lens"-Funktion.

Updates kommen in den nächsten Wochen

Die neuen App-Versionen von Fotos und Assistant mit Lens-Unterstützung sollen laut Google "in den nächsten Wochen" veröffentlicht werden. Das Assistant-Update bekommen aber nur Benutzer, deren Systemsprache Englisch ist und die sich in Deutschland, UK, USA, Kanada, Australien, Indien, Frankreich, Spanien oder Singapur aufhalten. (jkj)