Windows Machine Learning für Unity

Microsoft hat auf der GDC weitere Details zu seiner kommenden Machine-Learning-Umgebung für Windows bekannt gegeben, darunter eine Unterstützung für die ML-Agents in Unity.

Microsoft

Noch in diesem Jahr will Microsoft eine Machine-Learning-Umgebung in Windows 10 integrieren. Eine Vorabversion ist seit kurzem bereits für Entwickler über die Insider Builts verfügbar. Auf der Game Developers Conference in San Francisco hat Microsoft nun weitere Details zum künftigen Ausbau von Windows ML genannt. So sind inzwischen eine Reihe von Formatkonvertern verfügbar, die Neural-Network-Modelle in das offene ONNX-Format übersetzen, darunter auch für Tensorflow. Neue ONNX-Modelle lassen sich beispielsweise in der Microsoft Cloud über Azure Machine Learning erstellen und anlernen.

(Bild: Microsoft)

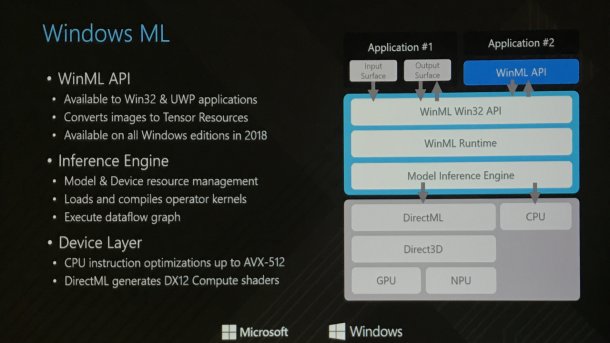

Die Windows ML API kann sowohl mit Win32 als auch mit UWP-Programmen genutzt werden. Als Device Layer zur Hardware dient DirectML, das passende DX12 Shader für GPUs und NPUs generiert.

Damit Entwickler neue Modelle einfach ausprobieren können, empfiehlt Microsoft das Open-Source-Plug-in ML-Agents für Unity, das just in der Beta-Version 0.3 erschienen ist. Innerhalb von ML-Agents lassen sich die ONNX-Modelle von Windows ML sehr einfach einbinden, sobald die Unterstützung im Laufe des Jahres verfügbar sein wird.

Imitierende KI bis zum Raytracing

Neben Microsoft zeigten zahlreiche Firmen auf der GDC neue Anwendungen, wie Machine Learning künftige Spiele verbessern kann. So zeigte Nvidia seine neue Raytracing-Engine, mit der ein fotoralistischer Star-Wars-Trailer entstanden ist. Bislang benötigt das Raytracing enorm hohe Ressourcen und kaum erschwingliche Grafik-Chips. Der Rechenaufwand könne sich in den kommenden Jahren jedoch dank Deep Learning dramatisch reduzieren. Dazu demonstrierte Nvidia neue Techniken, wie neurale Netzwerke per Deep Learning fehlende Bildinformationen ergänzen. Deshalb müsste man nicht alle Pixel per Raytracing berechnen. Ein verrauschtes Bild einer unvollständigen Berechnung reiche aus, um die fehlenden Bereiche per Deep Learning fotorealistisch zu ergänzen.

(Bild: Nvidia)

Electronic Arts unterhält eine eigene Forschungsabteilung namens Seed, die neue Anwendungsbereiche von Machine Learning untersucht, die in vier bis fünf Jahren in Spielen von EA zum Einsatz kommen könnten. Unter anderem arbeitet Seed derzeit an einer KI, die dieselben Informationen und Steuermöglichkeiten wie ein menschlicher Spieler bekommt.

Mit einem gewöhnlichen Reinforcement-Modell, das mit Belohnungen arbeitet, sei es zwar möglich, Controller mit nur einem Knopf zu bedienen, an einem PS4-Controller würde es jedoch scheitern, da dessen Knöpfe 20 Millionen unterschiedliche Kombinationen erlaube. Erfolg versprechender sei daher Imitationslernen, bei dem das Netzwerk mit Eingabedaten von realen Spielern trainiert wird. Der Prozess sei zwar sehr aufwendig, letztlich habe man es jedoch geschafft, der KI das Spielen von Battlefield beizubringen. Derartige Imitations-Modelle werden neuerdings auch von den zuvor erwähnten ML-Agents für Unity unterstützt.

(hag)