Facebook-Entwicklerkonferenz F8: KI und Faktenchecker gegen Problem-Postings

Facebook kommt auch beim Thema Fake News nicht aus den Schlagzeilen heraus. Wie reagiert das Unternehmen auf problematische Postings – und wie ist das bei über zwei Milliarden Benutzern überhaupt möglich?

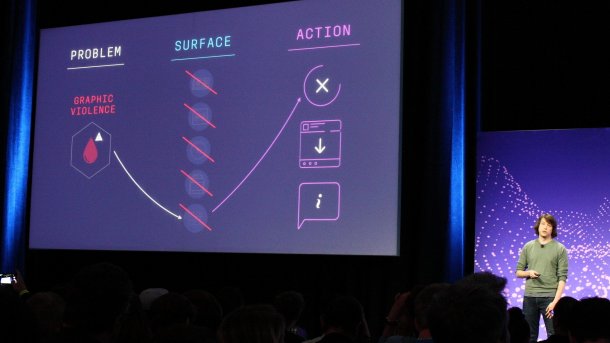

Grafische Gewaltdarstellungen werden in allen Facebook-Bereichen sofort gelöscht, erklärte Greg Marra bei der F8.

(Bild: Roland Austinat)

"Manch einer glaubt vielleicht, dass wir Fake News unterstützen, weil wir Geld damit verdienen – aber tatsächlich sind die für unser Unternehmen ein wirklich schlechtes Resultat." Mit diesen Worten eröffnete News Feed Product Manager Greg Marra einen Vortrag zum Thema "Authentizität und Qualität im News Feed" auf der Facebook-Entwicklerkonferenz F8.

Zwar wollen die Entwickler auch dem Verbreiten von Unwahrheiten per Instagram, Messenger, WhatsApp und Oculus einen Riegel vorschieben, derzeit konzentrieren sich die Aktivitäten von Faktenprüfern und KI-Forschern jedoch auf den klassischen Newsfeed der Hauptplattform.

Drei Probleme in fünf Bereichen

Um bei der gewaltigen Menge an Postings allein auf Facebook die Oberhand zu bewahren, gehen die Entwickler in drei Schritten vor. Zuerst steht die Klassifizierung eines Problems auf der Tagesordnung. Ein Problem kann eine Person, ihr Verhalten oder ein von ihr geposteter Inhalt sein.

Die Probleme tauchen in fünf Bereichen auf, die Facebook "Surfaces" oder Oberflächen nennt: bei der Monetarisierung etwa in Anzeigen oder Instant Articles, in Empfehlungen wie "Instagram Explore", im Ergebnis einer gezielten Suche, bei der Verteilung durch Newsfeeds oder Stories und schließlich beim Hosting – einem Sammelbegriff für all das, was Facebook-Nutzer posten.

Nach der Identifizierung können die Facebook-Mitarbeiter auf drei verschiedene Weisen reagieren: mit dem Entfernen oder Löschen des Problem-Postings, dem Verschieben ans Ende des Newsfeeds oder einer Warnung an Nutzer, dass sie gleich einen potenziell verstörenden Inhalt sehen werden.

Grenzfälle

(Bild: Roland Austinat)

Greg Marra illustrierte die Vorgehensweise anhand zweier Beispiele. Grafische Gewaltdarstellungen auf allen sechs Oberflächen führen zur sofortigen Löschung. "Kniffliger wird es jedoch, wenn etwa ein Chirurg Bilder einer Operation am offenen Herzen postet", sagte Marra. Diese sind durchaus für Medizinerkollegen interessant, doch Otto Normalnutzer könnte sie als unangenehm empfinden.

Die mehrstufige Lösung: Die Monetarisierung und das explizite Empfehlen solcher Inhalte werden gesperrt, bei der Suche nach "Herz" oder dem Zusammenstellen von Newsfeeds rutschen Fotos aus dem OP weiter nach unten. Doch die Ärzte dürfen sie selbstverständlich weiterhin posten – allerdings wird dem Besucher in einem Warnhinweis erklärt, was ihn erwartet.

Bei Facebook arbeiten Problem- und Oberflächenteams eng zusammen, um kritische Postings so sachlich wie möglich zu bewerten und dann entsprechende Aktionen zu planen. Der Haken, so Greg Marra, ist jedoch die schiere Menge an fragwürdigen Postings, durch die sich die Inhaltsprüfer wühlen müssen – deshalb sollen bei Facebook bis Ende 2018 rund 20.000 Prüfer in Lohn und Brot stehen.

KI-Training und kniffliger Kontext

(Bild: Roland Austinat)

Doch das allein reicht nicht aus. Eine Künstliche Intelligenz (KI) springt den Prüfern zur Seite. Wie Greg Marra ist auch seine Kollegin Tessa Lyons News Feed Product Manager und erinnert ebenfalls an einen Charakter aus Silicon Valley: Investorin Laurie Bream. Sie berichtete, wie Facebook-Mitarbeiter und externe Faktenprüfer mit ihren Bewertungen neurale Netzwerke trainieren. Mit diesem Wissen heben die KI-Netzwerke dann künftig Meldungen, die mit hoher Wahrscheinlichkeit falsch sind, zur Überprüfung hervor.

Doch auf den Kontext kommt es an: So kann es passieren, dass die Fakten stimmen, aber ein Artikel die falschen Schlüsse daraus zieht. "Viele Geschichten haben wahre, unwahre und irreführende Komponenten", sagte Lyons. "Deswegen wollen wir wissen: Stimmt wenigstens die Kernaussage?" Noch schwieriger zu erfassen ist Satire – sowohl für Mensch als auch Maschine. "Faktenprüfer könnten Satire zwar als solche kennzeichnen, doch manchmal verbergen Autoren ihre Fake News sogar in satirischen Postings", gab Tessa Lyons zu bedenken.