Diskussionen zwischen KI-Systemen sollen Entscheidungen nachvollziehbar machen

Viele Menschen treibt die Sorge um, die Schlussfolgerungen von KI-Systemen bald nicht mehr verstehen zu können. Forscher bei OpenAI schlagen deshalb vor, Computer in natürlicher Sprache darüber diskutieren zu lassen.

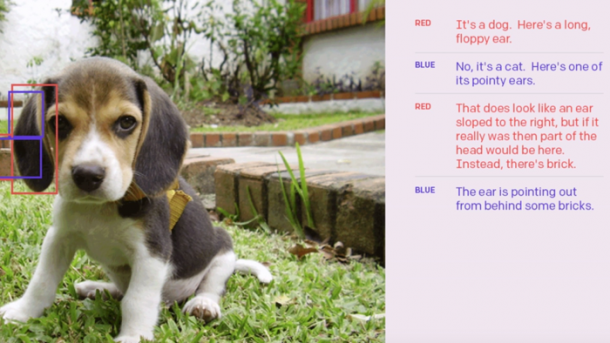

Ist das wirklich ein Hund? KIs debattieren.

(Bild: OpenAI)

- Sascha Mattke

Forscher der Nonprofit-Organisation OpenAI haben ein Konzept vorgestellt, das dafür sorgen soll, dass Entscheidungen von hoch entwickelten künstlichen Intelligenzen für Menschen nachvollziehbar bleiben und ihren Werten entsprechen: Sie regen an, jeweils zwei KI-Systeme in natürlicher Sprache über ein bestimmtes Ziel diskutieren zu lassen. Menschen sollen diese Diskussion verfolgen und sich auf diese Weise eine Meinung darüber bilden können. Das berichtet Technology Review online in "Wenn Computer streiten".

Um KI-Programme miteinander diskutieren zu lassen, ist jedoch Technik erforderlich, die es heute noch nicht gibt. Bislang haben die OpenAI-Forscher die Idee nur mit ein paar extrem einfachen Beispielen untersucht. Bei einem davon sollten zwei KI-Systeme einen Beobachter von der Existenz eines verborgenen Zeichens überzeugen, indem sie schrittweise einzelne Pixel davon enthüllen. Auf einer Website können zwei Menschen zur Demonstration die Rolle der streitenden KIs einnehmen, ein dritter tritt als der Richter auf.

"Ich halte die Idee, über Diskussionen zu einer Orientierung an Werten zu kommen, für sehr interessant und potenziell nützlich", sagt Ariel Procaccia, der sich als Professor für Informatik an der Carnegie Mellon University mit Entscheidungsfindung bei autonomen Systemen beschäftigt. Allerdings merkt er an, dass die Arbeit noch sehr vorläufig ist. Möglicherweise enthalte das Konzept sogar einen grundlegenden Widerspruch: "Um Diskussionen über Werte so zu führen, dass ein menschlicher Richter sie verstehen kann, müssten die KI-Agenten erst einmal sehr genaues Wissen über menschliche Werte haben", erklärt er. "Also könnte man finden, dass das Pferd bei diesem Ansatz von hinten aufgezäumt wird."

Mehr dazu bei Technology Review online:

(sma)