Deep Video Portraits erlauben nahezu perfekte Fake-Videos

Ein auf der Siggraph 2018 vorgestelltes Verfahren vertauscht Gesichter so überzeugend, dass die meisten Menschen Original und Fake nicht unterscheiden können.

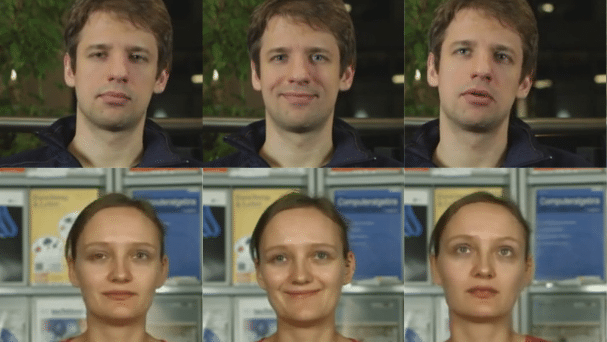

Acht Forscher aus Deutschland, Frankreich und den USA haben einen Algorithmus vorgestellt, der in Videos so täuschend echt Gesichter austauscht, dass die Hälfte der Teilnehmer einer Nutzerstudie Original und Fälschung nicht unterscheiden konnten.

Ein beeindruckendes Video, das die Forscher auf der diesjährigen Siggraph-Konferenz für Computergrafik präsentierten, beweist die Qualität der Fakes:

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes YouTube-Video (Google Ireland Limited) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (Google Ireland Limited) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Hilfe für die KI

Das internationale Team nutzt zwar grob die gleiche Idee wie DeepFakes, erleichtert der KI aber mit viel menschlicher Intelligenz die Arbeit. Im ersten Schritt geht der Algorithmus zunächst auf die Suche nach den passenden Parametern, um ein 3D-Modell des Quell- und Zielgesichts zu berechnen. Die Parameter für die grundsätzliche Gesichtsform und die Beleuchtungssituation mittelt das Programm aus allen Eingabebildern und berechnet für jedes Einzelbild Vektoren für die Kopfposition, Mimik und Blickrichtung.

Diese Parameter können die Forscher nun nach Belieben zwischen den Gesichtern austauschen. Sie kombinieren beispielsweise die Kopfstellung von der Zielperson mit der Mimik der Quellperson. Oder sie tauschen Kopfbewegung, Mimik und Gesichtsform aus und erhalten damit ein 3D-Fake.

Ausgetauscht

Mit diesem 3D-Modell lässt sich leicht ein Farbbild des Gesichts berechnen. Dem fehlt aber der Hintergrund. Außerdem wirkt es wie aus einem unfertigen Videospiel. Deswegen verwenden die "Deep Video Portraits" das Rendering des Gesichts, eine Matrix, wie sich das Gesicht durch die vertauschten Parameter geändert hat und ein Detailausschnitt der Augenposition nur als Eingabedaten eines neuronalen Netzes wie bei DeepFakes.

Dieser Autoencoder (ein grob Sanduhrförmiges neuronales Netz) ist im Vergleich zu DeepFakes noch etwas tiefer gewachsen. Trainiert wird das mit dem Lernsignal von einem Adversarial Network, einem neuronalen Netz, das die Fälschungen von Originalen zu unterscheiden versucht.

Vereinfachungen

Die Eingabedaten aus den 3D-Renderings vereinfachen das Problem für den Autoencoder so deutlich, dass in den erzeugten Gesichtern kaum sichtbare Artefakte mehr auftauchen. Der Autoencoder erfindet zum Gesicht passende Frisuren, Oberkörper und Hintergründe. Das klappt so gut, dass sogar Schatten im Hintergrund mit dem Kopf mitwandern.

Damit diese fotorealistischen Bilder im Video nicht springen, stehen dem Autoencoder nicht nur Tensoren aus dem aktuellen Frame, sondern auch aus zehn Frames davor als Eingabe zur Verfügung.

Das Erstellen der nötigen Datensätze für solche Fakes bedeutet einen immensen Aufwand. Daher sind vorerst nicht Tausende perfekt gefälschter Fake-Videos zu erwarten. Fürs Anpassen der Mundbewegungen in nachsynchronisierten Spielfilmen wäre das Verfahren allerdings geeignet.

(pmk)