Gesichtserkennung per KI muss reguliert werden

Das US-Forschungsinstitut „AI Now“ fordert in einem Bericht, zum Schutz der Öffentlichkeit Regeln für den Einsatz Gesichtserkennungs- und anderen KI-basierent Systemen zu schaffen. Ist es aber womöglich schon zu spät dafür?

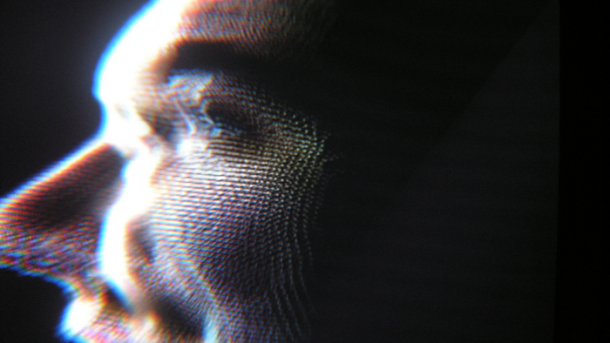

(Bild: "3D Face Scan" / Paolo Tonon / cc-by-sa-2.0)

- Will Knight

Auf künstlicher Intelligenz (KI) basierende Technologien haben in den letzten Jahren rasante Fortschritte gemacht. Nun allerdings werfen sie immer mehr ethische Dilemmas auf. Insbesondere die Art und Weise, wie das sogenannte „Deep Learning“ Gesichter von Menschen sogar in Fotos und Videomaterial mit schlechter Qualität extrem genau erkennen kann, erweist sich als problematisch.

Die Technik kann einerseits ermöglichen, dass man sein Handy mit einem Lächeln aufschließen kann. Andererseits bedeutet es auch, dass Regierungen und große Unternehmen ein leistungsfähiges neues Überwachungsinstrument erhalten. Ein neuer Bericht des einflussreichen New Yorker Forschungsinstituts „AI NowInstitute“ hat denn auch die Gesichtserkennung als eine der wichtigsten Herausforderungen für die Gesellschaft und Politik identifiziert.

Die Autoren des Berichts fordern die US-Regierung auf, solche KI-Technologien angesichts starker Datenschutzbedenken zu regulieren. „Die Einführung von KI-Systemen nimmt rasch zu, ohne dass es angemessene staatliche Vorschriften oder Kontroll- und Haftungsregelungen gibt“, heißt es darin. Deshalb solle die Zuständigkeit von staatlichen Behörden ausgedehnt werden.

Warnung bei Nachverfolgung

Der Bericht fordert zum Beispiel, dass die Öffentlichkeit gewarnt werden sollte, wenn Gesichtserkennungssysteme zur Nachverfolgung verwendet werden, und dass sie das Recht haben sollten, den Einsatz dieser Technologie abzulehnen. Auch ein stärkerer Schutz der Verbraucher vor irreführenden Behauptungen in Bezug auf KI sei nötig. Der Bericht mahnt zudem KI-Unternehmen nachdrücklich zu einer verantwortungsbewussteren Selbstverpflichtung. Sie sollten auch auf Geheimhaltungsansprüche zu verzichten, wenn es um die Rechenschaftspflicht von KI-Systemen geht – etwa wenn Algorithmen dazu verwendet werden, um kritische Entscheidungen zu treffen.

Die Umsetzung solcher Empfehlungen dürfte allerdings eine Herausforderung darstellen, da der Geist bereits aus der Flasche ist. Gesichtserkennungstechnologien wurden sehr schnell angenommen und eingesetzt. Sie schalten die neuesten iPhones von Apple frei und ermöglichen Zahlungen. Facebook scannt jeden Tag Millionen von Fotos, um bestimmte Nutzer zu identifizieren. Erst letzten Dezember kündigte Delta Airlines am Flughafen von Atlanta ein neues Check-in-System mit Gesichts-Scans an.

Darüber hinaus arbeitet die US-Strafverfolgungsbehörde Secret Service laut der US-Heimatschutzbehörde ebenfalls an einem Sicherheitssystem zur Gesichtserkennung für das Weiße Haus. Nicht zuletzt hat „die Rolle der KI bei der weit verbreiteten Überwachung hat in den USA, in China und in vielen anderen Ländern der Welt immens zugenommen“, schreiben die Autoren vom „AI Now Institute“ weiter.

Private und Staat kooperieren

Tatsächlich ist die Technologie in China in einem noch größeren Maßstab eingeführt worden. Dabei handelt es sich häufig um Kooperationen zwischen privaten KI-Unternehmen und Regierungsbehörden. Die Polizei verwendet KI zur Identifizierung von Verbrechern, und zahlreiche Berichte deuten darauf hin, dass sie auch zur Verfolgung von Dissidenten verwendet werden.

Selbst wenn sie nicht auf ethisch fragwürdige Weise eingesetzt wird, bringt die Technologie einige Probleme mit sich. Einige Gesichtserkennungssysteme weisen eingebaute Voreingenommenheiten auf. Wie Forscher der Amerikanischen Bürgerrechtsunion (ACLU) gezeigt haben, identifiziert Amazons Cloud-Gesichtsidentifikationssystem Minderheiten eher fälschlich als Kriminelle.

Der Report warnt außerdem vor der Verwendung von Emotions-Tracking in Gesichtsabtast- und Spracherkennungssystemen. Emotionen auf diese Weise nachzuverfolgen sei kaum bewiesen, wird jedoch auf potenziell diskriminierende Weise eingesetzt, beispielsweise um die Aufmerksamkeit der Schüler zu verfolgen. „Es ist an der Zeit, die Gesichts- und Gefühlserkennung zu regulieren“, sagt Kate Crawford, Mitbegründerin von AI Now und einer der Hauptautoren des Berichts. „Die Behauptung, in die inneren Gefühlzustände der Menschen ‚zu sehen‘ ist weder wissenschaftlich noch ethisch.“

(vsz)