Intel: Xe-Architektur unterstützt Raytracing-Beschleunigung

Intels für Ende 2020 geplante Grafikarchitektur Xe wird auch Raytracing unterstützen können. Das gab der Hersteller auf der Messe FMX bekannt.

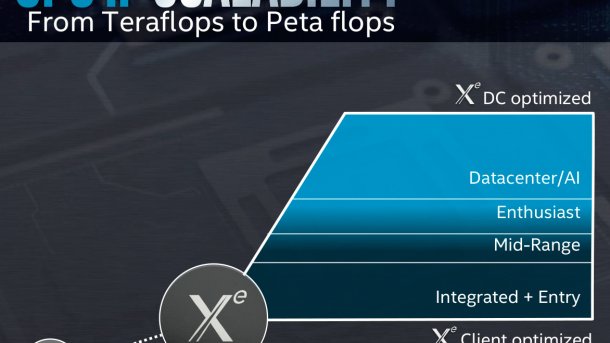

Intels Xe-Architektur soll weitreichend skalierbar werden.

(Bild: Intel)

Ende 2020 will Intel mit der Grafikchip-Architektur Xe die von AMD und vor allem Nvidia besetzten Marktsegmente zurückerobern. Dafür setzt der Hersteller alle Marketing-Hebel in Bewegung. Neuester Streich ist die auf der Fachmesse FMX bekanntgegebene Unterstützung von Raytracing-Beschleunigung.

Im Rahmen einer Präsentation über Intels Rendering Frameworks (IFR), darunter Embree, OSPRay und der unter anderem von DreamWorks und AutoDesk genutzte Open Image Denoiser, sagte der Vortragende Jim Jeffers etwas umständlich, Intels Xe Architektur-Roadmap für optimiertes Rendering im Rechenzentrum beinhalte auch Hardware-Beschleunigung für Intels Frameworks, APIs und Bibliotheken. Jeffers ist Senior Principal Engineer und Senior Director, Advanced Rendering and Visualisation bei Intel und arbeitete schon am (als Grafikchip) gescheiterten und inzwischen abgekündigten Xeon Phi mit.

In dem Vortrag kündigte Intel auch die Einrichtung dreier sogenannter Intel Graphics and Visualization Institutes of XeLLENCE an. Eingerichtet werden diese an den Universitäten von Utah, Texas und Stuttgart an. Die jeweiligen Institute hätten bereits wichtige Beiträge zur Forschung von großen Grafikinstallationen und Intels Rendering Framework geleistet. Eine Zusammenfassung davon gibt es im Intel-Blog.

Hardware-Raytracing - oder nicht?

Intels Grafikchip-Architektur Xe, welche Ende 2020 auf den Markt kommen soll, ist explizit stark skalierbar und flexibel ausgelegt. Sie soll vom integrierten Grafikchip über KI-Beschleuniger bis zum Exascale-Supercomputer einsetzbar sein.

Daher bedeutet die erwähnte Raytracing-Beschleunigung nicht zwingend, dass jeder Xe-Grafikchip nun dedizierte Raytracing-Kerne enthält. Denn die könnten entweder speziellen Varianten für den Rendering-Markt vorbehalten sein oder gar nur aus wenigen oder umgewidmeten Schaltungen bestehen, die auch im Dunstkreis von Raytracing einsetzbar sind.

Das macht Nvidia ähnliches mit seinen Tensor-Kernen in den Volta- und Turing-Grafikchips, etwa der Quadro RTX 4000 vor: Auf den Tensor-Cores kann ein vortrainiertes, neuronales Netz für einen Denoising-Algorithmus laufen, um Raytracing-Artefakte aus halbfertigen Bildern herauszurechnen. Mit etwas gutem Willen und viel künstlerischer Marketing-Freiheit könnte man dabei von Raytracing-Unterstützung sprechen. Da ist es gedanklich nur noch ein kleiner Schritt zu den Schaltkreisen mit reduzierter Präzision sowie einiger Befehle für KI-Routinen, die bereits in den Cascade-Lake-Xeons enthalten sind.

Bei Raytracing handelt es sich um eines der meistdiskutierten Themen im Grafikbereich. Vereinfacht gesagt, wird dabei die Farbe eines Bildpunktes bestimmt, in dem virtuell projizierte Strahlen verfolgt und deren optische Interaktion mit der virtuellen Welt errechnet wird. Mit Nvidia RTX-Grafikkarten kamen im vorigen Jahr die ersten Grafikkarten auf den Markt, die über Hardware-Schaltkreise verfügten, um Teile der Berechnungen zu beschleunigen. Die hohe Aufmerksamkeit, welche dieses Keyword erzeugt, sorgte kürzlich bei den technischen Details zur kommenden Playstation auch für einen Raytracing-Moment: Der Grafichip der Sony-Konsole, eine Spezialversion mit AMDs Navi-Architektur, soll laut Chefentwickler Mark Cerny Raytracing unterstützen, doch hob er im Interview mit wired.com viel mehr darauf ab, wie man Raytracing auch für realistische Audio-Simulationen nutzen könnte, wie es AMDs TrueAudio Next bereits seit Jahren kann [-] auch eine mögliche Auslegung von Raytracing-Support. Was AMDs Navi angeht, war Lisa Su im Gespräch mit Investoren anlässlich der Bekanntgabe der Quartalszahlen jedenfalls sehr vorsichtig, Raytracing-Support zu bestätigen.

Fest steht, dass Raytracing zumindest im Profi-Sektor, speziell der Film- und Special-Effects-Branche, nicht mehr wegzudenken ist. Ob dort nun die schnellere Hardware-Lösung (Nvidia RTX) oder die komplette Unterstützung für riesige Renderprojekte mit enormen Speichermengen (Intel Xeon) wichtiger ist, hängt wohl von Fall zu Fall ab. Nvidia und Intel werden jedenfalls nicht müde, für beide Optionen Beispiele zu finden, die ihren jeweiligen Standpunkt untermauern.

(csp)