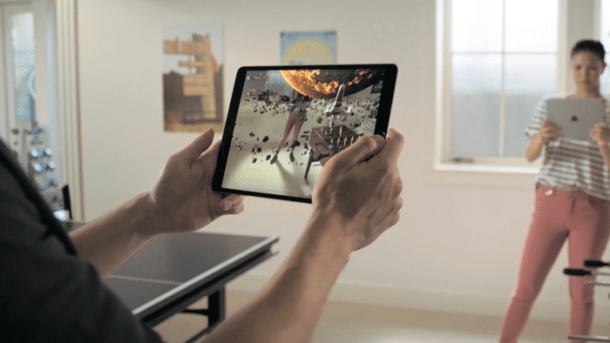

Augmented Reality auf iPhone und iPad: Das bringt ARKit 2

Apple hat im AR-Framework von iOS 12 viele Neuerungen hinzugefügt. ARKit 2 kann nun etwa Objekte scannen und Umgebungen speichern. Wir zeigen, wie's geht.

- Gero Gerber

Apples Augmented-Reality-Framework (ARKit) ermöglicht seit 2017 die Echtzeit-Darstellung virtueller Objekte in der realen Umgebung anhand der Kamera- und Sensordaten. Die zentrale Komponente aus programmiertechnischer Sicht ist hierbei die Klasse ARSession, welche mithilfe der Kamera und von Bewegungssensoren die reale Umgebung automatisch analysiert und die Position und Ausrichtung des iOS-Gerätes bestimmt. Hierbei kann ARKit Flächen, Bilder, Objekte und Gesichter erkennen.

- ARKit 2 kann die reale Umgebung als World-Map samt allen Ankern speichern und später wieder laden.

- Reale 3D-Objekte lassen sich einscannen und später wieder erkennen.

- Virtuelle Objekte können die reale Umgebung spiegeln.

- Das neue Dateiformat usdz ermöglicht die einfache Nutzung und den Austausch von 3D-Modellen.

Basierend auf dieser Analyse erzeugt ARKit ein 3D-Koordinatensystem und fügt sogenannte ARAnchor-Objekte zur Session hinzu. Diese Anker beschreiben das erkannte Objekt und lassen sich mit Knoten einer virtuellen 3D-Szene verknüpfen. Hierbei steuert der Anker anhand einer Transformationsmatrix die Position und Rotation des Knotens. Um ARKit vorzugeben, was es tun soll, benötigt die Session zum Starten eine Konfiguration (ARConfiguration).

ARKit 2: Wissenswertes vorab

Nicht alle iOS-Devices unterstützen ARKit. Minimale Voraussetzung hierfür ist eine A9-CPU (iPhone SE) oder ein neuerer Prozessor. Face-Tracking steht zudem nur auf Geräten zur Verfügung, die über eine TrueDepth Front Kamera verfügen.

Das war die Leseprobe unseres heise-Plus-Artikels "Augmented Reality auf iPhone und iPad: Das bringt ARKit 2". Mit einem heise-Plus-Abo können Sie den ganzen Artikel lesen.