Gestensteuerung: Google-Handy Pixel 4 kommt mit Radar-Chip "Soli"

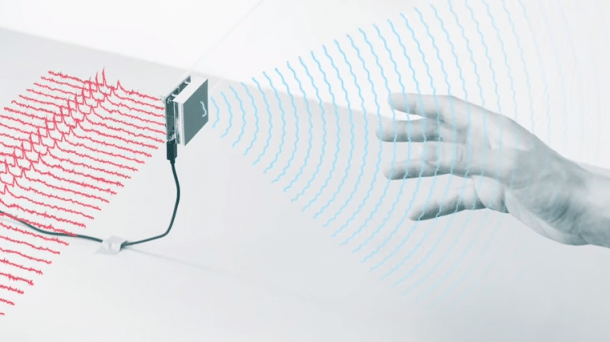

Kleine Fingergesten soll das nächste Pixel-Handy erkennen, selbst wenn es in der Hosentasche stecken bleibt. Möglich macht das der Soli genannte Radar.

(Bild: Screenshot)

Nach fünf Jahren Vorbereitung kündigt Google das erste kommerziell verfügbare Handy mit dem Radar-Chip Soli an, der feinste Fingergesten erfassen soll. Das Google Pixel 4 soll noch dieses Jahr auf den Markt kommen. Damit wird es möglich, das Gerät zu bedienen, ohne es berühren oder per Sprache bedienen zu müssen. Die Kombination aus Soli-Chip und Auswertungsalgorithmen heißt "Motion Sense". Google erwähnt konkret das Überspringen von Musikstücken in einer Wiedergabeliste sowie das Stummschalten von Wecker und Telefonläuten per Handbewegung.

(Bild: Daniel AJ Sokolov)

"Diese Fähigkeiten sind erst der Anfang", heißt es in dem kurzen Google Blog-Post. "Und so wie die Pixel-Geräte mit der Zeit besser werden, wird sich auch Motion Sense weiterentwickeln." Zumindest in den USA dürfte Soli auch funktionieren, wenn das Mobiltelefon in der Hosentasche bleibt. In dem Land hat die zuständige Behörde FCC eine Freigabe für die Radar-Gestensteuerung erteilt, dank der Google einen stärkeren Radarstrahl als üblicherweise zulässig einsetzen darf. Motion Sense wird nicht überall sondern nur in "ausgewählten Ländern" funktionieren. Welche das sind, bleibt abzuwarten.

Gesichtserkennung mit Infrarot

Zusätzlich sollen sich Pixel-4-Smartphones mittels Gesichtserkennung entsperren lassen – einfacher als heute am Markt verfügbare Geräte. "Face unlock mag ein vertraute Funktion von Smartphones sein, aber wir entwickeln das anders", schreibt Produktmanager Brandon Barbello. Der Soli-Chip soll die Gesichtserkennung aktivieren, sobald der User zum Handy greift. Zudem funktioniere die Gesichtserkennung bei fast jeder Geräteorientierung, also auch wenn man oben und unten verwechselt hat.

Damit das klappt, baut Google oberhalb des Pixel-4-Bildschirms ein ganzes Sensoren-Array zur Gesichtserkennung ein: Neben Kamera, Soli-Chip, Helligkeits- und Distanzsensor werden sich dort zwei Infrarot-Kameras, eine Leuchte und ein Projektor, der Infrarot-Punkte auf das Gesicht des Users wirft, befinden. Unbestätigten Meldungen zufolge wird das Pixel 4 147 x 68,9 x 9,3 mm messen, das Pixel 4 XL 160,4 x 75,2 x 9,3 mm.

Barbello betont, dass die für die Gesichtserkennung genutzten Fotos ausschließlich auf dem Pixel 4 gespeichert und nie hochgeladen oder mit anderen Google-Diensten geteilt werden. Auch die Soli-Funktionen würden ausschließlich auf dem Gerät berechnet.

Fünf Jahre Forschung

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes Video (TargetVideo GmbH) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden.

Damit können personenbezogene Daten an Drittplattformen (TargetVideo GmbH) übermittelt werden.

Mehr dazu in unserer

Datenschutzerklärung.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes Video (TargetVideo GmbH) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (TargetVideo GmbH) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Googles Project Soli war erstmals auf der Entwicklerkonferenz Google I/O 2015 öffentlich präsentiert worden. Gegründet wurde das Projekt von Ivan Poupyrev, geleitet von Carsten Schwesig. Schwesig ist Chefdesigner, Poupyrev Entwicklungschef von Googles Inkubator-Abteilung ATAP. Das steht für Advanced Technologies And Projects (etwa Fortschrittliche Technologien Und Projekte). Das Team war ursprünglich Teil von Motorola Mobility. Dieses Unternehmen hat Google zwar an Lenovo verkauft, aber ATAP behalten.

Im Jahr darauf teilte Google auf der I/O 2016 mit, Infineon habe den Radarchip Soli auf ein Drittel seiner ursprünglichen Größe geschrumpft. Er benötigte damals nur mehr ein Zweiundzwanzigstel der Energie und ein 256-tel der Rechenkraft, um Fingergesten auszuwerten. (ds)