Linux-Entwickler optimieren weiter um Prozessor-Bugs herum

Durch "Core Scheduling" soll sich Hyper-Threading bald auch sicher mit CPUs nutzen lassen, die bekannte Schwachstellen aufweisen.

- Thorsten Leemhuis

Auf der derzeit stattfindenden Linux Plumbers Conference ging es gleich in mehreren Sessions um Sicherheit und Performance in Zeiten von Prozessor-Sicherheitslücken wie Spectre, Meltdown, L1TF und MDS. So arbeiten die Entwickler daran, Intels Hyper-Threading wieder sicher mit Linux nutzen zu können – das muss man bei vielen Intel-Prozessen derzeit zum vollständigen Schutz vor den Prozessor-Schwachstellen deaktivieren, die seit Anfang 2018 bekannt wurden.

Ferner wurden auch Kernel-Änderungen grob umrissen, um die Arbeitsspeicherbereiche verschiedener Prozesse strikter voreinander zu trennen; dadurch sollen Bösewichte weniger Schaden anrichten können, falls in Zukunft ähnliche Prozessor-Sicherheitslücken bekannt werden. Von diesen Ansätzen ist aber noch keiner reif für die Aufnahme in den Kernel.

Hyper-Threading wieder sicher nutzen

Dank dem maßgeblich von einem Intel-Mitarbeiter entwickelten "Core-Scheduling", von dem einige Teile zur Aufnahme in Linux 5.4 vorgesehen sind, soll sich Hyper-Threading (HT) auch auf Prozessoren mit Lücken wie L1TF und MDS sicher nutzen lassen. Durch den Ansatz lassen sich Prozesse in Gruppen bündeln, in denen ein Angriff von einem auf den anderen Prozess keine Gefahr darstellt. Zu einer Gruppe gehörende Prozesse führt der Scheduler dann auf HT-tauglichen CPU-Kern parallel aus, aber nie gleichzeitig mit Prozessen, die anderen Gruppen oder gar keiner angehören.

Das ist vor allem für Cloud-Anbieter interessant, damit diese einer Virtual Machine (VM) zwei virtuelle CPUs zuteilen können, die der Kernel parallel auf dem HT-tauglichen CPU-Kern ausführt. So lässt sich dessen Leistungspotenzial ausschöpfen, ohne die VMs manuell bestimmten CPUs zuzuweisen (Pinning), damit eine VM eines Kunden nicht die eines anderen angreifen kann. Das Core Scheduling hat indes einige Tücken und Overhead, daher wird es explizit zu aktivieren sein.

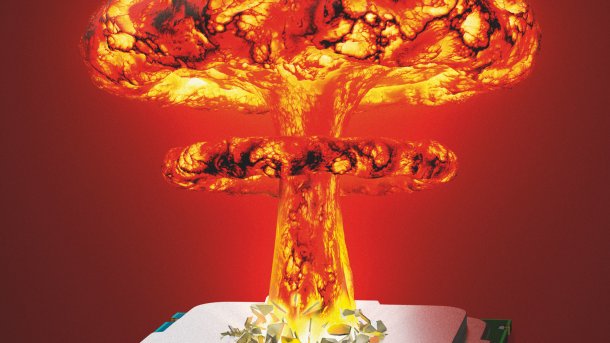

Diskutieren mit Wurfgeschoss

(Bild: c't/Thorsten Leemhuis)

Auf der Konferenz wurden noch einige Unklarheiten rund um den Ansatz geklärt, die Entwickler jetzt mit Patches angehen wollen. Wie bei der Linux Plumbers Conference (LPC) gewohnt erfolgten solche Diskussionen mit einer "Catchbox" – einem kubischen Kissenmikrofon, das sich die Teilnehmer quer durch den Vortragsraum zuwerfen können, ohne das irgendwer Beulen davonträgt.

Einige Details zum Core-Scheduling erläutert ein LWN.net-Artikel aus dem Frühjahr. Video-Aufzeichnungen von den drei LPC-Sessions, die sich um Core-Scheduling drehen (1, 2, 3), wollen die Veranstalter demnächst bei YouTube veröffentlichten. Der schon voriges Jahr von einem Amazon-Mitarbeiter vorgeschlagene Ansatz des "Co-Scheduling", der umfassender ist als Core-Scheduling und weitere Einsatzmöglichkeiten abdeckt, hat fürs Erste den Kürzeren gezogen.

Bessere Separation durch Beschneiden des Adressraums

Im Vortrag Kernel Address Space Isolation stellten verschiedene Entwickler ihre Ideen vor, um den vom Prozessen erreichbaren Arbeitsspeicher mit Tricks wie separaten Page Tables zu reduzieren. Das verspricht einige Angriffswege, die Prozessor-Sicherheitslücken ausnutzen, die Wirkungsgrundlage zu entziehen: Von Kernel und anderen Prozessen verwendeter Arbeitsspeicher wird dadurch noch schwieriger zu erreichen.

(Bild: Präsentations-Screenshot )

Die diskutierten Ansätze heißen KVM Address Isolation (das mit Address Space Isolation [ASI] arbeitet), Process Local Memory, Namespace Local Memory und Kernel Page Table and Context Consolidation. Details zu den Wirkungsweisen finden sich in Präsentationsfolien der Sessions. Die dort geführten Diskussionen zeigen aber, dass die Ansätze tiefgründige Umbauten erfordern würden, die eine zentrale, performancekritische Infrastruktur komplexer machen – Wortbeiträge ließen dabei durchblicken, dass einige zentrale Kernel-Entwickler daran zweifeln, ob die zusätzliche Sicherheit diesen ganzen Aufwand wert ist.

Der Veranstalter haben dem Autor einen kostenlosen Zugang zur Linux Plumbers Conference gewährt.

(thl)