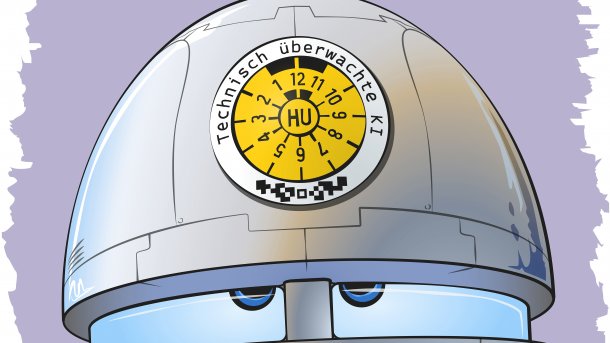

Wie sich KI-Entscheidungen überprüfen lassen

Wenn KI-Systeme Entscheidungen treffen, lassen sich diese oft nicht nachvollziehen. Deshalb wollen Wissenschaftler neuronalen Netzen auf die Finger schauen.

(Bild: Rudolf A. Blaha)

Künstliche Intelligenz erkennt Krebs in Röntgenaufnahmen, beurteilt Kreditanträge und wählt bei der Personalsuche den besten Bewerber. Aber bislang müssen Patienten und Kunden den Entscheidungen der KI blind vertrauen. In der Regel haben sie keinen Einblick, mit welchen Datensätzen Algorithmen und neuronale Netze trainiert wurden und nach welchen Kriterien sie ihr Urteil fällen. Das europäische Parlament verlangt hier mehr Transparenz und fordert die EU-Kommission zur Umsetzung auf.

Laut der Resolution des EU-Parlaments von Anfang Februar sollen KI-Systeme nachvollziehbare und tendenzfreie Algorithmen anwenden, sonst kann der Betroffene die Verantwortlichen für Nachteile haftbar machen. Zudem müsse die EU-Kommission dafür sorgen, dass nur sichere und konforme KI-Anwendungen in Verkehr gebracht werden.

Das sind komplexe Forderungen angesichts einer breiten Vielfalt an KI-Anwendungen. Deren Entscheidungen entspringen oft tiefen neuronalen Netzen, gebildet und verfeinert (trainiert) mithilfe umfangreicher Beispieldatenbanken und in automatisierten Deep-Learning-Verfahren. Ein derart entstandenes neuronales Netz gilt gemeinhin als Black Box. Mit neuen Methoden gelingt es Forschern jedoch, diese transparent zu machen und eventuelle Irrtümer aufzudecken.

Klare Regeln

Wird man neuronalen Netzen künftig beim Denken zusehen können? Dr. Maximilian Poretschkin, Leiter des Projekts KI-Zertifizierung am Fraunhofer Institut für Intelligente Analyse- und Informationssysteme (IAIS), antwortet vorsichtig: Im Prinzip sei das möglich, wenn auch auf Umwegen. Oft sei es einfacher, von vornherein transparentere KI-Anwendungen zu konzipieren. Forscher des IAIS haben zum Beispiel ein System gebaut, das Kreditkartenbetrug erkennt. Zunächst analysiert das System historische Transaktionen mithilfe maschinellen Lernens. Hierbei kommt eine sogenannte Subgruppensuche zum Einsatz. Die Ergebnisse dieses Lernprozesses dienen dazu, Verhaltensweisen von Betrügern zu identifizieren und daraus Regeln abzuleiten. Diese Regeln erlauben es einer regelbasierten KI anschließend, in Echtzeit zu entscheiden, ob eine Transaktion wahrscheinlich betrügerisch ist oder nicht. Gleichzeitig gibt sie aus, welche Regel zum Tragen kommt, wenn sie eine Ausgabe blockt. Das ist transparent.

Alle Arten von Scoring-Systemen, die an sensiblen Stellen zum Einsatz kommen, sollten transparente Entscheidungen fällen, sagt Poretschkin, etwa bei der Kreditvergabe in der Bank oder bei der Personalauswahl im Unternehmen. Zwei weitere große Bereiche sind medizinische Diagnosesysteme und das autonome Fahren. Spätestens dort komme man künftig um die Prüfung von KI-Anwendungen nicht herum. „Das Problem bei vielen neuronalen Netzen ist, dass man sie nicht in Module zerlegen kann, um die dann separat zu testen“, erläutert Poretschkin. Aber man könne die zugesicherten Eigenschaften einer KI testen.

Zeig mir, warum

Wie man eben doch einem tiefen neuronalen Netz beim Entscheiden genau auf die Finger sehen kann, hat Dr. Wojciech Samek als Gruppenleiter Maschinelles Lernen am Fraunhofer Heinrich-Hertz-Institut (HHI) gezeigt. Gemeinsam mit einem Team um Professor Klaus-Robert Müller an der TU Berlin entwickelten die Fraunhofer HHI-Forscher bereits 2015 das LRP-Verfahren (Layer-wise Relevance Propagation). Gerade in der Bilderkennung können die Forscher damit eine KI-Entscheidung analysieren und die vielen Berechnungen und Gewichtungen innerhalb des neuronalen Netzes nachverfolgen. Das LRP-Verfahren identifiziert dann die Eingangspixel, die am meisten zur Entscheidungsfindung beigetragen haben, und markiert diese farblich in einer sogenannten Heatmap. LRP zeigt also die Bildbereiche, die für die KI am bedeutendsten sind.

Allerdings erklärt LRP immer nur eine Einzelentscheidung. Das Verfahren hebt Bildbereiche hervor, aufgrund derer die KI auf einem Foto ein Pferd, einen Hund oder einen Menschen erkennen konnte. Oder es markiert die Bereiche einer Röntgenaufnahme, die für eine bestimmte Erkrankung sprachen. Das ist noch zu wenig, um das erwünschte Verhalten einer KI vollständig in den Griff zu bekommen. Ein neuronales Netz, das ein braunes Pferd im Sonnenschein erkennt, könnte bei einem Schimmel im Regen patzen.

So haben die Forscher der TU Berlin und des Fraunhofer HHI im vergangenen Jahr nachgelegt und ihr LRP-Verfahren erweitert zur Spectral Relevance Analysis (SpRAy). Dieses neue Verfahren ist in der Lage, eine Vielzahl an LRP-Heatmaps automatisiert zu gruppieren. Zu jeder dieser Gruppen liefert es einen typischen Repräsentanten. Wenn ein neuronales Netz beispielsweise eine Million Bilder analysiert und im LRP-Verfahren eine Million erklärende Heatmaps bildet, dann liefert SpRAy dazu ein paar Dutzend oder vielleicht hundert Cluster. Anhand von deren Repräsentanten könne man schnell erkennen, was die dominanten Entscheidungsstrategien sind, sagt Samek.

Schlau wie ein Pferd

Und man kann vor allem Entscheidungen entdecken, die neuronale Netze anhand falscher Grundlagen fällen. „Wir waren sehr erstaunt über die große Bandbreite der gelernten Problemlösungsstrategien. Selbst moderne KI-Systeme haben nicht immer einen aus menschlicher Perspektive sinnvollen Lösungsweg gefunden, sondern nutzten sogenannte Clever-Hans-Strategien.“ Diese Tricks gehen auf ein Pferd zurück, den „klugen Hans“, der um 1900 die deutsche Wissenschaftswelt in Aufruhr versetzte, weil er angeblich rechnen und sogar buchstabieren konnte. Später erkannte man, dass Hans die richtigen Antworten lediglich aus dem unbewussten Verhalten des Fragestellers ableitete.

(Bild: Fraunhofer HHI)

Mit SpRAy deckten die Forscher auf, dass eine KI Pferde auf Fotos nicht an der Mähne erkannte, sondern an einem Copyright-Hinweis, den viele Pferdefotos gemeinsam hatten. Flugzeuge auf Fotos erkannten neuronale Netze an Wolken auch am unteren Bildrand. Aus dem medizinischen Bereich kann Poretschkin von einer KI berichten, die bei der Suche nach einer Herzvergrößerung miteinbezog, ob der Patient bei der Röntgenaufnahme stand oder im Bett liegen musste. War ein Patient bettlägrig, so tippte die KI eher auf Herzvergrößerung.

Jagd auf Artefakte

Mit SpRAy analysieren die Forscher die Entscheidungsqualität von KI-Anwendungen. Mittelbar ziehen sie damit auch Rückschlüsse auf die Qualität der Datensätze, die im Deep-Learning-Verfahren die Grundlage für das Training und damit die Bildung tiefer neuronaler Netze bilden. Sie entdeckten sogenannte Artefakte selbst im ImageNet, einer internationalen Standarddatenbank mit heute mehr als 14 Millionen verschlagworteten Bildern. Artefakte können beispielsweise die genannten Copyright Tags sein oder auffällige Nachbearbeitungen, Schnittkanten, Einschränkungen des Farbraums. Selbst KIs der University in Berkeley und der University of Oxford, die mit Bilddaten aus ImageNet trainiert worden sind, offenbarten in der SpRAy-Analyse klare Clever-Hans-Strategien.

Die Auswahl der Trainingsdaten ist also entscheidend für die Qualität einer KI-Anwendung. Wenn aber Fehler oft schon in dieser Auswahl begründet sind, dann macht das deutlich, dass die Zertifizierung einer KI diesen Prozessschritt einbeziehen muss. Stimmt die Datenqualität nicht, weil die späteren Entscheidungsklassen unausgewogen repräsentiert sind, dann wird ein sogenannter Bias (übersetzt etwa: Voreingenommenheit) vom neuronalen Netz gleich mitgelernt.

„Die KI-Forschung kann von anderen Zertifizierungssystemen lernen, etwa in der Luftfahrt oder bei normalen Medizinprodukten“, regt Samek an. Demnach sind alle beteiligten Prozesse über den gesamten Lebenszyklus abzusichern, von der Auswahl der Trainingsdaten über das Deep Learning bis hin zur Validierung der Erklärungen für Entscheidungen. Das System könne Urteile über redundante Wege absichern oder bei Unsicherheit auf ein Fallback-System verweisen.

Auch die Modularisierung in separat entwickelte Einzel-KIs kann ein Weg sein. Poretschkin verweist auf das Beispiel des autonomen Fahrens. Heute erlaubt man Autos noch nicht, vollständig KI-gesteuert am Straßenverkehr teilzunehmen, hat aber bereits Einzelanwendungen wie etwa Notbremsassistenten zugelassen.

Angesichts der unterschiedlichen Einsatzfelder plädiert Dr. Michael Fübi als Präsident des TÜV-Verbands für die Einführung von Risikoklassen und Prüfsiegel. Sein Verband arbeitete bereits mit dem Bundesamt für Sicherheit in der Informationstechnik (BSI) gemeinsam an Prüfschritten für KI-Anwendungen. Im Projekt KI-Zertifizierung kooperiert auch das Fraunhofer IAIS mit dem BSI. Poretschkin hofft, dass in zwei bis fünf Jahren ein finaler Prüfkatalog steht und auch die Akkreditierungsverfahren abgeschlossen sind. Anhand solcher Siegel bekämen Endanwender immerhin eine Chance, vertrauenswürdige KI-Systeme zu bevorzugen.

Dieser Artikel stammt aus c't 6/2020.

(agr)