KI-Prozessor: Graphcores riesiger 60-Milliarden-Transistor-Chip

Im Gegensatz zu vielen anderen KI-Startups liefert Graphcore seine Hardware tatsächlich aus – und hat mit Microsoft Azure einen großen Partner.

(Bild: Graphcore)

Graphcore hat den KI-Prozessor Colossus Mk2 GC200 vorgestellt, der rekordverdächtige 59,4 Milliarden Transistoren auf einer Chipfläche von 823 mm² unterbringt und vor allem mit Nvidias Ampere-Grafikchip A100 konkurriert (54 Milliarden Transistoren, 826 mm²).

Während Nvidias A100 jedoch eine Allzweck-GPU mit KI-Anteil darstellt, eignet sich der Colossus Mk2 GC200 als ASIC ausschließlich zum Trainieren und Ausführen neuronaler Netze. In ihm stecken 1472 "IPU-Cores", was bei Graphcore für Intelligence Processing Unit steht. Diese führen Multiply-Accumulate-(MAC-)Operationen aus und können beispielsweise mit den Datentypen FP32 und INT8 umgehen. Der Hersteller spricht von 62,5 FP32-TeraFlops beziehungsweise 250 INT8-TeraOps pro Chip. Die Fertigung übernimmt TSMC mit 7-Nanometer-Technik.

Videos by heise

Auf den 823 mm² bringt Graphcore 900 MByte SRAM-Cache unter, in die vergleichsweise große KI-Modelle passen. Hier liegt auch der Grund für die höhere Transistor-Packdichte verglichen mit Nvidias A100: SRAM ist simpel aufgebaut und lässt sich besonders eng packen.

(Bild: Graphcore)

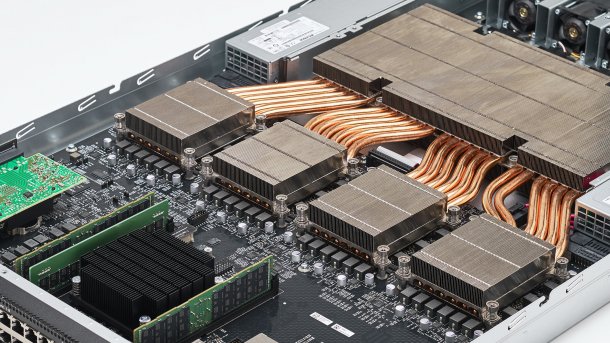

1U-Server mit vier KI-Prozessoren

Verkaufte Graphcore die bisherigen MK1-Prozessoren ausschließlich als PCI-Express-Steckkarten, erscheint der Colossus Mk2 GC200 in Form von 1U-Servern, M2000 genannt und von Dell EMC vertrieben. Zu den prominentesten Abnehmern gehört Cloud-Betreiber Microsoft mit Azure, der zuvor schon in das Startup investierte.

Graphcore koppelt auf einem Board vier Colossus Mk2 GC200, die in einem Ringbus miteinander kommunizieren. Letzterer ermöglicht einen recht einfachen und effizienten Aufbau, allerdings können die einzelnen Chips so nicht an einem gemeinsamen Modell rechnen. Über einen Switch ("IPU-Gateway") laufen bis zu 2,8 TBit/s. Er greift auf M.2-Datenträger und zwei DDR4-Steckplätze zu, die zum Vorhalten von Daten und nicht etwa als Puffer dienen. Laut Graphcore lassen sich beliebig viele solcher Boards aneinanderkoppeln. Die externe Kommunikation läuft über 100-Gigabit-Ethernet.

(Bild: Graphcore)

CTO Simon Knowles ist der Kopf hinter dem KI-Prozessor. Zuvor hatte er Iceras Modemsparte als Chefingenieur mitaufgebaut und leitende Positionen bei Element 14 (inzwischen Teil von Broadcom) und STMicroelectronics bekleidet.

(mma)