Video Authenticator: Microsoft-Software soll Deepfakes entlarven

Manipulierte Videos und Fotos sorgen vielfach für Desinformation. Microsoft will dagegen den Video Authenticator in den Kampf schicken – aber nicht nur ihn.

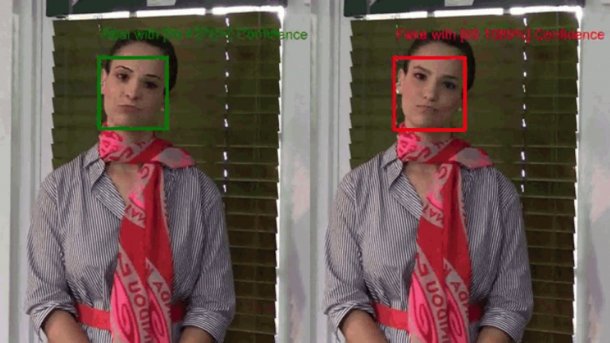

(Bild: Microsoft (Screenshot))

Microsoft entwickelt mit dem Video Authenticator eine KI-Software, die Deepfakes, also Manipulationen von Videos und Fotos erkennen soll. Wie Microsoft anmerkt, sei Desinformation sehr verbreitet. Sie bedrohe die Demokratie, die Microsoft durch den Einsatz der Software verteidigen wolle.

Konkret sieht Microsoft die Gefahr darin, dass Deepfakes die Meinung großer Teile der Bevölkerung mit falschen Informationen beeinflussen und Menschen so manipulieren können, dass sie falsche Schlüsse ziehen. Das schade dem demokratischen Willensbildungsprozess – auch in Hinblick auf die bevorstehenden US-Präsidentschaftswahlen im November.

Manipulationen erkennen

Um solche unerwünschten Einflussnahmen durch Deepfakes zu verhindern, arbeitet Microsoft am KI-basierten Video Authenticator, schreiben Tom Burt, Vizepräsident für Kundensicherheit & Vertrauen und Eric Horvitz,CSO bei Microsoft im Microsoft-Blog. Die Software soll Videos und Fotos analysieren und eine prozentuale Wahrscheinlichkeit berechnen, ob ein Medium von einer Künstlichen Intelligenz (KI) gefälscht wurde oder nicht. Die Software soll dabei die Videos in Echtzeit analysieren und für jedes einzelne Videoframe die Wahrscheinlichkeit einer Manipulation bestimmen können. Die charakteristischen Merkmale von Deepfakes wie Bildübergänge zwischen authentischem und generierten Material sowie Unterschiede von Graustufen und Bildschärfe, die für das menschliche Auge kaum erkennbar sind, soll der Video Authenticator erkennen, heißt es von Microsoft.

Die Technik dafür wird von Microsoft Research in Zusammenarbeit mit Microsofts AI Team sowie Microsoft AI, Ethics and Effects in Engineering and Research (AETHER), einem beratenden Gremium, entwickelt. Das Gremium achte darauf, dass neue Techniken in verantwortlicher Weise entwickelt und eingesetzt werden.

Trainiert wurde die KI-Software Video Authenticator nach Microsoft-Angaben unter Verwendung des öffentlichen Datensatzes Faceforensics++ und danach mit dem DeepFake Detection Challenge Dataset getestet. Angaben zur Erkennungsleistung macht Microsoft nicht.

Microsoft ist sich bewusst, dass die Methoden zur Generierung von Deepfakes immer besser werden und die KI-Erkennungsmethoden Fehler aufweisen. Deshalb will Microsoft weiter an besseren Methoden forschen.

Online-Erkennung von Fälschungen

Um sicherzustellen, dass Medien aus vertrauenswürdigen Quellen stammen und nicht manipuliert wurden, stellt Microsoft dem Video Authenticator ein System zur Seite, das manipulierte Online-Inhalte erkennt oder Medien als authentisch einstuft.

Das System besteht aus zwei Komponenten, heißt es im Blog-Eintrag. Die erste ist ein in Microsoft Azure integriertes Tool, das digitale Inhalte mit Hashes und Zertifikate versehen kann. Diese seien zusammen mit den Metadaten verbunden. Die zweite Komponente, beispielsweise ein Reader in Form einer Browsererweiterung, überprüft die Zertifikate und checkt die Hash-Werte auf Übereinstimmung. Die Leser können dann "mit einem gewissen Maß an Genauigkeit" erfahren, ob die Inhalte authentisch sind oder verändert wurden. Außerdem ist ersichtlich, wer die Inhalte erstellt hat.

Microsoft ist mit seinem Kampf gegen Deepfakes nicht allein. Google hat die experimentelle Plattform "Assembler" aufgesetzt, Facebook hat zusammen mit Microsoft und anderen einen Wettbewerb ausgerufen, um ein System zur Erkennung von Deepfakes zu erhalten. (olb)