Exposing.AI: Projekt enthüllt Missbrauch von Flickr-Fotos für Gesichtserkennung

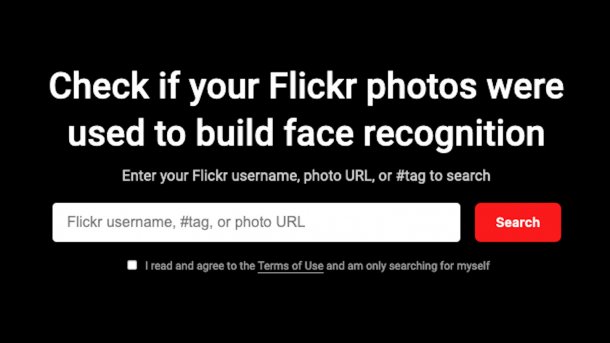

Forscher haben eine Suchmaschine entwickelt, mit der sich prüfen lässt, ob Flickr-Bilder fürs Training von Gesichtserkennungs-Systemen zweckentfremdet wurden.

(Bild: Exposing.AI (Screenshot))

Seit Jahren bauen Firmen und Wissenschaftler ihre Sets mit Trainingsdaten für Systeme zur biometrischen Gesichtserkennung häufig "wild" ohne Einwilligung der Betroffenen auf. Adam Harvey und Jules LaPlace, die als Forscher und Künstler in Berlin leben, machen dieses Treiben in ethischen und rechtlichen Grauzonen nun zumindest etwas transparenter. Sie haben mit "Exposing.AI" eine Suchmaschine entwickelt, mit der Nutzer prüfen können, ob ihre Flickr-Bilder für solche Zwecke missbraucht wurden.

Das vor Kurzem online gegangene Projekt erlaubt eine Suche mit Flickr-Kennungen wie dem Benutzernamen, der von der Bilderplattform vergebenen NSID oder einer Foto-ID. Nur wenn eine exakte Übereinstimmung mit entsprechenden Daten in den einbezogenen Überwachungsdatenbanken gefunden wird, werden Ergebnisse angezeigt. Die Betreiber der Plattform speichern selbst keine Suchdaten und geben diese auch nicht weiter. Die angezeigten Fotos werden dann direkt von Flickr.com geladen, Kopien davon nicht aufbewahrt.

Videos by heise

Interessierte können auch nach Fotos von sich selbst suchen, die Dritte aufgenommen und auf Flickr gestellt haben, indem sie einen Hashtag verwenden. Denkbar ist dabei etwa an ein Kürzel für besuchte Veranstaltungen oder private Feiern wie "#mybirthdayparty". Die Macher geben hier aber zu bedenken, dass diese Form der Suche etwas länger dauere: "Jedes Foto kann Dutzende von Tags enthalten, was zu Millionen weiterer Datensätze für die Suche führt."

Hohes Missbrauchs- und Schadenspotenzial

"Die Menschen müssen erkennen, dass einige ihrer intimsten Momente zu Waffen gemacht wurden", erläuterte Liz O'Sullivan, Technologie-Direktorin bei der Bürgerrechtsorganisation Surveillance Technology Oversight Project (STOP), die Initiative gegenüber der New York Times. Die Aktivistin hat am Design von Exposing.AI mitgearbeitet. Ursprünglich war ihr zufolge geplant, für die Suchmaschine ebenfalls automatisierte Gesichtserkennung einzusetzen. Davon habe das Team aber wieder Abstand genommen: Das Missbrauch- und Schadenspotenzial sei zu hoch gewesen.

Harvey hatte jüngst auf einer Konferenz anhand von Erkenntnissen aus seinem Vorläuferprojekt "Megapixels" über das Vorgehen der Jäger nach Gesichtsaufnahmen berichtet, um die teils noch hohen Fehlerraten der Technik auszumerzen. Microsoft etwa habe sich für die Datenbank Celeb einfach bei Bildern von Promis sowie weniger bekannten Personen im Web bedient, die Duke University für das "Multi-Tracking-Register" DukeMTMC Aufnahmen von Studenten mit Teleobjektiv von einem Fenster des Instituts aus gemacht. Für "Brainwash" hätten die Verursacher sogar Bilddaten eines Video-Livestreams aus einem Café in San Francisco abgezweigt.

Diese Datenbanken seien zwar inzwischen größtenteils offiziell abgeschaltet worden, weiß der Künstler: "Aber man kann sie nicht wirklich aus dem Netz bekommen." So kursierten die Inhalte nach wie vor in "akademischen Torrents" in Peer-to-Peer-Netzwerken "rund um die Welt". Es sei erwiesen, dass Teile davon etwa von der chinesischen Armee übernommen und nun auch für die Unterdrückung der muslimischen Minderheit in der autonomen Region Xinjiang verwendet würden. Beteiligte Firmen wie Megvii und Hochschulen müssten dafür haften, forderte der Aktivist.

Fotos löschen

Neben den genannten Datensets ermöglicht das von der Gruppe "Künstliche Intelligenz und Medienphilosophie" der Hochschule für Gestaltung Karlsruhe sowie dem Weizenbaum-Institut unterstützte Projekt eine Suche etwa auch in MegaFace mit über 3,5 Millionen Fotos, DiveFace mit über 115.000 Aufnahmen von Flickr, VGG Face, Pipa, IJB-C, FaceScrub, TownCentre, UCCS und Wildtrack. Obwohl Exposing.AI so Millionen von Datensätzen durchsucht, gibt es den Machern zufolge "unzählige weitere Trainingsdatensätze für Gesichtserkennung, die laufend aus sozialen Medien sowie Nachrichten- und Unterhaltungsseiten zusammengetragen werden". Künftige Versionen des Projekts würden möglicherweise entsprechend erweitert.

Ein nachträgliches Löschen von Bildern aus bereits kursierenden Kopien von Datensets sei nicht möglich, heißt es auf der Webseite. Für noch aktuell gepflegte Trainingsdatenbanken arbeite man an einer Funktion, um anhand der Suchergebnisse die Betreiber zum Entfernen eigener Aufnahmen auffordern zu können. Fotos, die man bei Flickr beseitige, tauchten im Anschluss auf Exposing.AI nicht mehr auf. (olb)