l+f: Wenn Computer Katzen in Hunde verwandeln

Automatische Bilderkennung lässt sich erstaunlich einfach austricksen. Doch schuld sind nicht etwa die KI-Verfahren, sondern ein Klassiker der Bildbearbeitung.

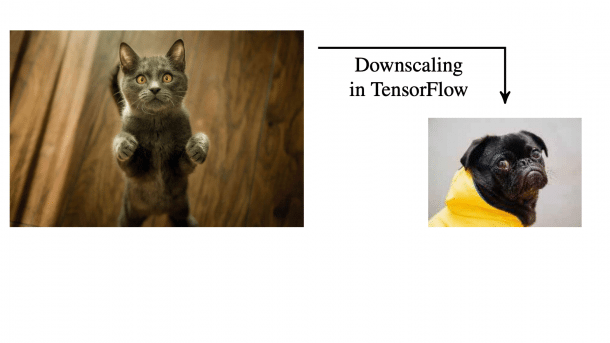

(Bild: Rieck et al)

Ein Bild zeigt offensichtlich lauter Schafe, doch der automatisierte Klassifizierungsprozess eines sozialen Netzes sortiert das Posting unter Wölfe ein. Das ist ein typisches Real-World-Beispiel einer interessanten neuen Angriffstechnik, die Wissenschaftler der Technischen Universität Braunschweig gerade untersuchen. Das Interessante daran: Die Schuldigen sind diesmal nicht die Machine-Learning-Verfahren, sondern der vermeintlich gut verstandene Vorgang des Skalierens.

(Bild: Xiao et al, Usenix )

Genau genommen ist die KI etwa auf Basis von Neuronalen Netzen sogar das Opfer der sogenannten Image-Scaling-Angriffe. Denn sie bekommt beim Beispielangriff der Braunschweiger Forscher ein süßes Katzenbild vorgesetzt und erkennt dies dann auch korrekt. Menschen hingegen sehen eine Tasse Kaffee. Das Problem tritt während des Pre-Processings des Bilds auf: Dabei wird das Bild mit dem Espresso nämlich typischerweise auf eines der Standardformate wie 224 × 224 oder 299 × 299 herunterskaliert.

Nicht alle Pixel sind gleich

Dieser Skalierungsprozess ist jedoch anfällig für gezielte Angriffe. Denn in das Runterrechnen gehen nicht etwa alle Pixel des Bilds gleichermaßen ein. Eine genaue Betrachtung der gängigen Skalierungsverfahren zeigt, dass einige wenige Pixel das Ergebnis ganz maßgeblich beeinflussen, während die Mehrzahl nur einen geringen Einfluss auf das erzeugte Bild haben. Schlussendlich muss der Angreifer also "nur" die wichtigen Pixel im Kaffee-Bild lokalisieren und durch Katzen-Pixel ersetzen.

(Bild: Rieck et al)

Das ist ein simples Optimierungsproblem, das Computer sehr gut lösen können. Für einen erfolgreichen Angriff streut man dann die Pixel des gewünschten Zielbilds passend ins Original ein. Bei der maschinellen Erkennung des resultierenden "Angriffsbilds" wird das Bild skaliert und dann der KI präsentiert. Diese bekommt also die Katze zu sehen. Ein Mensch hingegen sieht weiterhin nur einen leckeren Espresso.

Diese Downscaling-Angriffe könnten prinzipiell überall dort für Verwirrung und Chaos sorgen, wo maschinelle Erkennung von Bildinhalten zum Einsatz kommt. Das beginnt beim automatisierten Tagging von User-Content in sozialen Netzen und hört bei Gesichtserkennung im Security-Kontext noch lange nicht auf. Rieck et al beschreiben übrigens in ihrer Analyse der Downscaling-Angriffe nicht nur die zugrunde liegenden Mechanismen, sondern sie stellen auch Verfahren vor, wie man Bilder dagegen resistent machen könnte.

lost+found

Die heise-Security-Rubrik für Kurzes und Skurriles aus der IT-Security.

Alle l+f Meldungen in der Übersicht

(ju)