1,8 ExaFlops KI-Rechenleistung: Teslas Supercomputer für Autopiloten

5760 Nvidia-A100-Beschleuniger trainieren mit 1,5 Petabyte an Daten Teslas neuronales Netz, mit dessen Hilfe die Autos autonom fahren.

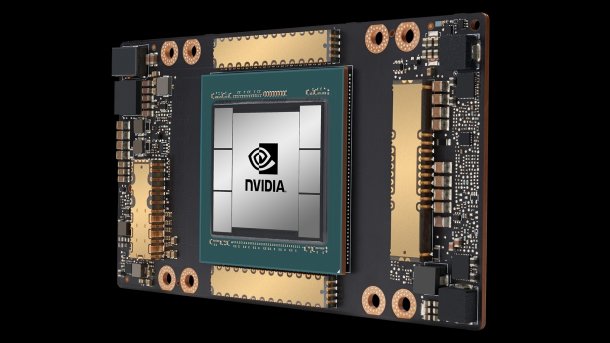

(Bild: Nvidia)

Tesla zeigt die neueste Ergänzung des eigenen Supercomputers, der für das Training des Autopiloten aller Tesla-Fahrzeuge verantwortlich ist. Zum Einsatz kommen 720 Nodes mit jeweils acht A100-GPU-Beschleunigern von Nvidia in der Version mit jeweils 80 GByte HBM2e-Stapelspeicher, also 5760 GPUs insgesamt.

Setzt man sämtliche integrierten Tensor-Kerne für KI-Berechnung ein, kommt dabei eine FP16-Rechenleistung von rund 1,8 ExaFlops zustande. Die Shader-Kerne schaffen knapp 56 FP64-PetaFlops. Ließe Tesla den eigenen Supercomputer in der Top500-Liste der weltweit schnellsten Supercomputer aufnehmen, käme er derzeit unter die ersten zehn Systeme. Private Firmensysteme landen dort erfahrungsgemäß aber nicht.

Videos by heise

Drei Cluster

Teslas Leiter des KI-Teams Andrej Karpathy hat die Details zum Supercomputer auf der Conference on Computer Vision and Pattern Recognition (CVPR) 2021 verraten (Youtube-Aufzeichnung mit Zeitstempel). Beim beschriebenen System handelt es sich um den neuesten von drei Clustern – die zur Verfügung stehende Gesamtrechenleistung ist also noch höher.

PCI-Express-SSDs mit einer Kapazität von 10 PByte begleiten die A100-GPU-Beschleuniger. Der Interconnect zum Verbund aller Nodes verarbeitet pro Sekunde 640 Terabit an Daten. Ein großer Teil des Trainingsmodell passt in die insgesamt fast 461 TByte an besonders schnellem HBM2e-RAM auf den A100-Karten.

Details zu den verbauten Prozessoren verrät Karpathy nicht. AMDs Epyc-CPUs oder Amperes Altra-ARM-Modelle wären naheliegend, da beide mit PCI Express 4.0 umgehen können, genauso wie die A100-Karten. Für Intels Ice-Lake-SP-Prozessoren dürfte es zeitlich knapp geworden sein.

1,5 Petabyte Trainingsdaten

Tesla verwendet für das Training des Autopiloten rund 1,5 Petabyte an Daten, die von Tesla-Fahrzeugen im echten Einsatz stammen. Jedes Auto zeichnet acht Video-Streams mit einer Auflösung von 1280 × 960 Pixeln und 36 Bildern pro Sekunde auf. Die Videos von einer Million Fahrzeugen mit einer Länge von je 10 Sekunden bilden die Trainingsgrundlage.

Das neuronale Netz wird im sogenannten Shadow-Modell trainiert: Die angelernte KI läuft bei echten Testfahrten mit, steuert aber das Auto nicht aktiv. Fehler werden im Anschluss bewertet und ausgebügelt.

(mma)