DragGAN: KI-gestützte, fotorealistische Bildbearbeitung per Drag & Drop

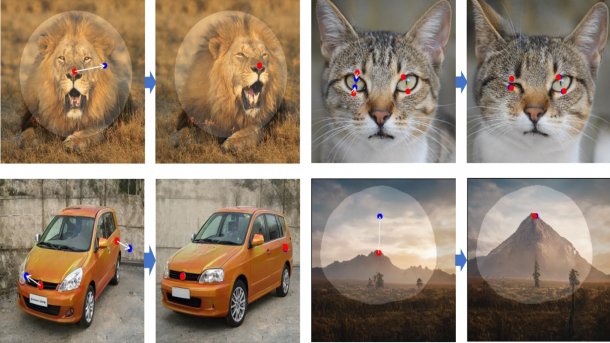

Mit dem KI-gestützten Bildbearbeitungstool "DragGAN" lassen sich Mimik, Posen und Perspektive von Objekten auf Fotos präzise mittels Drag & Drop steuern.

(Bild: Max-Planck-Institut für Informatik, Drag Your GAN: Interactive Point-based Manipulation on the Generative Image Manifold, Bearbeitung: heise online)

Klicken, Ziehen, Loslassen, fertig, so einfach kann Bildbearbeitung sein. Forschende des Max-Planck-Instituts für Informatik, des Saarbrücken Research Center for Visual Computing, Interaction and Artificial Intelligence (VIA), des MIT CSAIL und der Universität Pennsylvania haben eine KI-unterstützte Bildbearbeitungsmethode vorgestellt, mit der sich Mimik, Pose, Perspektiven und weitere Eigenschaften auf Fotos flexibel mittels Drag & Drop steuern lassen. Während die Bearbeitung fotorealistischer Inhalte in Photoshop und anderen Programmen bisher viel Können verlangt hat, reicht es bei DragGAN, Start- und Endpunkte auf einem Foto zu markieren, um etwa einen Mund zum Lächeln zu bringen, die Körperhaltung anzupassen, Kleidung zu verlängern oder die Perspektive zu drehen. Das GAN verfolgt die markierten Punkte und erzeugt Bilder, die den gewünschten Änderungen entsprechen – sofern die Bildinhalte den bisher trainierten Kategorien wie Menschen, Tiere, Landschaften oder Fahrzeugen entsprechen.

(Bild: MPI für Informatik)

Die Zukunft von Photoshop & Co.?

"Da diese Manipulationen auf der gelernten generativen Bildvielfalt eines GAN durchgeführt werden, führen sie zu realistischen Ergebnissen, selbst bei schwierigen Szenarien wie der Halluzination verdeckter Inhalte und der Verformung von Formen, die konsequent der Steifigkeit des Objekts folgen", schreiben die Wissenschaftler in ihrer Veröffentlichung für die im August stattfindende Computergrafikmesse SIGGRAPH23, das Interessierte beispielsweise bei arXiv herunterladen können. Bei der Ankündigung im Mai konnte man DragGAN nicht selbst ausprobieren, sondern lediglich Beispielvideos von der DragGAN-Webseite des Max-Planck-Instituts für Informatik anschauen:

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes Video (TargetVideo GmbH) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (TargetVideo GmbH) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes Video (TargetVideo GmbH) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (TargetVideo GmbH) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes Video (TargetVideo GmbH) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (TargetVideo GmbH) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Inzwischen hat Hauptautor Xingang Pan, wie im Mai angekündigt, den Quellcode auf GitHub veröffentlicht und Demos zum Experimentieren auf Hugging Face, OpenXLab sowie Google Colab bereitgestellt. Auch eine inoffizielle DragGAN-Implementierung vom OpenGVLab gibt es seit einigen Tagen. Wie viele andere Projekte nutzt DragGAN die für maschinelles Lernen optimierte Pythonbibliothek PyTorch. Zu den Hardware-Anforderungen ist bisher nichts bekannt. Die Autoren schreiben lediglich: "Dank der Effizienz unseres Ansatzes müssen die Nutzer nur wenige Sekunden warten und können die Bearbeitung fortsetzen, bis sie zufrieden sind." Noch befindet sich DragGAN in einem frühen Stadium, sodass die Qualität der Resultate trotz einer gewissen Extrapolationsfähigkeit derzeit von der Vielfalt der Trainingsdaten beeinflusst sei.

(Bild: MPI für Informatik)

Informationen zur Veröffentlichung des Quellcodes ergänzt.

(vza)