Künstliche Intelligenz: Was denkt sich eine KI?

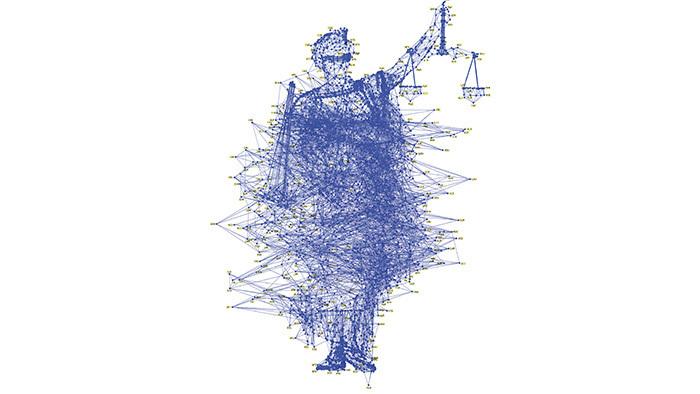

(Bild: Pablo Delcan)

Niemand weiß wirklich, wie selbstlernende Algorithmen zu ihren Schlüssen kommen. Weltweit arbeiten Forscher deshalb daran, maschinelle Entscheidungen nachvollziehbar zu machen.

Ob Banken, das Militär, Krankenhäuser, Versicherungen oder Behörden, immer mehr Branchen interessieren sich für Methoden des maschinellen Lernens, die automatische Entscheidungsfindungen immer mächtiger, aber auch immer undurchsichtiger machen. Anstatt klare Regeln vorzugeben, sollen diese Computerprogramme aus einer riesigen Menge an Beispielen lernen. Wie genau sie auf dieser Grundlage Entscheidungen treffen, kann jedoch kein Mensch nachvollziehen.

Nachvollziehbarkeit von KI-Systemen

Eine wachsende Zahl von Experten macht dieser Gedanke zunehmend nervös, berichtet Technology Review in seiner aktuellen Ausgabe (jetzt im Handel und im heise shop erhältlich [10]). "Das Problem ist schon jetzt aktuell, und es wird in Zukunft noch viel aktueller werden", sagt beispielsweise Tommi Jaakkola, der am Massachusetts Institute of Technology an Anwendungen des maschinellen Lernens forscht. "Egal ob es eine Investitionsentscheidung ist oder eine medizinische oder gar eine militärische Entscheidung: Wir wollen nicht auf eine Black Box vertrauen."

Die Zeit drängt, denn zumindest in Europa wollen die Gesetzgeber Lösungen sehen. Ab 2018 verlangt die Europäische Datenschutzgrundverordnung [11], dass Entscheidungen, die Personen beeinträchtigen können, nicht ausschließlich auf einer automatisierten Verarbeitung getroffen werden dürfen. Wenn Daten automatisiert verarbeitet werden, verlangt die Regelung Transparenz gegenüber den Betroffenen. Sie müssen Einblick in die Verarbeitungsvorgänge bekommen. Für Deutschland hat Justizminister Heiko Maas Anfang Juni auf einer Tagung des Ministeriums zudem die Einführung eines Antidiskriminierungsgesetzes für Algorithmen vorgeschlagen [12]. "Im Rechtsstaat sind alle Entscheidungen begründungspflichtig. Denn nur so kann überprüft werden, ob die Grundlagen, auf denen sie getroffen wurden, richtig, rechtmäßig und auch verhältnismäßig sind", sagte Maas. "Eine solche Überprüfbarkeit brauchen wir auch, wenn Algorithmen Entscheidungen vorbereiten."

Transparenz vs. Betriebsgeheimnis

Wie das gelingen kann, ist derzeit eine der spannendsten Fragen in der künstlichen Intelligenz. Ob sie gelöst wird, ist offen. Zum einen dürften sich die Firmen wehren, fürchten sie doch um ihre Betriebsgeheimnisse. "Zudem ist die Erklärbarkeit nur sehr vage formuliert", sagt der Internet-Rechtsexperte Jürgen Täger von der Universität Oldenburg. Er fürchtet, dass die Unternehmen Hintertüren finden werden, die jene Forderung nach Erklärbarkeit doch wieder einschränken.

Unabhängig davon arbeiten Forscher an technischen Verfahren, mit denen maschinelle Entscheidungen für Menschen nachvollziehbarer werden. Carlos Guestrin von der University of Washington beispielsweise hat eine Methode entwickelt, bei der die Software automatisch einige Beispiele für entscheidende Parameter in einem Datensatz markiert und sie dem Nutzer zusammen mit einer kurzen Erklärung präsentiert. Ein System, das beispielsweise Brustkrebs auf Mammografie-Aufnahmen erkennen soll, kann so jene Teile eines Bildes markieren, die es für entscheidend hält. Ein Algorithmus, der eine Mail eines Terroristen erkennen soll, könnte bestimmte Schlüsselwörter aus einer Nachricht markieren, sodass Menschen überprüfen können, ob die Parameter Sinn ergeben. Der Traum vieler Forscher wäre daher eine KI, die eine echte Unterhaltung führen und argumentieren kann. Aber "wir sind weit davon entfernt, eine wirklich interpretierbare KI zu haben", sagt Guestrin.

KI soll sich erklären

Andere Experten sind jedoch weitaus pessimistischer. "Selbst wenn dir jemand eine einleuchtende Erklärung für sein Verhalten gibt, ist sie sicherlich nicht komplett – und das Gleiche könnte auch für KI gelten", sagt Jeff Clune, der an der University of Wyoming mit tiefen neuronalen Netzen forscht, die sich selbst weiterentwickeln können. "Es könnte einfach ein Teil der Natur von Intelligenz sein, dass nur ein Teil davon rational zu erklären ist. Ein anderer Teil ist einfach instinktiv, unbewusst oder unergründlich."

(jle [13])

URL dieses Artikels:

https://www.heise.de/-3778547

Links in diesem Artikel:

[1] https://shop.heise.de/katalog/technology-review-8-2017

[2] https://www.heise.de/hintergrund/Jagd-auf-die-Gedanken-3852000.html

[3] https://www.heise.de/hintergrund/OePNV-Fahre-und-teile-3813169.html

[4] https://www.heise.de/hintergrund/Rettungspaket-fuer-Diesel-3848028.html

[5] https://www.heise.de/hintergrund/Fragen-Sie-Ihren-Account-nicht-den-Apotheker-3848030.html

[6] https://www.heise.de/hintergrund/Das-neue-Bild-der-Erde-3861818.html

[7] https://www.heise.de/hintergrund/Anzug-vom-Acker-3851998.html

[8] https://www.heise.de/hintergrund/Matthias-Spielkamp-3861820.html

[9] https://www.heise.de/hintergrund/Was-denkt-sich-die-KI-3851996.html

[10] https://shop.heise.de/katalog/technology-review-8-2017

[11] https://www.heise.de/news/Datenschutzgrundverordnung-wirft-ihre-Schatten-auf-die-IT-Sicherheit-3663868.html

[12] https://www.heise.de/news/Algorithmen-und-Scoring-Maas-fordert-digitales-Anti-Diskriminierungsgesetz-3761722.html

[13] mailto:jle@heise.de

Copyright © 2017 Heise Medien