Nvidia GB200 NVL2: Rackserver für große KI-Modelle

Nvidias Blackwell-Beschleuniger gibt es nun auch im Doppelpack als Rackeinschub mit bis zu 40 Petaflops Leistung. 2026 soll Rubin mit HBM4-Speicher folgen.

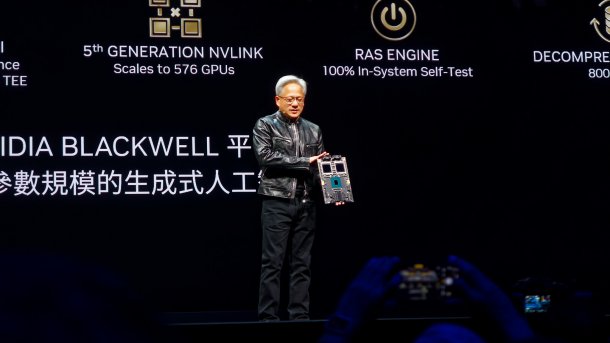

Jensen Huang mit GB200-Modul.

Nvidia-CEO Jensen Huang hat auf seiner Keynote im Vorfeld der Computex einen weiteren Baustein der Rechenbeschleunigerfamilie Blackwell vorgestellt. Unterhalb des im März 2024 vorgestellten Serverracks GB200 NVL72 bietet Nvidia fürs KI-Modell-Training den Rackeinschub GB200 NVL2 mit zwei GB200-Prozessoren an. Der Einschub ist im MGX-Format gefertigt und passt somit in bestehende Rechenzentren.

Videos by heise

Die beiden im Inneren eingelöteten GB200 bestehen jeweils aus einem Blackwell-Doppelchip sowie einer Grace-CPU mit 72 ARM-Kernen. Das Gesamtsystem soll laut Nvidia eine Rechenleistung von 40 Petaflops erreichen, allerdings gilt die Angabe für den bei KI-Anwendungen genutzten Datentyp FP4 mit lediglich 4 Bit Genauigkeit.

Der Rackserver bietet insgesamt 1,3 TByte Arbeitsspeicher, davon sind 384 GByte als schneller HMB3e-RAM an die Blackwell-Chips angeflanscht. Der Durchsatz des HBM3e-Speichers beträgt jeweils 8 TByte/s. Untereinander kommunizieren die GB200 über NVLink mit 2 x 900 GByte/s. Damit eignet sich der GB200 NVL2 zum Training großer Modelle für generative KI-Anwendungen.

Blackwell Ultra und Rubin folgen auf Blackwell

Zum Abschluss gab Jensen Huang noch einen Ausblick auf die kommenden KI-Beschleuniger-Generationen. 2025 soll die verbesserte Version Blackwell Ultra mit 12 HBM3e-Stacks folgen, bevor 2026 die Rubin-Plattform mit HBM4-Speicher antritt. Zu dieser gehören auch die ARM-CPU Vera sowie neue Netzwerk-Chips, um die Rechenbeschleuniger mit hoher Bandbreite miteinander zu verbinden.

(chh)