Swift-App für den Mac speziell für MLX-LLMs

Wer lokale große Sprachmodelle ausprobieren will, kann nun eine neue macOS-App testen. Sie hat sich auf die Apple-Silicon-optimierten MLX-LLMs spezialisiert.

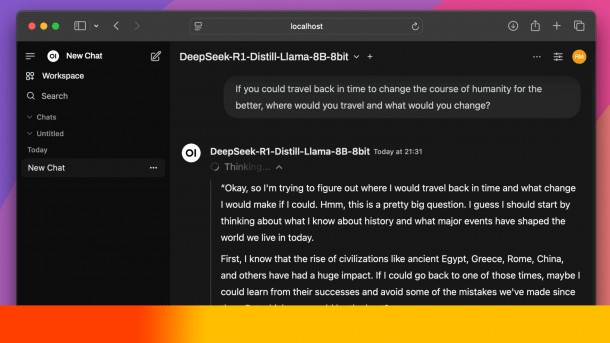

Pico AI Homelab auf dem Mac: Auf Wunsch direkt in der App oder via Browser.

(Bild: Starling Protocol Inc)

Experimente mit Large Language Models (große Sprachmodelle, LLMs) direkt auf dem heimischen Rechner liegen spätestens seit dem Hype um DeepSeek voll im Trend. Apple-Silicon-Macs sind je nach RAM-Ausbaustufe und enthaltener Prozessor-Variante gut dafür geeignet. Zudem hat Apple mit MLX ein spezielles Framework zur Beschleunigung von maschinellem Lernen (ML) für die ARM-Macs herausgebracht. Das "Array Framework for Apple Silicon" soll maschinelles Lernen auf aktuellen Macs besonders effizient machen. Eine neue Gratis-App, die im Mac App Store bereitsteht, hat sich nun auf Modelle spezialisiert, die die Technik verwenden.

Große Auswahl an Modellen

Pico AI Homelab stammt vom Anbieter Starling Protocol Inc und läuft ab macOS 15 (Sequoia). Ähnlich wie bei LM Studio, das als Electron-App läuft, ist es sehr einfach möglich, verschiedene Modelle auszuprobieren. Aktuell sollen es über 300 verschiedene sein. Neben der Distilled-Variante von DeepSeek R1 in verschiedenen Versionen sind auch Mistral, Meta Llama, Alibaba Qwen, Google Gemma und Microsoft Phi in verschiedenen Größen und Bauarten dabei. Diese sind jeweils für MLX angepasst, was sie performanter machen soll als GGUF-Modelle.

Videos by heise

Pico AI Homelab ist zu Ollama kompatibel und nutzt auch dessen API. So kann man auch alternative Chat-Apps wie Open WebUI, MindMac oder Ollamac mit der Anwendung nutzen. Generell läuft Pico AI Lab als lokaler HTTP-Server (localhost), die Chats werden also im Browser durchgeführt. Das gesamte System läuft offline und es werden keine Daten ins Internet geschickt. Pico AI Homelab sammelt selbst keine Nutzerinformationen.

Ansprüche an den Mac – und Nachteile

Pico AI Homelab läuft ab allen Apple-Silicon-Macs ab M1. Der minimale RAM-Ausbau muss bei 16 GByte liegen, mehr RAM ab 32 GByte ist für große Sprachmodelle aber äußerst sinnvoll. Kommandozeilen-Skills sind für die Verwendung von Pico AI Homelab nicht notwendig. "Dank der geführten Installation mit nur einem Klick können selbst Anfänger schnell loslegen, während erfahrene Benutzer von flexiblen Anpassungsoptionen profitieren", schreiben die Macher.

Die App ist derzeit komplett kostenlos, ob sich das später ändert, ist unklar. API-Kosten oder Abonnementgebühren bei den KI-Anbietern fallen nicht an. Bei lokalen LLMs sollte man allerdings nicht zu viel erwarten: Aufgrund der deutlich geringeren Rechenleistung gegenüber Servermodellen sind die Outputs schlechter, zudem gibt es mehr Halluzinationen. Zum "Spielen" machen lokale Modelle aber durchaus Freude.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externer Preisvergleich (heise Preisvergleich) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (heise Preisvergleich) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

(bsc)