IBM: "Quantenalgorithmus einfacher erklärbar als ChatGPT"

Scott Crowder, Vice President Quantum bei IBM über maschinelles Lernen auf dem Quantencomputer sowie Qualität und Quantität von Qubits.

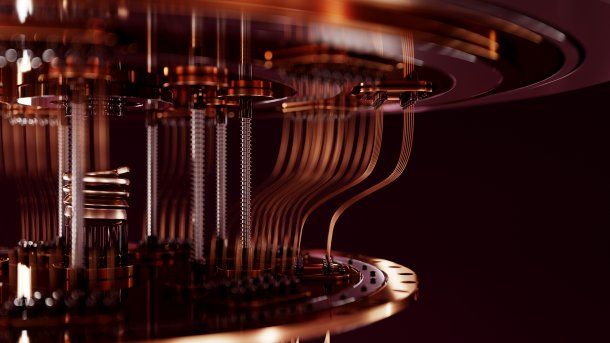

(Bild: Bartlomiej K. Wroblewski/Shutterstock.com)

Bisher haben Quantencomputer zwar immer noch nicht ihren praktischen Nutzen bewiesen. Es gibt aber extrem hohe Erwartungen in diese Technologie – vor allem in der Kombination von Quantencomputern und maschinellem Lernen – Quantum Machine Learning. Wie weit die Technologie ist, und wofür sie angewendet werden kann, erklärt Scott Crowder, Vice President Quantum bei IBM im Interview mit MIT Technology Review.

Wie weit ist IBM beim Quantum Machine Learning?

Lassen Sie mich damit beginnen, wo wir beim Quantencomputing stehen. Wir sind jetzt an einem Punkt angelangt, an dem wir Quanten-Systeme haben, die größer sind, als das, was man mit einem klassischen Computer simulieren kann. Jedenfalls nicht mehr mit klassischen Brute-Force-Methoden.

(Bild: IBM / Ryan Lavine)

Wir haben also das Zeitalter der Simulatoren hinter uns, so könnte die kurze Antwort lauten. Das ist dieses Jahr passiert. Es ist tatsächlich von Nutzen, eine Berechnung auf einem Quantencomputer durchzuführen, im Gegensatz zu einer Berechnung auf einem klassischen Computer oder einer klassischen Simulation.

Videos by heise

Das bedeutet aber noch nicht, dass Quantencomputing einen geschäftlichen Wert hat. Es bedeutet nur, dass ich diese Basisberechnung, die ich durchführen möchte, jetzt auf einem Quantencomputer effektiver durchführen kann als mit einer klassischen Simulation.

Das gilt auch für Bereiche wie das maschinelle Lernen, die in die gleiche Kategorie von Mathematik fallen und bei denen es einen exponentiellen Vorteil gibt, wenn man sie auf einem Quantencomputer ausführt.

Warum?

Grob gesagt, geht es um das Auffinden von Datenmustern, wenn die Daten eine komplexe Struktur aufweisen. Wir nutzen die höhere Dimensionalität von Quantencomputern, um Techniken des maschinellen Lernens zu entwickeln, die es ermöglichen, Muster auf eine andere Art und Weise zu finden, als dies mit klassischen Methoden möglich ist.

Es geht um Bereiche wie der Betrugserkennung, der besten Behandlung für einen Patienten auf der Grundlage elektronischer Gesundheitsdaten, der Erkennung von Mustern in der Kundenabwanderung zur Verbesserung der Kundenzufriedenheit und der Kundenbindung.

Wenn wir über maschinelles Lernen sprechen, sprechen wir über viele, viele Daten. Quantencomputing ist nicht dafür bekannt, dass es gut mit vielen Daten umgehen kann. Ist das ein Problem?

Ich gebe Ihnen ein Beispiel aus dem maschinellen Lernen. Beim maschinellen Lernen verwenden viele Leute eine Variante einer Support-Vektor-Maschine zur Klassifizierung. Der Trick dabei ist, dass man die Daten in eine höhere Dimension transformiert, damit die Maschine klassifizieren kann.

In der Quantentheorie kann man einen viel komplexeren Kernel erstellen. Man kann die Daten auf einen komplexeren Raum abbilden und eine Quantenhyperebene finden – wie auch immer man sich das vorstellen will –, um die Daten auf eine Art und Weise in Gut und Schlecht zu trennen, wie es auf klassischem Wege nicht möglich ist.

Wenn man Daten erhält, die man klassifizieren soll, ist das meist kein Big-Data-Problem. Die eigentliche Herausforderung bei der Implementierung besteht darin, dass unsere Quantencomputer zwar für einen Quantencomputer schnell sind, aber im Vergleich zu klassischen Computern immer noch langsam sind. Es kann also etwa eine Sekunde dauern, bis man das Ergebnis erhält, bis man weiß, ob es sich um ein falsches oder ein richtiges positives Ergebnis handelt. Aber in manchen Situationen, zum Beispiel wenn eine Kreditkarte durch einen Scanner gezogen wird, muss es viel schneller gehen.

Gemeinsam mit unseren Partnern versuchen wir daher, nicht nur den algorithmischen Teil zu verstehen, sondern auch die Frage, wie sich der Algorithmus in den Arbeitsablauf einfügt.

Kann man den Arbeitsablauf so ändern, dass man zum Beispiel nicht jede einzelne Kreditkartentransaktion durch den Quantencomputer schickt? Nur das, was ein klassischer Algorithmus für einen möglichen Betrug hält. In diesem Fall halten Sie den Zahlungsvorgang kurz an, und fünf oder sechs Sekunden später erhalten Sie das Ergebnis vom Quantencomputer und können daraufhin Maßnahmen ergreifen.

Wie viele Qubits braucht man, um in praktisch relevanten Fällen etwas zu klassifizieren?

Das hängt von dem Problem ab. Wenn man ein Problem auf einem Quantencomputer lösen will, gibt es zwei wichtige Messgrößen: die Breite, das heißt die Anzahl der Qubits, und die Tiefe, das heißt die Anzahl der Quanten-Gatter, die man ausführen kann. Die Rechentiefe hängt von der Art der Fehlerunterdrückung, der Fehlerkorrektur, der Qualität der Qubits und all diesen Dingen ab.

Der Durchbruch in diesem Jahr bestand darin, dass es uns gelang, die Fehlerrate so zu reduzieren, dass wir eine ausreichend lange Berechnung durchführen konnten, die einen echten rechnerischen Vorteil gegenüber einer klassischen Berechnung bietet. Wir sind der Meinung, dass die Breite des Schaltkreises für viele der maschinellen Lerntechniken wahrscheinlich nicht der begrenzende Faktor ist. Mit über 100 Qubits hat man bereits genug Variablen, um mit der klassischen Routinen mithalten zu können.

Aber unsere bisherigen Daten sind heuristisch. Wir müssen also weiter daran arbeiten, um zu verstehen, ob die Vorteile der Quantenmethode bei einer Skalierung von 16 Variablen auf 50 Variablen, 70 Variablen und 120 Variablen immer noch bestehen. Der Trend sieht gut aus, aber es gibt noch einiges zu tun.

Es tut mir leid, dass ich Ihnen eine sehr lange Antwort gebe, aber wir denken, dass Hunderte von Qubits für die meisten der Klassifizierungsbeispiele, die wir gesehen haben, ausreichen werden. Wir müssen nur in Zusammenarbeit mit unseren Kunden nachweisen, dass der Vorteil für ihren speziellen Datensatz bestehen bleibt.

"Das Quantenmodell erkennt tatsächlich andere Muster in den Daten"

Es gibt also einen Punkt, an dem Sie sagen können, dass Sie mit einem Quantensystem Klassifizierungen durchführen können, die Sie mit einem klassischen System nicht durchführen können. Ist das richtig?

Ja, das ist richtig. Die Frage ist, ob es für Ihren speziellen Anwendungsfall von Nutzen ist. Wir können beweisen, dass man diese Art von Berechnung theoretisch auf einem Quantencomputer besser durchführen kann als auf einem klassischen Computer. Aber wir müssen beweisen, dass man dadurch einen Nutzen hat. Es hängt von der Datenstruktur ab.

Sie lassen also alles durch das klassische Modell laufen. Sie lassen alle positiven Ergebnisse durch das Quantenmodell laufen. Das Quantenmodell erkennt tatsächlich andere Muster in den Daten und ist bei bestimmten Datenstrukturen im wirklichen Leben genauer, zum Beispiel bei Finanzdienstleistungen, Daten für Betrug.

Sie werden also bei der klassischen Klassifizierung andere falsch-positive Ergebnisse sehen als bei der Quantenklassifizierung, bei der einige Betrugsfälle besser erkannt werden. Die klassische Methode eignet sich besser für einige der anderen. Wenn man sie also einsetzt, kann man seinen Gesamtklassifizierungsprozentsatz um ein paar Prozentpunkte erhöhen.

Und bei einigen dieser Beispiele sind ein paar Prozentpunkte Verbesserung für einige dieser Finanzinstitute eine Menge Geld wert.

Bei der Künstlichen Intelligenz haben wir bereits Diskussionen über Blackbox-Systeme, Vertrauen und Erklärbarkeit geführt, aber jetzt bauen Sie eine noch bessere, noch schwärzere Blackbox. Sehen Sie da kein Problem?

Nun, in gewisser Weise ist Quantencomputing erklärbarer als Deep Learning. Quantenalgorithmen sind anders. Es sind andere Algorithmen, die eine andere Art der Informationsverarbeitung verwenden. Aber es sind immer noch Algorithmen, die man aufschreiben und erklären kann. Nur weil es sich um Quanten handelt, heißt das nicht, dass man es nicht aufschreiben und erklären kann. Ich würde sagen, dass es aus meiner Sicht sogar einfacher ist, Ihnen zu erklären, warum ein Quantenalgorithmus funktioniert, als wie Chat-GPT funktioniert.

Wir haben über Klassifizierung gesprochen. Gibt es noch andere Ideen für maschinelles Lernen mit Quanten? Können Sie auch andere Dinge tun? Kann man so etwas wie Deep Learning machen?

Ja, man beschäftigt sich mit neuronalen Netzen auf Quantenbasis. Ich meine, das sind aktive Bereiche der Forschung. Und wie Sie wissen, steckt die Quantenforschung noch in den Kinderschuhen.

Ich denke, dass es beim Quantencomputing sowohl technische als auch algorithmische Fortschritte gibt. Für mich sind die algorithmischen Fortschritte eher langsam und stetig, und dann gibt es eine Diskontinuität, dann verläuft die Entwicklung wieder langsam und stetig.

Es könnte also durchaus eine Diskontinuität bei den neuronalen Quantennetzwerken geben. Es gibt bisher einige interessante heuristische Ergebnisse. Ich meine, gerade dieses Jahr gab es eine große Verbesserung des Shor-Algorithmus. Den Shor-Algorithmus gibt es schon seit 30 Jahren. Dieses Jahr gab es eine große Verbesserung. Ich erinnere mich nicht mehr an den genauen Faktor X, aber es ist ein ziemlich großer Faktor X in Bezug auf die Verringerung der für die Ausführung des Shor-Algorithmus erforderlichen Ressourcen.

Sie sprachen von der Breite und Tiefe von Quantenchips. Konzentrieren Sie sich mehr auf die Qualität oder mehr auf die Anzahl der Qubits? Oder machen Sie beides?

Es ist beides. Für die Leistung braucht man Skalierbarkeit, man braucht Qualität, und man braucht Ausführungsgeschwindigkeit. Bei den meisten Elementen unserer Roadmap, die sich mit der Skalierung befassen, haben wir bereits das erreicht, was wir aus technischer Sicht tun müssen, um zu wissen, wie man skaliert. Die Art und Weise, wie wir skalieren werden, ist modular. Anstatt also die Größe eines einzelnen Prozessors monolithisch zu erhöhen, werden wir uns mehr darauf konzentrieren, wie wir größere Systeme aus modularen Komponenten aufbauen können.

Ein großer Teil der Roadmap konzentriert sich also auf die einzelne QPU und darauf, wie wir ihre Qualität verbessern. Wir sagen nicht, dass Größe keine Rolle spielt. Wir konzentrieren uns aber auf Innovationen im Bereich der Qualität, denn auf der Qualitätsseite gibt es noch mehr zu tun. Erstens in Bezug auf die Verbesserung der Fähigkeiten zur Fehlerminimierung. Dann durch die Implementierung von Fehlerkorrekturen, die es uns ermöglichen, einen disruptiven Sprung in der Tiefe zu machen.

Als wir diese Roadmap veröffentlicht haben, haben wir ausdrücklich gesagt, wie tief man unserer Meinung nach mit dem System zuverlässig gehen kann. Das ist also der Heron-Chip, und dann gab es eine Zahl wie 5k. 5k ist die Anzahl der Gatter, also die tatsächliche Tiefe, die man erreichen kann. Und wir haben explizit gesagt, welche Erwartungen wir Jahr für Jahr im Rahmen der Roadmap erfüllen müssen.

Wir versuchen sicherzustellen, dass wir den Hype durchbrechen und sehr klar sind. Deshalb veröffentlichen wir eine so detaillierte Roadmap. Und ich glaube, das kommt sowohl bei unseren Partnern aus Wissenschaft und Forschung als auch bei unseren Partnern aus der Industrie sehr gut an, weil sie sehen können, ob wir noch auf dem richtigen Weg sind oder nicht.

Und da wir gerade der ganzen Welt unseren Fahrplan für die nächsten zehn Jahre mitgeteilt haben, sollten wir ihn auch besser einhalten, denn jetzt haben wir allen anderen Unternehmen, den Chinesen und allen anderen gesagt, dass sie genau wissen, was wir tun und bis wann wir es tun werden. Das ist also großer Anreiz für uns, es zu schaffen.

(wst)