KI-Beschleuniger: USA wollen die GPU-Verkäufe der gesamten Welt steuern

Neue US-Regeln beträfen auch deutsche Unternehmen. GPUs zur KI-Entwicklung sollen künftig strikten Auflagebeschränkungen unterliegen.

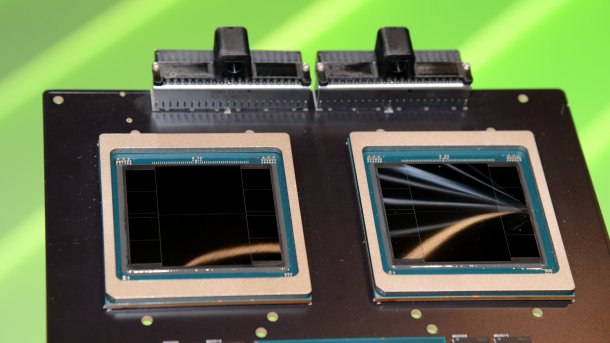

Eine Server-GPU, die sicher von den neuen Einschränkungen betroffen wäre: Nvidias Blackwell GB200.

(Bild: c't / csp)

Die Noch-US-Regierung unter Joe Biden will die Verbreitung von US-Technologie im Ausland in Bezug auf KI-Algorithmen weiter einschränken. Dazu hat sie ein umfassendes "Export Control Framework for Artificial Intelligence Diffusion" vorgeschlagen, das jetzt einer 120-tägigen Kommentarphase unterliegt und dann unter Trump ab April verabschiedet werden könnte. Laut eigener Argumentation soll das die Sicherheitsinteressen der USA stärken, insbesondere in Bezug auf China.

18 privilegierte Länder

Statt wie bisher eine sogenannte Entity-Liste mit Ländern zu pflegen, für die spezielle Exportregeln gelten, wollen die USA den Spieß umdrehen: Chipdesigner wie AMD, Nvidia und Intel dürften ihre GPU-Beschleuniger fürs KI-Training dann nur noch in 18 Ländern uneingeschränkt verkaufen. Es geht um "fortschrittliche GPUs", wobei deren Definition bisher unklar ist.

Immerhin machen festgelegte Ausnahmen klar: Privatanwender und einzelne Gaming-Grafikkarten sind davon nicht betroffen.

Die 18 Länder sind Australien, Belgien, Dänemark, Deutschland, Finnland, Frankreich, Irland, Italien, Japan, Kanada, die Niederlande, Neuseeland, Norwegen, Südkorea, Spanien, Schweden, Taiwan und das Vereinigte Königreich. Alle anderen Länder werden in Tier-2- und "bedenkliche" Regionen aufgeteilt.

Relevant ist aber nicht bloß der Hauptsitz einer Firma, die Beschleuniger kaufen wollen, sondern auch, wo die Chips zum Einsatz kommen. Möchte etwa ein deutsches Unternehmen ein Rechenzentrum in Island bauen, müsste es eine Sicherheitsprüfung durch das US-amerikanische Bureau of Industry and Security (BIS) bestehen. Es erhält so den Status "Universal Verified End User" (UVEU). Dann dürfen maximal 7 Prozent der weltweiten Rechenkapazität einer Firma im Ausland stehen.

Firmen in Tier-2-Ländern erhalten mit den gleichen Sicherheitsbestimmungen den Status "National Verified End User" (NVEU) und dürfen bis zu 320.000 GPUs in den nächsten zwei Jahren kaufen. Die Limits gelten herstellerübergreifend, also müsste eine Abstimmung zwischen AMD, Nvidia & Co. erfolgen.

Starker Einschnitt für die anderen

Wer in keinem der 18 Partnerländern operiert und keinen NVEU-Status erhält, darf pro Land 50.000 GPUs kaufen. Betreibt eine Firma etwa Rechenzentren in zwei Ländern, müsste das Limit bei 100.000 GPUs liegen. Offenbar gilt das ebenfalls für einen 2-Jahres-Zeitraum.

Mit Regierungsabkommen sollen sich das 50.000er-Limit verdoppeln lassen. Bei den Abkommen geht es im Entwurf um Übereinstimmungen in den Feldern "Exportkontrolle, saubere Energie und Technologiesicherheit".

Ausgenommen von den Limits sind Bestellungen von maximal 1700 GPUs. Solche Mengen reichen heutzutage nur noch für kleinere Rechenzentren. Fraglich ist, wie die USA gegen viele zerstückelte Bestellungen – gegebenenfalls über Scheinfirmen – vorgehen wollen.

Überwachung von KI-Modellen

Abseits der Exporteinschränkungen für Hardware wollen die USA die Verbreitung von großen KI-Modellen beziehungsweise deren zugrundeliegenden Trainings-Gewichten einschränken. Ein Entwurf sieht Genehmigungsverfahren vor, wenn eine Firma Modelle ab einer festgelegten benötigten Rechenleistung "exportieren, reexportieren oder transferieren" möchte. Das kann etwa ein KI-Modell sein, das in einem Partnerland trainiert wurde, und dann für einen KI-Assistenten ins Ausland lizenziert werden soll.

Videos by heise

Einzige omnipräsente Voraussetzung: Der Algorithmus muss mithilfe von US-Technologie entstanden sein. Wenn man kleinlich ist, kann man das für jedes KI-Modell herbei argumentieren, etwa durch den Einsatz populärer US-amerikanischer EDA-Tools bei der Chipentwicklung.

Die initiale vorgeschlagene Grenze liegt bei 100 Quadrillionen (10^26) Rechenoperationen über die gesamte Trainingsdauer hinweg. Moderne Supercomputer mit einer KI-Rechenleistung von 200 Exaflops (etwa im Datenformat INT8) brauchen für so einen Wert knapp zwei Monate Rechenzeit. Die Einschränkung betrifft damit die größten KI-Modelle.

Das gilt für geschlossene Modelle ("closed-weight") und nicht für quelloffene. Für geschlossene Modelle tritt die Grenze außer Kraft, wenn es eine quelloffene Alternative gibt.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externer Preisvergleich (heise Preisvergleich) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (heise Preisvergleich) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

(mma)