Das Kind im Roboter

Vom episodischen Gedächtnis für Roboter bis zum simulierten Hirn, das Humanoide steuert: Die Grenzlinie zwischen Lebewesen und Maschine wird zunehmend unschärfer, berichtet Technology Review in seiner aktuellen Ausgabe.

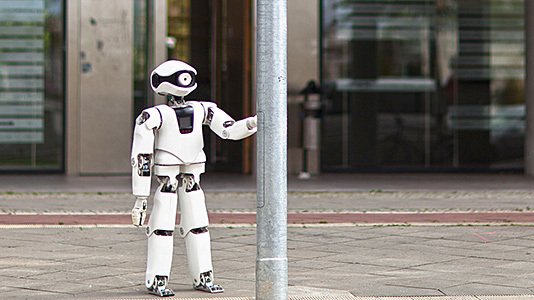

Der Roboter Myon verfügt über ein episodisches Gedächtnis, in dem Sensordaten "aufmerksamkeitsgefiltert" gespeichert werden.

(Bild: Beuth-Hochschule Berlin)

Was ist Roboter, was ist Mensch? Was ist Maschine, was Lebewesen? Wer eindeutige Antworten erwartet, wird zunehmen enttäuscht: Die Grenzen verwischen, berichtet Technology Review in seiner aktuellen Ausgabe. Dafür verantwortliche Techniken reichen vom episodischen Gedächtnis für Roboter bis zum simulierten Hirn, das Humanoide steuert.

In der Arbeitsgruppen von Verena Hafner an der Humboldt-Universität Berlin arbeiten Robotiker beispielsweise daran, Robotern wie Babys lernen zu lassen. Die Naos führen zunächst rein zufällige Bewegungen aus. „Wenn ich ein bestimmtes Kommando auf den Arm gebe, lernt der Roboter, an welcher Stelle er anschließend seine Hand sieht“, sagt Hafner. Das kann man natürlich auch umdrehen: Wollen die Roboter ihre Hand an eine bestimmte Stelle bewegen, wissen sie schon ungefähr, welche Bewegung dafür nötig ist. „So funktioniert das auch bei Kleinkindern", sagt Hafner. Die bewegen Arme und Beine schon vor der Geburt“. Mit dem erlernten Wissen kann der Roboter nun auch Handlungen „mental simulieren“, erklärt Hafner. Er kann zum Beispiel prüfen, welchen Arm er bewegen sollte, um einen Gegenstand zu greifen - oder ob er dazu ein Werkzeug benutzen sollte.

Matthias Rolf von der University of Osaka arbeitet daran, seinen Robotern „ein Belohnungssystem“ einzuprogrammieren – eine Art inneren Kompass. „So wie Kinder einfach aus Interesse ständig neue Sachen ausprobieren“, so sollen auch die Roboter ihre konkreten Handlungen aus dem Wertesystem ableiten. Mathematisch konnte Rolf bereits zeigen, dass das funktioniert. Nun will er die Idee in Robotern implementieren. Dabei geht es jedoch nicht nur um ein neues Verfahren der Programmierung, sondern um mehr. „Es soll nicht nur so aussehen, als ob ein Roboter willentlich einen Ball verfolgt“, erklärt der Informatiker. „Es geht darum, dass dieser Roboter eine Vorstellung davon hat, was er tun will.“

Auch Manfred Hild von der Beuth-Hochschule Berlin experimentiert mit einem Roboter, der - in gewisser Weise - seine eigenen Ziele verfolgt: „Wir haben an die 200 Sensoren im Roboter: Kraft, Bewegung, Geschwindigkeit, Spannungen, Ströme, Klänge – und natürlich liefert auch die Kamera jede Menge Informationen“, erklärt Hild. „Gespeichert wird aber nur das, worauf der Roboter seine Aufmerksamkeit gelenkt hat.“ Das sind vor allem neue Sinneseindrücke – Dinge und Personen, die der Roboter Myon bisher noch nicht gesehen hat. „Dreamline“ nennen die Forscher diese Datei – Ströme, Spannungen, Gelenkwinkel, Audio-Schnipsel und eine Mischung aus Überblicks- und Detailaufnahmen der Kamera. Wenn Myon nichts für ihn Spannendes erlebt, wenn also keine externen Eindrücke die Aufmerksamkeit binden, durchstöbern Algorithmen die Gedächtnisspur. Sie suchen nach besonders häufig auftretenden Mustern: Sitzen und Stehen zum Beispiel. Alle derartigen Sensordaten werden in einem Symbol „gekapselt“ und in einem zweiten Speicherbereich – dem „Weltwissensgedächtnis“ – abgelegt.

Bislang ist die Rechenkapazität, mit der Roboter ihre Sinneseindrücke verarbeiten, noch begrenzt. Aber diese Einschränkung könnte schon bald nicht mehr gelten. Mit einer Milliarde Euro fördert die EU das „Human Brain Project“, in dem Forscher ein Gehirn im Rechner simulieren wollen. Aber nicht nur das: Sie wollen die Simulation im Rahmen des Neurobotics-Teilprojektes anschließend mit einem Roboter verbinden.

Auf dem Weg dahin sind die Forscher aus München, Karlsruhe, Genf und Pisa schon erstaunlich weit gekommen: Teile eines Mäusegehirns können sie bereits simulieren. Nun arbeiten sie daran, die Simulation mit einem – zunächst ebenfalls simulierten – Mäusekörper zu verbinden. Berührt die virtuelle Maus mit ihren Schnurrhaaren beispielsweise eine virtuelle Wand, feuern die entsprechenden Nervenzellen in der Hirnsimulation. Prinzipiell klappt das schon. Nun verknüpfen die Wissenschaftler mehr und mehr Hirnareale mit Sensoren und arbeiten am Feintuning ihres Modells. Im nächsten Schritt wollen sie mit dem virtuellen künstlichen Hirn die Bewegung der Maus steuern. Funktioniert auch das, soll die Hirnsimulation reale Hardware ansteuern. (wst)