Google DeepMind: Sprachsynthese soll menschlicher klingen

Die Londoner Google-Tochter DeepMind hat ein neuronales Netz namens WaveNet vorgestellt, das natürlich klingende Sprache erzeugt. Der auf tiefen Convolutional-neuronal-Networks basierende Algorithmus spricht, liest und macht sogar Musik.

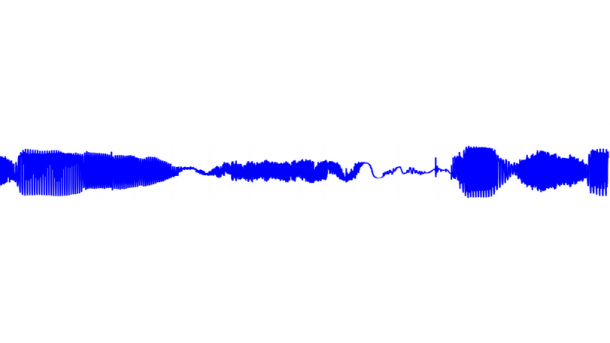

Wellenform einer von WaveNet erzeugten Sprachsequenz.

(Bild: DeepMind)

Nach Go-Spielen auf Weltmeisterniveau nimmt sich die Google-Tochter DeepMind nun der Sprachsynthese an. Ihre neueste Kreation "WaveNet" produziert mit Convolutional-neuronal-Networks Sprache, die menschliche Tester in einem Blindtest deutlich natürlicher empfanden, als die besten bisherigen Verfahren. Die Forscher haben einen so allgemeinen Ansatz gewählt, dass das tiefe neuronale Netz nicht nur Texte vorlesen, sondern auch sinnlose sprachähnliche Laute und sogar Musik erzeugen kann. In seinem Blog zeigt DeepMind kurze Audiobeispiele zum Probehören und Vergleichen.

DeepMind hat für WaveNet einen eher ungewöhnlichen Ansatz gewählt. Bisherige Systeme zur Sprachsynthese nutzen entweder eine Bibliothek aufgenommener Sprachschnipsel, die ein Hidden-Markov-Model auswählt, oder rekurrente neuronale Netze, die Parametersätze für Vocoder raten. Der erste Ansatz klang bisher am natürlichsten, kann aber nicht anders betonen als die Sprecher bei der Aufnahme. Die Vocoder-basierte Methode konnte zwar beliebig betonen, sprach aber undeutlich.

Verfahren aus der Bildanalyse

WaveNet nutzt Convolutional-neuronal-Networks, die bisher vor allem in der Bildanalyse eingesetzt werden. Das Verfahren galt als ungeeignet für Audiosignale, da ein Sample dort von Tausenden vorherigen Samples abhängt und die zu lernenden Filter im neuronalen Netz zu groß wären. DeepMind hat die Komplexität dadurch reduziert, dass die Forscher die Filter in verborgenen Schichten immer weiter in die Vergangenheit versetzten. So kann der Algorithmus abstrahierte Informationen aus länger vergangenen Samples nutzen, ohne dass die Komplexität Überhand nimmt. In der getesteten Umsetzung hatte WaveNet so ein Kurzzeitgedächtnis über 240ms. Dieses trotzdem kurze Gedächtnis erklärt, warum die sinnlos erzeugte Sprache keine langen Wörter aber beispielsweise Atmen enthält.

(Bild: DeepMind)

Um sinnvolle Sprache zu erzeugen, speist DeepMind auf unterster Ebene zusätzlich Informationen zu Phonemen, Silben, Wörtern und der Position im Satz ein. Auf oberster Ebene kommt die Information hinzu, die Stimme welches Sprechers WaveNet erzeugen soll. WaveNet berechnet dann für jedes Sample eine Wahrscheinlichkeit für sämtliche möglichen Zahlen bei einer Sample-Auflösung von 8 Bit aus. WaveNet behandelt die Erzeugung von Audiosignalen also als Klassifikationsproblem und rechnet dieses sechzehntausendmal pro Sekunde. Das Paper zum Verfahren geht noch auf einige Ergänzungen und Details zum Test des Verfahrens ein.

Für die Praxis noch zu komplex

Auch wenn DeepMind beeindruckende Ergebnisse zeigt, dürfte es noch eine Weile dauern, bis WaveNet die Stimme für Google Now berechnet. Der Rechenaufwand für die Sprachsynthese Sample-für-Sample mit tiefen neuronalen Netzen dürfte auch in Googles Cloud vorerst noch zu groß sein. Um mit WaveNet Sprache auf Mobilgeräten zu erzeugen, müsste sich deren Hardware vorher deutlich verbessern. (pmk)