Style-Transfer mit neuronalen Netzen geht jetzt auch fotorealistisch

Mit einem neuronalen Netz lassen sich Fotos an den Stil einer Vorlage anpassen. Das Ergebnis sieht wie gemalt aus – der Effekt ist bekannt von Apps wie Prisma und Artisto. Ein neu erschienenes Paper erklärt, wie das auch fotorealistisch geht.

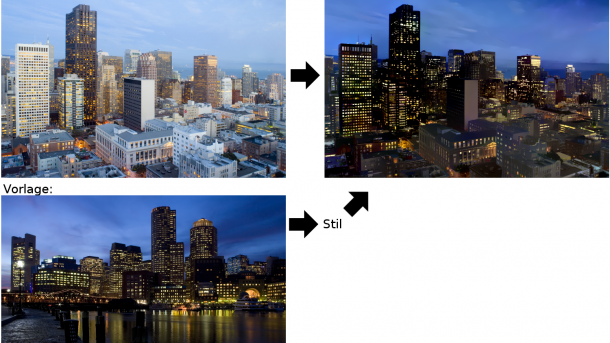

Aus einem Originalbild und einer Foto-Vorlage berechnet Deep Photo Style Transfer ein neues Bild mit dem Inhalt des Originals aber dem Stil der Vorlage.

(Bild: Fujun Luan et al. - Deep Photo Style Transfer)

Einem Team von der Cornell-Universität und Adobe ist es gelungen, mit einem neuronalen Netz den Stil von Fotos zu übertragen, ohne dass dabei störende Verzerrungen entstehen. Das Ergebnis sieht fotorealistisch aus.

Das Übertragen des Stils einer meist gemalten Vorlage auf Fotos war mit dem Algorithmus "Neural Style" schon länger möglich. Populär wurde der Algorithmus über die Apps Prisma und Artisto. Er verfremdet das Foto in einer Weise, die wie Malerei aussieht. Dieser Effekt entstammt aber nur zum Teil der Bildvorlage, sodass auch dann gemalt wirkende Bilder entstehen, wenn die Vorlage ein Foto ist. Der jetzt vorgestellte "Deep Photo Style Transfer" unterdrückt die malerischen Verzerrungen.

Bilderkennung zweckentfremdet

Der Stiltransfer benutzt ein auf Bilderkennung trainiertes neuronales Netz. Solche Netze erkennen auf den Ebenen nah am Eingabebild zunächst kleine Strukturen wie Kanten und Ecken. Auf tieferen Ebenen werden die erkannten Muster immer abstrakter und größer. Die Idee besteht darin, ein Bild zu suchen, das auf manchen Ebenen ähnliche Neuronenaktivität wie beim Eingabebild und auf Anderen Aktivität wie bei der Stilvorlage hervorruft. Für die Suche nach einem solchen Bild eignen sich die gleichen Optimierungsalgorithmen, die sich auch fürs Training von neuronalen Netzen anbieten.

Für Deep Photo Style Transfer haben die Forscher die Optimierungsfunktion des bekannten Algorithmus um einen Term erweitert, der nur dann klein bleibt, wenn lokale Strukturen in den Helligkeitswerten erhalten bleiben. Außerdem segmentieren sie das Foto semantisch (Wasser, Bäume, Gebäude, etc.), um nur den Stil dieser Bereiche aus der Vorlage zu übertragen. Ohne die Segmentierung besteht die Gefahr, dass beispielsweise der Stil von Gebäuden in den Himmel blutet, weil die Vorlage ein anderes Verhältnis zwischen Gebäuden und Himmel zeigt als das bearbeitete Foto.

Details erklärt das frei verfügbare Paper. Matlab-Code zum selbst ausprobieren gibt es hier. (pmk)