Interview mit Nvidias Vice President zu Volta: Transferrate wichtiger als mehr Speicher

Volta ist die erste GPU, die sich für HPC- und Deep-Learning-Anwendungen gleichermaßen eignet, sagt Nvidias Vice President Ian Buck.

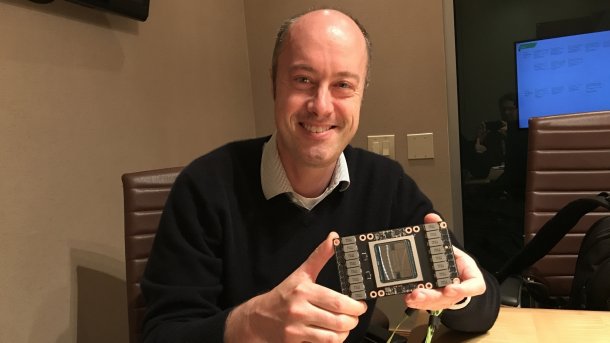

Ian Buck, Vice President of Accelerated Computing bei Nvidia

(Bild: Martin Fischer)

Nvidia hatte auf der GPU Technology Conference die künftige GPU-Generation Volta vorgestellt, die für Anwendungen im Bereich der Künstlichen Intelligenz (A.I./Deep Learning/Machine Learning) optimiert ist. Wir hatten auf der GTC die Möglichkeit, kurz mit Nvidias Vice President Ian Buck zu sprechen, der den Bereich Accelerated Computing verantwortet.

heise online: Welche Bedeutung wird Volta für den Supercomputing-Bereich haben?

Ian Buck: Volta ist die erste GPU, die sich gleichermaßen gut für High-Performance-Computing- und für AI-Anwendungen eignet; und dabei sowohl fürs Trainieren also auch fürs Inferencing neuronaler Netzwerke. Mittlerweile gibt es eine Vielzahl von GPU-beschleunigten HPC-Anwendungen, wir haben derzeit mehr als 450 auf dem Schirm.

(Bild: Martin Fischer)

Die Volta-GPU erreicht 7,5 TFlops an FP64-Rechenleistung für HPC und dank der neuen Tensor-Kerne bis zu 120 TFlops bei Deep Learning. Viele unserer Supercomputing-Kunden interessieren sich für eine Möglichkeit, Vorteile aus beiden Faktoren zu ziehen: Etwa physikalische Simulationen ablaufen zu lassen und sie mit künstlicher Intelligenz weiter zu beschleunigen – oder AI gar zum Analysieren der Ergebnisse zu verwenden.

Die Tensor-Kerne gehören zu der wichtigsten Neuerung im Volta-Design. Unabhängig davon scheint das Volta-Design im Vergleich mit Pascal altvertraut.

(Bild: Nvidia)

Volta gründet auf einer neuen Architektur. Wir haben bereits in die GPU-Architekturen Maxwell und Pascal Optimierungen für Deep-Learning-Berechnungen eingebracht. Pascal hatte wesentlich mehr FP16-Rechenleistung für das Inferencing neuronaler Netzwerke. Doch Volta bietet eine im Vergleich zu Pascal komplett neue Architektur.

Der Speicherausbau hat sich bei der Volta-Rechenkarte Tesla V100 im Vergleich zu vorherigen Generationen nicht erhöht – der HPC-Markt giert jedoch nach immer mehr Speicher. Wie passt das zusammen?

Klar, Speichergröße ist wichtig, doch auch die Transferrate. Wenn Sie die Rechenleistung erhöhen, müssen Sie auch die Transferrate erhöhen – deswegen ist Stacked-Speicher so bedeutend für HPC- und AI-Anwendungen. Ältere GPUs nutzten noch GDDR-Speicher; wir führten High Bandwidth Memory 2 mit Pascal ein. Auf dem Volta-Interposer sitzen vier HBM2-Stacks. Daten müssen zwischen GPU und Speicher nur noch wenige Milimeter zurücklegen was die Leistungsaufnahme auf ein Achtel reduziert und die Transferrate auf 900 GByte/s erhöht.

Die Speichergröße haben wir bei 16 GByte belassen, da unsere Analysen zum Training und Inferencing zeigten, dass die Größe in Kombination mit der hohen Transferrate ausreicht, um die GPU dauerhaft auslasten zu können.

(Bild: Martin Fischer)

Was lässt sich mit der höheren Rechenleistung bewerkstelligen?

Die höhere Rechenleistung erlaubt es Forschern, mit größeren neuronalen Netzen arbeiten. Das könnte zu neuen Diensten führen, die so bisher nicht möglich waren.

Im Bereich der Bild- und Spracherkennung gibt es bereits K.I.-Anwendungen mit übermenschlichen Fähigkeiten. In der Echtzeit-Sprachübersetzung steckt aber noch viel Potenzial – solche Netzwerke sind jedoch äußerst komplex: Sie sind rund 10 Mal größer als Bilderkennungs-Netzwerke und brauchen zum Training sehr viel Zeit. Volta kann für solche Netzwerke zumindest das Inferencing in Echtzeit stemmen – ein typischer CPU-Server wäre damit überfordert.

| Tesla K40 | Tesla M40 | Tesla P100 | Tesla V100 | |

| GPU | GK110 (Kepler) | GM200 (Maxwell) | GP100 (Pascal) | GV100 (Volta) |

| SMs | 15 | 24 | 56 | 80 |

| TPCs | 15 | 24 | 28 | 40 |

| FP32 Cores / SM | 192 | 128 | 64 | 64 |

| FP32 Cores / GPU | 2880 | 3072 | 3584 | 5120 |

| FP64 Cores / SM | 64 | 4 | 32 | 32 |

| FP64 Cores / GPU | 960 | 96 | 1792 | 2560 |

| Tensor Cores / SM | -- | -- | -- | 8 |

| Tensor Cores / GPU | -- | -- | -- | 640 |

| GPU Boost Clock | 810/875 MHz | 1114 MHz | 1480 MHz | 1455 MHz |

| Peak FP32 TFLOP/s* | 5,04 | 6,8 | 10,6 | 15 |

| Peak FP64 TFLOP/s* | 1,68 | 2,1 | 5,3 | 7,5 |

| Peak Tensor Core TFLOP/s* | -- | -- | -- | 120 |

| Texture Units | 240 | 192 | 224 | 320 |

| Memory Interface | 384-bit GDDR5 | 384-bit GDDR5 | 4096-bit HBM2 | 4096-bit HBM2 |

| Memory Size | Up to 12 GB | Up to 24 GB | 16 GB | 16 GB |

| L2 Cache Size | 1536 KB | 3072 KB | 4096 KB | 6144 KB |

| Shared Memory Size / SM | 16 KB/32 KB/48 KB | 96 KB | 64 KB | Configurable up to 96 KB |

| Register File Size / SM | 256 KB | 256 KB | 256 KB | 256KB |

| Register File Size / GPU | 3840 KB | 6144 KB | 14336 KB | 20480 KB |

| TDP | 235 Watts | 250 Watts | 300 Watts | 300 Watts |

| Transistors | 7.1 billion | 8 billion | 15.3 billion | 21.1 billion |

| GPU Die Size | 551 mm² | 601 mm² | 610 mm² | 815 mm² |

| Manufacturing Process | 28 nm | 28 nm | 16 nm FinFET+ | 12 nm FFN |

(mfi)