MetaMind-KI fasst Texte zusammen

Salesforce MetaMind hat ein KI-Verfahren vorgestellt, das automatisiert Texte zusammenfasst. Der neue Ansatz kombiniert rekurrente neuronale Netze mit zwei Aufmerksamkeitsfunktionen und Reinforcement-Learning. Das funktioniert besser als frühere Systeme.

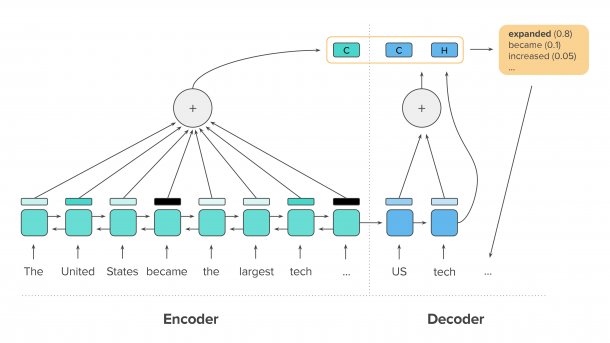

Die Ausgabe des Decoder LSTM (H) kombiniert das Netzwerk mit zwei Kontextvektoren (C) der Aufmerksamkeitsfunktionen. Die Ausgabe gibt Wahrscheinlichkeiten für das nächste Wort an.

(Bild: Salesforce MetaMind)

KI-Verfahren, die Texte zusammenfassen gibt es schon länger. Man hat außerhalb der Forschung aber wenig damit zu tun, weil die Verfahren bislang zu viele Fehler gemacht haben, um sie für reale Probleme einzusetzen. Salesforce hat jetzt aber ein Verfahren vorgestellt, das erheblich bessere Zusammenfassungen schreibt. Die neue KI könnte in einfachen Fällen gut genug für den praktischen Einsatz sein.

Rekurrente neuronale Netze

Der Salesforce-Algorithmus liest zunächst die Quelle Wort für Wort mit zwei rekurrenten neuronalen Netzen vom Typ LSTM (Long-Short-Term-Memory). Das erste Netz liest von vorne nach hinten, das zweite von hinten nach vorne. Die Netze geben für jedes Wort einen Vektor aus, der als interne Repräsentation der Bedeutung des Textes an dieser Stelle dient (Encoder). Einen ganz ähnlichen Ansatz verfolgt auch Google Translate.

Die interne Repräsentation des letzten Wortes verwendet ein drittes LSTM (Decoder) als Eingabe. Dieses Netz berechnet eine Wahrscheinlichkeitsverteilung, welches Wort zur Repräsentation passt. Das Wort mit der höchsten Wahrscheinlichkeit bildet das erste Wort der Zusammenfassung. Mit dem internen Zustand des gewählten Wortes schreibt es dann in jedem Schritt ein weiteres Wort.

Damit es dabei nicht zu Wiederholungen kommt, gewichtet eine Aufmerksamkeitsfunktion die Ausgaben des Decoders so, dass bereits Geschriebenes abgewertet wird. Eine zweite Aufmerksamkeitsfunktion ordnet Wörter der Zusammenfassung Wörtern aus der Quelle zu. Diese Funktion merkt sich, welche Wörter der Quelle bereits Aufmerksamkeit erhalten haben, und wertet deren Einfluss ab. Dieser Mechanismus hilft dem Decoder, möglichst viele Teile der Quelle in der Zusammenfassung zu beachten.

Lernen wie in Spielen

Um das System zu trainieren brauchen die neuronalen Netze ein Lernsignal. Der übliche Ansatz würde alle Ausgaben des Netzes abwerten, die nicht einem als korrekt eingestuften Beispiel entsprechen. Es könnten aber durchaus verschiedene Formulierungen einen Text gleich gut zusammenfassen. Salesforce wollte dem Netz deshalb mehr Freiheit lassen und bewerteten stattdessen ganze Texte mit dem ROUGE-Algorithmus (Recall-Oriented Understudy for Gisting Evaluation). Da dem Netz dann aber nicht zu jedem Schritt ein Lernsignal zur Verfügung steht, verwendeten die Forscher Reinforcement-Learning, wie es beispielsweise bei KIs eingesetzt wird, die Computerspiele spielen.

Das Paper erläutert, dass das Optimieren des ROUGE-Werts leider zu einem kaum lesbaren Text führt. Um dieses Problem zu beheben, kombinierten die Forscher beide Lernverfahren und akzeptierten einen etwas geringen ROUGE-Wert zugunsten der Lesbarkeit.

Noch nicht perfekt

Die Lesbarkeit und vor allem das Erhalten des Sinnzusammenhangs funktionieren noch nicht perfekt. Der Blogpost zitiert auch einige Beispiele, in denen Schwächen des Systems deutlich werden: So entgeht der KI beispielsweise eine verklausulierte Verneinung, sodass die Zusammenfassung das Gegenteil dessen behauptet, was in der Quelle stand. An anderer Stelle fehlen wichtige Informationen. Bis die KI beliebige Texte zusammenfasst, sollte sie also besser noch dazulernen. (pmk)