Gesichtserkennung funktioniert am besten bei weißen Männern

Algorithmen identifizieren das Geschlecht einer abgebildeten Person - arbeiten aber nicht ausgewogen. Männer mit heller Hautfarbe erzielen die besten Ergebnisse, hat eine wissenschaftliche Studie am MIT herausgefunden.

Das Projekt Gender Shades untersuchte, wie erfolgreich Gesichtserkennungssoftware bei Geschlecht und Hautfarbe arbeitet. Weiße Männer bilden das Ausgangsmuster - Schwarze und Frauen werden oft nicht erkannt.

(Bild: Gender Shades / MIT Media Lab (Screenshot aus Video))

Eine Untersuchung am MIT Media Lab hat bestätigt, was schon oft kritisiert wurde: Algorithmen für das Erkennen von Menschen arbeiten aufgrund ihrer einseitigen Lernbasis meist unausgewogen: Bei der Diversität hinsichtlich Geschlecht und Hautfarbe versagen sie auffallend deutlich bei schwarzen Menschen und speziell bei schwarzen Frauen, wie die New York Times berichtet.

Maßgabe ist "männlich, helle Haut"

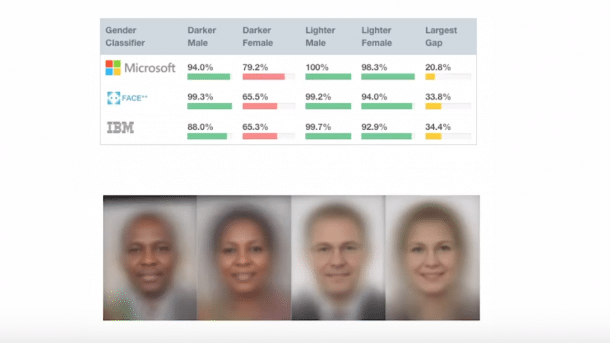

Im Rahmen des Gender Shades Project erstellten die Wissenschaftlerin Joy Buolamwini vom MIT und Timnit Gebur von Microsoft Research ein Set von 1270 Politikergesichtern aus unterschiedlichen Ländern und Kontinenten. Anschließend legten sie diese Bilddaten der Gesichtserkennungssoftware von IBM, Microsoft und Face++ des chinesischen Unternehmens Megvii vor und ließen lediglich das Geschlecht der dargestellten Person bestimmen.

Dabei zeigte sich, dass alle Systeme Bilder von Männern mit heller Hautfarbe zu nahezu 100 Prozent korrekt erkannten. Frauen mit heller Hautfarbe erkannte die Software zu etwa 93 Prozent. Lediglich 82 Prozent Trefferquote erzielten Bilder dunkelhäutiger Männer, und bei dunkelhäutigen Frauen lag die Quote sogar nur bei 65 Prozent. In einem Video schildert Buolamwini Entstehung und Ergebnisse ihrer Arbeit und zeigt Beispiele, bei denen Erkennungssoftware versagt.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes Video (TargetVideo GmbH) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (TargetVideo GmbH) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Unausgewogene Algorithmen mit weitreichenden Folgen

Das Ergebnis wirft ein Licht auf die Umstände, unter denen solche Algorithmen entstehen und geprüft werden: Die Datenbasis, mit denen der Lernprozess angestoßen wird, ähnelt tendenziell dem Umfeld der Entwickler, und Tests verlaufen zufriedenstellend, solange Personen aus diesem Umfeld ausreichend korrekt erkannt werden. Gesichtserkennungssoftware aus Europa und Nordamerika etwa erzielt dementsprechend bei weißen Männern die besten Erkennungsraten.

Problematisch werden solche unausgewogenen Algorithmen vor allem dann, wenn ihr praktischer Einsatz weitreichende Folgen haben kann. So beurteilt beispielsweise eine Justiz-Software die Rückfallwahrscheinlichkeit von Straftätern in den USA und benachteiligt dabei systematisch Afroamerikaner. In Deutschland will die Polizei Algorithmen zur "vorausschauenden Polizeiarbeit" einsetzen und Straftaten unterbinden. Das Bundesjustizministerium ist allerdings zu der Einsicht gelangt, dass der Staat KI-Algorithmen prüfen und im Bedarfsfall Diskriminierung unterbinden müsse. (tiw)