FOSDEM: Drei Freiheiten für ethisch-vertretbare KI

Freiheiten bei der Benutzung unserer Software sind nicht mehr genug, wir brauchen Freiheiten in der Art, wie Software, die andere nutzen, unser Leben bestimmt.

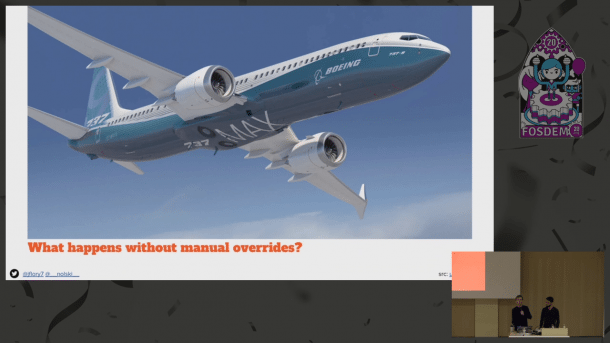

Boeings MCAS-Software ist das Paradebeispiel für fehlende menschliche Kontrolle über maschinengesteuerte Prozesse

(Bild: Fabian A. Scherschel)

In Brüssel hat die diesjährige FOSDEM, das alljährliche Treffen der europäischen Open-Source-Gemeinde, begonnen. Der Trend zur zunehmenden Politisierung der Konferenz, den man schon im vergangenen Jahr beobachten konnte, scheint sich auch dieses Mal fortzusetzen. Eine besondere Stoßrichtung bei den etwas philosophischeren Themen dieses Jahr ist dabei der Einfluss von freier Software auf künstliche Intelligenz. Open-Source-Software dominiert nicht nur den Sever-Markt und damit die Cloud, sondern indirekt auch viele neue Technologien wie KI. Dabei stellt sich die Frage danach, wie Entwickler und Nutzer sicherstellen können, dass ihre ethischen Grundsätze nicht verletzt werden, wenn Software immer mehr unseres alltäglichen Lebens kontrolliert.

Software steckt mittlerweile überall und entscheidet immer öfter auch über Leben und Tod. Ein bekanntes Beispiel sind selbstfahrende Autos, die entscheiden müssen, ob der Passagier oder ein auf die Fahrbahn gelaufener Fußgänger beim Unfall ums Leben kommt. Aktuell sind auch die Diskussionen über die Software Maneuvering Characteristics Augmentation System (MCAS), welche zwei Flugzeuge des Typs Boeing 737 MAX abstürzen lies und hunderten Passagieren das Leben kostete. Und in den USA werden bereits Polizeieinsätze an Hand von Algorithmen geplant, die voraussagen, wo das nächste Verbrechen stattfinden wird. Wie kann die Open-Source-Gemeinde es schaffen, ihre ethischen Vorstellungen im Angesicht dieser Entwicklungen – die zum Teil auch durch Open-Source-Software mit möglich gemacht wurden – umzusetzen und einen Einfluss auf diese gesellschaftlichen Tendenzen auszuüben?

Die drei Freiheiten

Als Antwort auf diese Frage schlagen die beiden Software-Entwickler und Ethik-Forscher Justin W. Flory und Michael Nolan das Konzept der drei Freiheiten für KI-Systeme vor. Dieses orientiert sich an Richard Stallmans vier Freiheiten der freien Software, mit der, so Flory und Nolan, die Software-Entwicklergemeinde bis heute viel Erfolg gehabt habe. Sie wollen mit ihren drei KI-Freiheiten ähnlich gutes für die Gesellschaft bewegen. Die von ihnen in ihrem FOSDEM-Vortrag vorgeschlagenen Freiheiten sind die folgenden:

1. Die Freiheit, maschinengemachte Entscheidungen zu verstehen: Diese Maxime soll Menschen, die von KI-Entscheidungen betroffen sind, in die Lage versetzen zu verstehen, wie die KI zu dieser Entscheidung gelangt ist. Dieses Konzept geht über die Einsicht des entsprechenden Quellcodes (wie ihn etwa Stallmans Freiheiten verlangen) hinaus, da zu einem KI-System auch immer Trainingsdaten gehören. Betroffene sollten ebenfalls die Möglichkeit haben, die Entscheidungsprozesse der Programmierer nachzuvollziehen. Die beiden Forscher verlangen Antworten auf Fragen wie "warum entscheidet dieses selbstfahrende Auto in dieser Situation auf diese Weise?" Diese erste Freiheit bildet das Fundament für das Verständnis der folgenden Maximen.

2. Die Freiheit, Entscheider für ihre Systeme zur Rechenschaft zu ziehen: Personen und Organisationen, die KI-Systeme bauen, sollten für die Entscheidungen, die diese Systeme treffen, zur Rechenschaft gezogen werden können. Da Erfinder und Hersteller von diesen Systemen profitieren, haben sie im Umkehrschluss auch eine Verantwortung gegenüber denen, deren Daten sie nutzen. Dabei geht es natürlich nicht nur um Fragen zu Leben und Tod, sondern zum Beispiel auch um Systeme, die Werbung personalisieren oder Bewerbungen auf Jobangebote vor sortieren. Bei tödlichen Unfällen wie im Fall von MCAS gewinnt diese Freiheit natürlich besondere Bedeutung.

3. Die Freiheit, KI-Entscheidungen anzufechten: Betroffene sollten maschinengemachte Entscheidungen immer anfechten können und diese Fälle sollten von Menschen bearbeitet werden. Da kein Entscheidungsprozess jemals perfekt ist (uns fehlen immer an irgendeinem Punkt Daten), ist es laut der beiden Forscher besonders wichtig, dass menschliche Empathie im Spiel ist. Die puren Daten eines Lebenslaufes sagen nicht alles über den Bewerber auf eine Stelle aus, deswegen gibt es das persönliche Gespräch, in dem er sich auf persönlicher Ebene erklären kann. Eine solche Vorgehensweise sollte, so Flory und Nolan, bei allen KI-Prozessen mit eingebaut werden. Ähnlich wie es zum Beispiel Berufungsprozesse in Gerichtsverfahren gibt.

Standardisierung als entscheidender Faktor

Flory und Nolan wollen eine Diskussion über die von ihnen vorgeschlagenen drei Freiheiten anregen. Die noch junge Bewegung derer, die sich mit Ethik in der KI auseinandersetzen, brauche einen Standard, so ihr Argument. Erst mit einem solchen Konsens könne man anfangen, Druck auszuüben. Die Copyleft-Bewegung habe das anhand von Stallmans Freiheiten vorgemacht: Erst mit dieser Standardisierung sei es möglich geworden, die Werte, die dort kodifiziert wurden, zu verteidigen und gegenüber großen Organisationen durchzusetzen. Das wiederum habe im Gegenzug gesellschaftliche Fakten geschaffen, die heute allgemein anerkannt sein.

Wenn es um Leben und Tod ginge, sei besonders die dritte Freiheit wichtig. Ein Fehlen einer solchen direkten Möglichkeit, die Software-Logik anzufechten sei den Passagieren der Boeing 737 MAX zum Verhängnis geworden. Wie so etwas funktionieren könne, zeige zum Beispiel der Autopilot des Fahrzeugherstellers Tesla: Berührt der Fahrer hier das Steuer oder eins der Pedale, wird die Software sofort abgeschaltet. Dieser manuelle Override sei eine direkte technische Umsetzung der Freiheit, KI-Entscheidungen zu überstimmen. Die beiden Forscher sind dabei nicht die einzigen, die einen solchen Kill Switch fordern. Mitte des vergangenen Jahres bereits hatten Experten der US-amerikanischen Verbraucherschutzorganisation Consumer Watchdog in einer Studie ein universelles Bekenntnis zu solchen Not-Aus-Schaltern für Software-Systeme gefordert.

Freiheiten müssen erkämpft werden

Die Etablierung solcher Freiheiten ist laut den beiden Forschern allerdings nur der erste Schritt. Als nächstes müsse sich die Entwickler-Gemeinde überlegen, wie diese Freiheiten umzusetzen sein. Als Software-Entwickler denke man da zu aller erst einmal an Lizenzen – sowohl für Quellcode als auch für Daten. Das sei aus der Erfahrung mit Stallmans Freiheiten und der daraus entstandenen Gründung der Free Software Foundation (FSF) auch verständlich. Lizenzen und darauf aufbauend die rechtliche Durchsetzung solcher Lizenzen seien ein Weg, mehr Ethik im Umgang mit künstlicher Intelligenz durchzusetzen. Allerdings müsse man dabei beachten, dass man nicht zu viele neue Lizenzen auf den Markt werfe. Diese Art der License Proliferation sei aus guten Gründen verpönt und müsse vermieden werden, um das ganze Themenfeld nicht so unübersichtlich zu machen, dass niemand mehr etwas damit zu tun haben wolle.

Weitere Möglichkeiten, das anvisierte Ziel zu erreichen sei staatliche Regulierung. Die DSGVO habe vorgemacht, wie der lange Arm des Gesetzgebers handfeste Änderungen im Verhalten der Allgemeinheit durchsetzen könne. Regulierungsbehörden würden sich bereits für das Thema interessieren, sagen Flory und Nolan. Allerdings sei dieser Prozess langwierig und die Ergebnisse leider oft stark lokal begrenzt – da Gesetze immer nur in bestimmten Regionen gelten. Eine andere Option sei unabhängige Zertifizierung. Hier könne man niemanden zwingen, bestimmte Regeln einzuhalten, aber solche sichtbaren Siegel auf Produkten könnten trotzdem Druck im Markt ausüben. Wenn die Gesellschaft von der Wichtigkeit des gemeinsamen Ziels überzeugt sei, hätten Firmen gute Gründe sich freiwillig bestimmten Regeln zu unterwerfen um sich durch ein Gütesiegel von ihren Mitbewerbern abzugrenzen. Und zuletzt schlagen die Forscher noch vor, dass Mitarbeiter in Firmen von unten herauf entsprechende Änderungen an den Produkten des Unternehmens erwirken – zum Beispiel durch gewerkschaftlichen Druck.

Ob sich eine solche Bewegung für mehr Ethikbewusstsein in Software, die zunehmend unser tägliches Leben bestimmt, durchsetzen kann und wie sie sich durchsetzt, wird sich zeigen müssen. Die Stoßrichtung, die Flory und Nolan vorgegeben haben, ist allerdings gut und richtig. Und ihre Ideen sorgen ohne Frage bereits für viel Diskussionen und Gesprächsstoff unter den Open-Source-Experten in Brüssel. (fab)