Nvidias GPU-Generation Ampere: Fast 7000 Kerne und 40 GByte RAM

Nvidias neue GPU-Generation Ampere bringt viel Performance für Rechenzentren, aufgewertete Tensor Cores mit FP64-Support und besonders schnelle Transferraten.

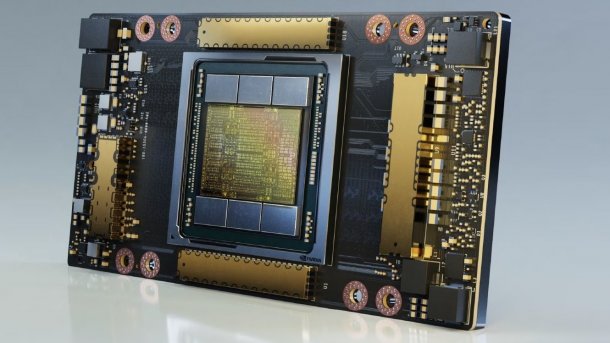

Nvidias neue GPU-Generation Ampere A100

(Bild: Nvidia)

Nvidia hat seine neue GPU-Generation "Ampere" vorgestellt – diesen Codenamen pfiffen schon seit dem Jahr 2017 die Spatzen von den Dächern. Ampere übertrifft seinen Vorgänger "Volta" bei der Anzahl und Funktion der Recheneinheiten und soll vor allem Berechnungen zur Künstlichen Intelligenz erheblich beschleunigen.

Als ersten Chip der neuen Reihe lässt Nvidia den A100 vom Stapel, eine Art GPU-Supertanker, der für den Einsatz in Supercomputern und großen Rechenzentren ausgelegt ist und im Speziellen auf aufwendige KI-Berechnungen zielt. A100 ist keine GPU fürs Gaming, entsprechend abgespeckte Chips könnte Nvidia im Laufe des Jahres aber noch vorstellen.

Fast 7000 Kerne

Dank des modernen 7-nm-Fertigungsverfahrens konnte Nvidia die Transistoren-Packdichte im Vergleich zum 12-nm-Vorgänger Volta deutlich erhöhen: So besteht der 826 mm² große A100 aus 54 Milliarden Transistoren, der 815 mm² große Volta aus "nur" 21,1 Milliarden Transistoren. Nvidia setzt auf den taiwanischen Auftragsfertiger TSMC.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes Video (TargetVideo GmbH) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (TargetVideo GmbH) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Die Anzahl der Streaming-Multiprozessoren (SM) steigt allerdings nicht in ebenjenem Verhältnis. A100 kommt laut Nvidia-Chef Jensen Huang auf 108 SMs (Volta 80 SMs), die wie bei Volta jeweils 64 FP32-Kerne für Berechnungen mit einfacher Genauigkeit und 32 FP64-Kerne für doppelte Genauigkeit enthalten. Insgesamt stecken im A100 also 6912 FP32- und 3456 FP64-Kerne. Dazu kommen 40 GByte HBM2-Speicher von Samsung mit einer Transferrate von 1,6 TByte/s.

| A100 (SXM) | Tesla V100 | Tesla P100 | Tesla M40 | Tesla K40 | |

| GPU | A100 (Ampere) | GV100 (Volta) | GP100 (Pascal) | GM200 (Maxwell) | GK110 (Kepler) |

| SMs | 108 | 80 | 56 | 24 | 15 |

| TPCs | 54 | 40 | 28 | 24 | 15 |

| FP32 Cores / SM | 64 | 64 | 64 | 128 | 192 |

| FP32 Cores / GPU | 6912 | 5120 | 3584 | 3072 | 2880 |

| FP64 Cores / SM | 32 | 32 | 32 | 4 | 64 |

| FP64 Cores / GPU | 3456 | 2560 | 1792 | 96 | 960 |

| Tensor Cores / SM | 4 | 8 | -- | -- | -- |

| Tensor Cores / GPU | 432 | 640 | -- | -- | -- |

| GPU Boost Clock | k.A. | 1455 MHz | 1480 MHz | 1114 MHz | 810/875 MHz |

| Peak FP32 TFLOPS | 19,5 | 15 | 10,6 | 6,8 | 5,04 |

| Peak FP64 TFLOPS | 9,7 | 7,5 | 5,3 | 2,1 | 1,68 |

| Peak Tensor Core TFLOPS | 156 (TF32) / 312 (TF32 Structural Sparsity) | 120 (Mixed Precision) | -- | -- | -- |

| Speicher | HBM2 | 4096-bit HBM2 | 4096-bit HBM2 | 384-bit GDDR5 | 384-bit GDDR5 |

| Speichergröße | 40 GByte | 16 GByte | 16 GByte | bis zu 24 GByte | bis zu 12 GByte |

| TDP | 400 Watt (SXM) | 300 Watt | 300 Watt | 250 Watt | 235 Watt |

| Transistoren (Mrd.) | 54 Mrd. | 21,1 Mrd. | 15,3 Mrd. | 8 Mrd. | 7,1 Mrd. |

| GPU Die Size | 826 mm² | 815 mm² | 610 mm² | 601 mm² | 551 mm² |

| Fertigung | 7 nm | 12 nm FFN | 16 nm FinFET+ | 28 nm | 28 nm |

Verbesserte Tensor Cores und Multi-Instancing

Aufgebohrt hat Nvidia die Tensor Cores, einst mit Volta im Jahr 2017 eingeführt, nun in dritter Generation. Sie unterstützen erstmals Berechnungen mit doppelter Genauigkeit, die etwa für aufwendige Simulationen zur Nuklearfusion, Molekülidentifizierung und Erdbebenvorhersage notwendig sind. Nvidia zufolge erreicht eine A100-GPU dabei eine Rechenleistung von bis zu 19,5 TFlops. Über das neue TensorFloat32-Format (TF32) sollen KI-Trainings-Berechnungen bei geringerer Genauigkeit schneller vonstatten gehen – Nvidia spricht von einer um bis zu 20-fachen Beschleunigung gegenüber Volta, dessen Tensor Cores dieses Format jedoch nicht beherrschen. Sparse Matrix Operations sollen über die Tensor Cores bis zu doppelt so schnell ablaufen (Sparsity Acceleration); unterstützt werden dabei die Formate TF32, FP16, BFLOAT16, INT8 und INT4.

Jeder A100 lässt sich in bis zu sieben GPUs partitionieren (Multi-Instance GPU), was etwa für Elastic Datacenter interessant ist. Jede A100-Partition wäre laut Nvidia dabei so leistungsfähig wie ein Volta-V100-Chip. Bei welchen Anwendungen genau ließ Nvidia allerdings offen. Über NVLink 3.0 können verschiedene A100-Chips untereinander mit 600 GByte/s kommunizieren – im Vergleich mit NVlink 2.0 also doppelt so schnell. Ein neuer NVSwitch erlaubt die Verbindung mehrerer GPUs mit voller NVLink-3.0-Geschwindigkeit.

(Bild: Nvidia)

Schneller A100-Server für viel Geld

Als erstes Ampere-System kündigte Nvidia auch einen neuen Deep-Learning-Server mit acht A100-GPUs an. Der "DGX A100" soll damit bis zu 5 Tensor-Petaflops bei Berechnungen mit halber Genauigkeit (FP16) erreichen, bei TF32 immerhin noch 2,5 PFlops, bei FP64 noch 156 TFlops. Außerdem stecken im System zwei 64-Kern-Prozessoren der AMD-Rome-Serie, 1 TByte Arbeitsspeicher, 15 TByte SSD-Speicher (NVMe Gen4) sowie neun Mellanox-Netzwerkkarten des Typs ConnectX-6 VPI mit jeweils 200 GBit/s. Nvidia verlangt für die DGX A100 einen Preis von 199.000 US-Dollar – der Volta-Server DGX-1 ging 2017 zum Preis von 149.000 US-Dollar in den Verkauf.

Zu den ersten Abnehmern beziehungsweise Nutzern von A100-GPUs zählen das Jülich Supercomputer Centre (Supercomputer JUWELS), das Rechenzentrum Garching der Max-Planck-Gesellschaft (Raven), das Karlsruhe Institute of Technology (HoreKa), das U.S. Department of Energy’s National Energy Research Scientific Computing Center im Lawrence Berkeley National Laboratory (Perlmutter) und die Indiana University (Big Red 200). (mfi)