Grace: Nvidias erster ARM-Prozessor für Supercomputer

Grace nutzt ARM-Neoverse-Rechenkerne sowie schnelle NVLink-Interconnects und LPDDR5X-Speicher für hohe Transferraten.

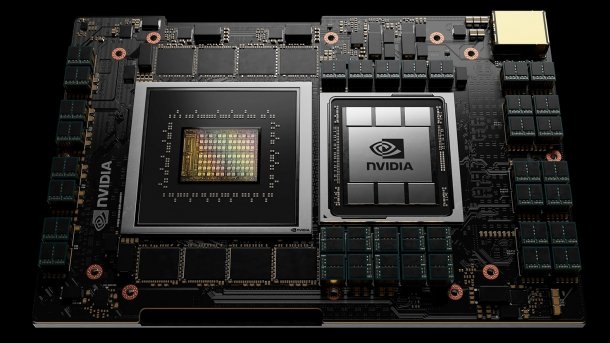

Nvidia Grace

(Bild: Nvidia)

Nvidia hat den ersten eigenen ARM-Prozessor für High Performance Computing und Künstliche Intelligenz vorgestellt. Mit dem Namen "Grace" verweist Nvidia laut CEO Jensen Huang auf die US-amerikanische Computerpionierin Grace Hopper. In der GPU-Gerüchteküche galt deren Nachname "Hopper" zuletzt als Kandidat für die Bezeichnung des Chips. Nvidia übernimmt derzeit den CPU-Entwickler ARM.

Grace soll ab Anfang 2023 verfügbar sein und in Supercomputer-Systemen Verwendung finden – wie beispielsweise im Alps-Supercomputer des Swiss National Supercomputing Center. Huang zufolge soll in Alps auch die nächste Generation von Nvidia-Rechenbeschleunigern zum Einsatz kommen. Seit einiger Zeit ist Nvidias Rechenbeschleuniger-Programmierplattform CUDA auch auf Servern mit ARM-Prozessoren nutzbar. Nvidia bereitet das eigene HPC-SDK sowie die CUDA-/CUDA-X-Bibliotheken für Grace vor.

Empfohlener redaktioneller Inhalt

Mit Ihrer Zustimmung wird hier ein externes Video (TargetVideo GmbH) geladen.

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit können personenbezogene Daten an Drittplattformen (TargetVideo GmbH) übermittelt werden. Mehr dazu in unserer Datenschutzerklärung.

Alps wird von Hewlett Packard Enterprise auf Cray-EX-Basis gebaut und ersetzt den bisherigen Piz-Daint-Supercomputer.

Grace mit ARM Neoverse

Nvidia Grace setzt auf ARM-Kerne aus der für Server ausgelegten Familie Neoverse, die über 300 Punkte beim Benchmark SPECrate2017_int_base erzielen sollen.

[Update:] Das entspricht ungefähr der Integer-(Ganzzahl-)Rechenleistung, die auch 32 x86-Prozessorkerne von AMD (2x Epyc 7313, Zen 3) oder 48 ältere Intel-Kerne (2x Xeon Gold 6240R, Cascade Lake) liefern. Bei der KI-Rechenleistung – also vermutlich bei der Verarbeitung von BFloat16- oder INT8-Daten – soll Grace aber um den Faktor 10 schneller sein als "heutige Serverprozessoren". Allerdings seit Grace für eine "Nische" gedacht und nicht für allgemeine Serveranwendungen. [/Update]

Neoverse-Kerne kommen beispielsweise auch bei Amazons Graviton2-Prozessoren und Altra-Max-Prozessoren von Ampere zum Einsatz sowie im künftigen EU-Prozessor Rhea.

Videos by heise

Die Architektur von Grace soll für besonders hohe Transferraten sorgen – diese sind beim verteilten Rechnen über mehrere Instanzen von zentraler Bedeutung. Zugreifen können die Grace-Kerne auf ECC-geschützten LPDDR5x-Speicher, der besonders hohe Transferraten von über 500 GByte/s erreichen soll.

Mit anderen Grafikprozessoren kommuniziert Grace über schnelle, Cache-kohärente Interconnects – Nvidia zufolge sind über die vierte NVLink-Generation CPU-zu-(Nvidia-)GPU-Transferraten von 900 GByte/s möglich; von CPU zu CPU noch 600 GByte/s.

(Bild: Nvidia)

CUDA-Code-Portierung

Mithilfe des Nvidia HPC SDK sollen Wissenschaftler und Entwickler ihre HPC- und KI-Software auf GPU-beschleunigte ARM-Systeme migrieren können. Um solche Migrationen schon zu starten, bevor Grace auf den Markt kommt, kündigte Nvidia gemeinsam mit Amazon EC2-Instanzen in der AWS-Cloud mit Graviton2-CPU und Nvidia-GPUs an.

Nvidia bietet Entwicklern außerdem ein ARM HPC Developer Kit an, das aus einer Ampere-Altra-CPU mit 80 ARM-Neoverse-Kernen (bis 3,3 GHz), zwei Nvidia A100-GPUs (624 FP16-TFlops) und zwei BlueField-2-DPUs besteht.

(mfi)