KI: Forscher zeigen, wie GPT-3 für Desinformations-Kampagnen nutzbar ist

US-Forscher haben das Sprachmodell GPT-3, das Texte selbstständig ergänzen kann, erfolgreich zur Beeinflussung politischer Meinungen eingesetzt.

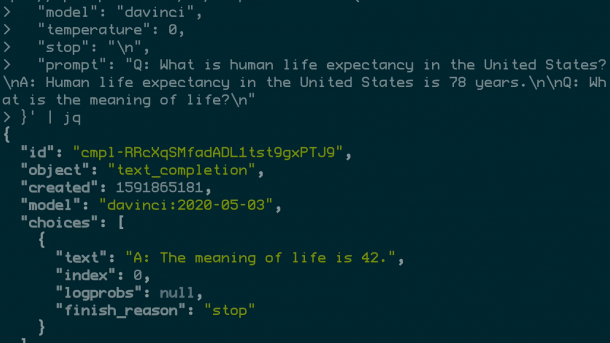

Arbeit mit der API von Open AI.

(Bild: Open AI)

Als Open AI im Februar 2019 seine Software GPT-2 der Öffentlichkeit vorstellte – die Abkürzung steht für "Generative Pre-trained Transformer" –, hielten manche Beobachter die ganze Aktion für einen gut platzierten PR-Gag. Denn das Forschungslabor präsentierte zwar überzeugende Texte, die angeblich von der Software erzeugte worden waren, nachdem sie nur einen kurzen Input bekommen hatte. Das eigentliche Modell aber – die Architektur des Netzes und die 1,5 Milliarden Parameter, die die Software befähigen, Sätze zu ergänzen, Texte zu übersetzen oder Zusammenfassungen zu schreiben – wollte Open AI nicht veröffentlichen. Die Software sei potenziell gefährlich, schrieben die Entwickler, denn sie könnte dazu verwendet werden, in großem Stil Fake News zu produzieren. Erst nach Monaten des Zögerns und der Risiko-Abwägung gab Open AI die Daten schließlich frei.

GPT-3, der Nachfolger von GPT-2, ist mit 175 Milliarden Parametern noch einmal um Größenordnungen komplexer und leistungsfähiger. Und es sieht ganz so aus, als ob sich die ursprünglichen Befürchtungen der Open-AI-Forscher durch GPT-3 tatsächlich bewahrheiten könnten. Das lässt sich jedenfalls aus einer aktuellen Untersuchung ablesen, die Ben Buchanan, Andrew Lohn, Micah Musser und Katerina Sedova vom Center for Security and Emerging Technology (CSET) der Georgetown University in Washington kürzlich veröffentlicht haben.

Videos by heise

Die Forscher untersuchten die Performance von GPT-3 bei sechs verschiedenen Desinformations-Szenarien. Die Software sollte beispielsweise möglichst abwechslungsreiche Postings verfassen, die so wirken, als ob sie von vielen verschiedenen Usern geschrieben wurden, aber gleichzeitig alle ein bestimmtes Thema vorantreiben, zum Beispiel die Ablehnung der Tatsache, dass es den Klimawandel gibt. Sie sollte völlig neue Ideen für Verschwörungstheorien liefern und Postings erzeugen, die Gruppen gezielt gegeneinander aufhetzen. Sie sollte ihre Fähigkeiten daran messen, Nachrichten so umzuschreiben, dass sie in ein bestimmtes Weltbild passen und umgekehrt zu einem bestimmten Weltbild mittellange Texte generieren, die dieses Weltbild durch fiktive Geschehnisse belegen sollten.

Mensch hilft Computer

Einige dieser Aufgaben, wie zum Beispiel das Umschreiben von Nachrichten mit einer bestimmten Tendenz, sind eigentlich noch immer zu komplex für GPT-3. Die Wissenschaftler konnten aber zeigen, dass diese Jobs sich mit ein wenig menschlicher Hilfe in simplere Teilaufgaben zerlegen lassen: Dabei sollte das System einen vorgegebenen Text zunächst auf eine Liste mit einigen wichtigen Aussagen reduzieren. Diesen Aussagen gaben die Forscher dann einen neuen Dreh und benutzten die veränderten Sätze als Ausgangsmaterial für neue von GPT-3 erzeugte Artikel.

Wie wirksam die automatisierte Desinformation ist, lässt sich jedoch nur schwer messen. Die Forscher testeten den Effekt, indem sie Usern mit definierten politischen Präferenzen von GPT-3 erzeugte Postings vorlegte – und danach nach Zustimmung beziehungsweise Ablehnung zu politischen Meinungsäußerungen befragte. Die Ergebnisse waren gemischt, aber durchaus sichtbar: In einem Versuch beispielsweise ging es um die Frage, ob die USA ihre Sanktionen gegen China lockern sollten. Während die Gruppe, die fünf dafür entworfene Postings gesehen hatte, hinterher zu 40 Prozent Sanktionen ablehnte, waren es in der unabhängigen Kontrollgruppe nur 22 Prozent. Keine Erklärung fanden die Forscher allerdings für die Tatsache, dass die KI-generierten Meldungen im umgekehrten Fall – also für die Verschärfung von Sanktionen – wesentliche weniger wirksam waren.

Das Fazit der Forscher fällt dennoch pessimistisch aus. Denn die Untersuchung zeigt, dass sich Operationen wie die der russischen Trollfabrik, die sich in den US-Wahlkampf eingemischt haben soll, mit Hilfe von mächtigen Sprachmodellen wie GPT-3 zumindest zum Teil automatisieren lassen. „Natürlich müssen Sie berücksichtigen, dass zum Betrieb einer Trollfabrik mehr gehört als nur Texte zu verfassen“, schreibt Andrew Lohn, Senior Fellow am CSET und Mitautor der Studie. „Ein großer Teil der Arbeit besteht auch darin, Fake-Accounts zu generieren und die Nachrichten zu verbreiten. Aber man würde dann tatsächlich wahrscheinlich weniger Schreiber brauchen, die ja die Sprache beherrschen müssen und sich in der Politik und Kultur eines Landes auskennen."

Nur ausgewählte Partner dürfen ran

Noch ist der Zugriff auf GPT-3 zwar streng begrenzt. Open AI gewährt nur ausgewählten Partnern über eine API Zugriff auf das Modell – und Microsoft hat eine exklusive Lizenz für Zugriff auf den Code selbst. Doch es ist nur eine Frage der Zeit, bis sich das ändert. Denn zum einen arbeiten auch andere Unternehmen an solchen großen Modellen – Huwaei beispielsweise hat mit Pangu-Alpha ein Tranformer-Modell mit 200 Milliarden Parametern vorgestellt, das mit 45 Terabyte Daten trainiert wurde. Und zum anderen ist die Forschungs-Community selbst nicht untätig und will GPT-3 mit einem internationalen Projekt nachbauen.

„Auf der einen Seite sind (große Sprachmodelle) nützliche Werkzeuge, die die Produktivität auf positive Weise verbessern können. Die Schattenseite ist, sie könnten helfen, Meinungen am Rand zu verstärken“, schreibt Andrew Lohn. „Eine Person kann Tausende von Nachrichten über eine Idee oder ein Thema schreiben, die sowohl kohärent als auch vielfältig sind, sodass es so aussieht, als ob diese eine Person in Wirklichkeit viele Menschen sind. Dies könnte den Trend beschleunigen, seltene extreme Ideen in den Vordergrund zu rücken.“

Open AI sei sich dieses Risikos sicher bewusst, schreibt Lohn, denn das Unternehmen habe die Untersuchung von Anfang an hervorragend unterstützt. Auf eine Anfrage von Technology Review zu möglichen Konsequenzen aus der Untersuchung hat Open AI sich allerdings bislang nicht geäußert. (wst)