iPhone-Scanning auf Kinderpornos: Apple nennt Abdrehmöglichkeit

Nach Kritik an der für iOS 15 und iPadOS 15 vorgesehenen Funktion hat der Konzern nähere Details genannt. Auch zum iMessage-Nacktscanner gibt es Neuigkeiten.

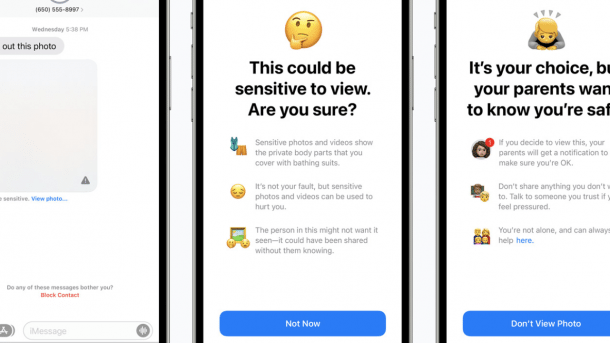

Kinderschutzfunktion in iOS 15, die auf Nacktbilder scannt.

(Bild: Apple)

Apple wird iPhones und iPads nur dann auf Missbrauchsinhalte scannen, wenn der iCloud-Foto-Upload aktiv ist. Das hat der Konzern nach teils heftiger Kritik an einer für iOS 15 und iPadOS 15 geplanten neuen Funktion zur Bekämpfung von Kinderpornos auf den Geräten klargestellt.

Gegenüber MacRumors hieß es in einer Stellungnahme, Apple könne bekannte CSAM-Inhalte (die in US-Fachkreisen übliche Abkürzung steht für "Child Sexual Abuse Material") nicht detektieren, wenn die iCloud-Foto-Funktion abgeschaltet ist. Der Konzern aktiviert diese allerdings defaultmäßig – genauso wie das nach wie vor nicht komplett verschlüsselten iCloud-Backup.

Videos by heise

Grenzwerte und ein "NeuroHash"

Der Konzern scannt Bilder lokal und gleicht sie mit einer Datenbank ab, die das US-Non-Profit National Center for Missing and Exploited Children (NCMEC) bereitstellt. Dank einer KI-Funktion namens "NeuroHash" sollen auch veränderte Aufnahmen erkannt werden. Das System schreibt dann sogenannte "Safety Voucher" in die Bilder, die anschließen in die iCloud hochgeladen werden. Überschreitet das hochgeladene Material einen bestimmten Grenzwert, kann Apple die "Safety Voucher" entschlüsseln, überprüft die Aufnahmen durch einen Mitarbeiter und informiert dann gegebenenfalls das NCMEC, das wiederum die Behörden einschaltet. Accounts mit so erkannten CSAM-Inhalten werden gesperrt.

Nutzer, die das CSAM-Scanning nicht wünschen – es soll offenbar anfangs nur in den Vereinigten Staaten von Amerika aktiv sein –, können also iCloud-Fotos abschalten. Kritische Sicherheitsforscher fürchten allerdings, dass Apple die Funktion später auf alle Bereiche des Systems – auch ohne iCloud-Upload – ausdehnen könnte. Es mache sonst keinen Sinn, eine solche Infrastruktur einzurichten, zumal Apple bereits Server-seitig auf Kinderpornos in iCloud scannt, wie dies auch Google, Microsoft oder Facebook tun.

Details zur Erkennung expliziter Inhalte

Weitere Details gibt es auch zu einer weiteren umstrittenen neuen Funktion: Einen "Nacktscanner" in iMessage. Das Feature soll künftig Kinder warnen, wenn sie "sexuell explizite Inhalte" erhalten oder versenden – gleichzeitig werden die Eltern informiert. Dabei wird ein erkanntes Bild zunächst unkenntlich gemacht und der Nachwuchs muss entscheiden, ob er es wirklich sehen möchte. Dann gibt es aber eine Benachrichtigung an die Erziehungsberechtigten.

Hier heißt es von Apple nun, dass dieses Scanning "nur für Kinder" gedacht ist. Zudem sollen besagte Benachrichtigungen nur an Eltern von Kindern gehen, die unter 13 Jahre alt sind. Eltern müssten zudem die "Communication Safety"-Funktion aktivieren, was wiederum über die Familienfreigabe läuft. Das System soll auch "intime Teile des Körpers" erkennen und vor einem Absenden warnen. "Es ist nicht Dein Fehler, aber sensible Fotos und Videos können verwendet werden, um Dich zu verletzen", heißt es in einem der Hinweise. Den Nacktscanner will Apple direkt in iMessage einbauen, also in iOS 15, iPadOS 15 sowie macOS 12 alias Monterey. (bsc)