Verneigen, umarmen, Hände schütteln: Roboter lernt nonverbale Signale

Koreanische Forscher haben ein KI-Modell entwickelt, das Roboter lernen lässt, wie Menschen miteinander umgehen.

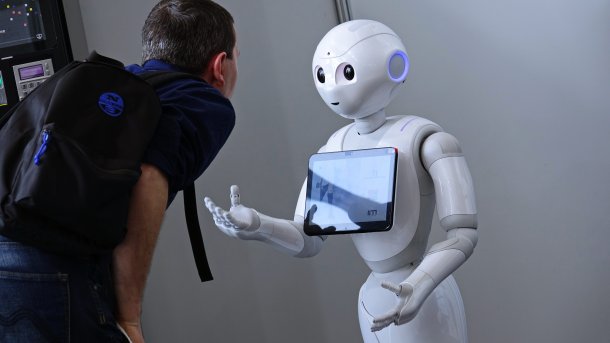

Roboter Pepper im Austausch mit einem Menschen.

(Bild: MikeDotta/Shutterstock.com)

Forscher des Electronics and Telecommunications Research Institute (ETRI) in Korea haben ein KI-Modell entwickelt, das Robotern dabei helfen soll, wortlos zu kommunizieren. Das auf Deep Learning basierende Modell lernt "kontextgerechte soziale Verhaltensweisen" wie Händeschütteln oder Umarmen, indem es die Interaktionen zwischen Menschen in Trainings-Videos betrachtet. Nach dem Training beobachtet der Roboter die Körperhaltung des mit ihm interagierenden Menschen mit einer 3D-Kamera und erzeugt mit Hilfe des Modells eine dazu passende, gelernte Pose.

Je mehr Roboter in das alltägliche Leben von Menschen vordringen, um so wichtiger wird es, dass die Maschinen tatsächlich von Menschen akzeptiert werden. Soziale Roboter sind speziell darauf ausgelegt, durch ihre Verhaltensweise Vertrauen erzeugen – wie genau das am besten funktioniert ist jedoch noch Gegenstand der Forschung. Es gibt zwar einzelne solcher Roboter wie zum Beispiel den Huggie-Bot, der Menschen in den Arm nehmen kann, so dass es sich für diese tatsächlich angenehm anfühlt. Bisher beschränkt sich das Repertoire dieser Maschinen aber auf einzelne Aktionen.

Körperhaltungen analysieren

Das von Woo-Ri Ko und Kollegen entwickelte Modell behandelt das Problem nun ähnlich wie eine Übersetzungs-Aufgabe: Eine Reihe von menschlichen Körperhaltungen muss übersetzt werden in eine dazu passende Sequenz von Roboter-Körperhaltungen, wobei der Roboter jeweils mit einer eigenen Pose auf eine menschliche Pose reagiert.

Videos by heise

Um zu verhindern, dass der Roboter unsinnige, oder gar bedrohliche Körperhaltungen produziert, haben die Forschenden noch ein zweites Modul an ihr Modell gebaut: Darin erzeugt ein generatives Netzwerk (GAN) aus der Antwort des Sequenz-Modells zunächst eine Geste für den Roboter, die dann aber von einem Diskriminator getestet wird. Erst wenn der Diskriminator feststellt, dass diese Geste den in den Trainingsbeispielen gelernten Aktionen hinreichend ähnlich ist, wird sie für den Roboter tatsächlich frei gegeben.

Die Forscher trainierten ihr Modell speziell darauf, anhand von Videos fünf nonverbale Verhaltensweisen für Roboter zu generieren: Verbeugen, Anstarren, Händeschütteln, Umarmen und Verdecken des eigenen Gesichts. Um zu testen, wie gut das funktioniert, ließen sie einen Pepper-Roboter in einer simulierten Umgebung mit einem Menschen agieren und maßen dabei die Abweichung der Roboter-Gesten von "Schlüssel-Gesten", die sie als besonders wichtig für die jeweilige Interaktion ansahen.

Die ersten Ergebnisse waren vielversprechend, denn das Modell generierte erfolgreich die fünf Verhaltensweisen, auf die es trainiert wurde – zu geeigneten Zeitpunkten. In nächsten Schritten wollen die Forschenden den Roboter jetzt auf weitere Verhaltensweisen trainieren und das Modell an einem realen Roboter "gegenüber verrauschten Eingabedaten" testen.

(wst)