Neue Art von Desinformation: Echte Fotos aus Israel laut Detektoren KI-generiert

Nach der jüngsten Eskalation im Gazakonflikt kursieren im Internet jede Menge blutiger Bilder. Teilweise stufen Onlinewerkzeuge echte Fotos als gefälscht ein.

(Bild: mapush/Shutterstock.com/heiseonline)

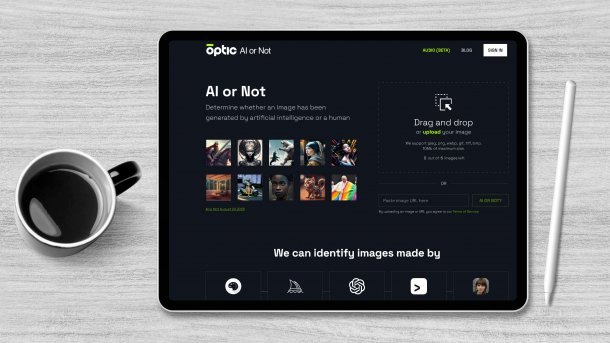

Onlinewerkzeuge, die automatisch erkennen können sollen, ob Bilder KI-generiert sind, bewerten aktuelle Fotos aus Israel und dem Gazastreifen falsch und führen damit eine "zweite Ebene an Desinformation" ein. Das berichtet das US-Magazin 404 Media und bezieht sich dabei vor allem auf ein Bild, das die verkohlte Leiche eines Babys zeigen soll, das bei der blutigen Attacke der Hamas getötet worden sein soll. Geteilt wurde das Bild unter anderem vom offiziellen Account Israels auf dem Kurznachrichtendienst X (vormals Twitter), dort und unter anderen Beiträgen mit dem Foto wird dann immer wieder darauf hingewiesen, dass das Portal AIorNot.com das Bild als KI-generiert einstuft. Dem widerspricht bei 404 Media ein Experte für Bildmanipulation.

Scharfe Kritik an Fälschungsvowurf

Dass soziale Netzwerke nach dem Angriff auf Israel mit gefälschten oder irreführenden Bildern zu der Eskalation regelrecht überschwemmt wurden, ist seit Tagen bekannt und hat bereits die EU-Kommission dazu bewogen, Antworten von X/Twitter, Meta und TikTok einzufordern. Die Problematik, dass einige echte Bilder als KI-generiert eingestuft und damit als Fälschungen bezeichnet werden, ist dabei eine neue Dimension eines älteren Problems. Israels Account auf X/Twitter hat den Vorwurf in Bezug auf das konkrete Bild der Babyleiche bereits mit Holocaustleugnung verglichen und Verbreiter als Antisemiten bezeichnet.

Videos by heise

404 Media hat sich die augenscheinliche Echtheit des Fotos von Hany Farid bestätigen lassen, der Professor an der Universität Kalifornien, Berkeley ist Experte für digital bearbeitete Bilder. Der verweist unter anderem auf die Schatten, auf Teile des Tischs und das Fehlen von Artefakten. Außerdem hätten seine eigenen Erkennungswerkzeuge das Bild als echt eingestuft. Darauf allein würde er sich aber nicht verlassen. Das Internet ist derweil voll von Diensten, die vorgeben, KI-generierte Werke erkennen zu können, ohne dass klar ist, wie sie funktionieren, schreibt 404 Media. Wenn ein solches Werkzeug wie im Fall eines Fotos von einem getöteten Journalisten angibt, dass das mit 52-prozentiger Wahrscheinlichkeit gefälscht sei, könne damit jedes beliebige Argument unterstützt werden.

(mho)